동적 카메라 영상을 위한 영상 스티칭 기반 프레임 보간 프레임워크

Copyright © 2025 Korean Institute of Broadcast and Media Engineers. All rights reserved.

“This is an Open-Access article distributed under the terms of the Creative Commons BY-NC-ND (http://creativecommons.org/licenses/by-nc-nd/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited and not altered.”

초록

영상 프레임 보간법은 실제 존재하는 프레임 두 장을 입력으로 받아, 존재하지 않는 가상의 중간 프레임을 만들어 영상의 초당 프레임 수(FPS)를 증가시키는 기술이다. 영상 프레임 보간법 중 하나인 광학 흐름(Optical Flow) 기반 프레임 보간 기법은 프레임 간에 픽셀의 이동성을 계산하여 가상의 중간 프레임에 대한 이동성을 예측함으로써 중간 프레임을 생성하는 기술이다. 이에 이전 프레임의 픽셀이 다음 프레임에서 나타나지 않거나 프레임 간에 이동성이 큰 경우에는 부정확한 광학 흐름이 예측되어 왜곡(Artifact)이 존재하는 보간 프레임이 생성될 수 있으며, 동적 카메라 환경에서는 영상 내 객체 픽셀만이 이동하는 것이 아니라 배경 픽셀 또한 이동성이 있기에 배경 영역에서도 왜곡이 발생할 수 있다. 한편, 다수의 영상을 합성하는 영상 스티칭 기술은 영상 내 객체의 이동성을 고려하지 않기에 객체 영역에서 시간 차이에 의한 고스트 현상(Ghost effect)이 나타날 수 있지만, 영상에서 추출한 특징점(Keypoint) 중에서 다수가 매칭되는 호모그래피(Homography)를 통해 영상을 합성하기에 시차(Parallax)가 작은 배경 영역은 왜곡이 적게 나타날 수 있다. 이에 본 논문에서는 배경 영역은 영상 스티칭 기술을 통해서 생성하고 객체 영역은 광학 흐름 기반 프레임 보간법을 통해 생성함으로써, 보간 프레임의 왜곡을 최소화할 수 있는 영상 스티칭 기반 프레임 보간법을 제안하고자 한다.

Abstract

The video frame interpolation method is a technology to increase the number of frames per second (FPS) of an image by taking two frames that actually exist as input and creating a virtual intermediate frame that does not exist. Optical flow-based frame interpolation, one of the video frame interpolation methods, is a technology that generates an intermediate frame by predicting the mobility for a virtual intermediate frame by calculating the mobility of pixels between frames. Therefore, if the pixels of the previous frame do not appear in the next frame or have high mobility between frames, inaccurate optical flow may be predicted and an interpolation frame with artifacts may be generated. In a dynamic camera environment, not only the object pixels in the image move, but also the background pixels are mobile, so various distortions may occur in the background area. On the other hand, since image stitching technology that synthesizes multiple images does not take into account the mobility of objects in the image, ghost effects caused by temporal differences may appear in the object area, but background areas with low parallax to synthesize images through homography, which matches many of the keypoints extracted from the image, have the advantage of less distortion. Therefore, this paper proposes a framework to reduce the distortion of the background area that appears in the frame interpolation process for dynamic camera images. The background area is composed of stitching techniques, and the object area is composed of optical flow-based frame interpolation.

Keywords:

Optical Flow, Frame Interpolation, Stitching, Temporal difference, ArtifactⅠ. 서 론

영상 프레임 보간법은 실제 존재하는 프레임 두 장을 입력으로 받아, 존재하지 않는 가상의 중간 프레임을 만들어 영상의 초당 프레임 수(FPS)를 증가시키는 기술이다. 프레임 보간법을 통해 동영상의 FPS를 늘림으로써, 영상이나 애니메이션에서 부드러운 전환과 자연스러운 동작을 구현하는 데 사용되고 있으며 이를 통해 시청 경험의 품질 향상에 기여하고 있다. 이러한 프레임 보간 기술은 최근 딥러닝이 접목되며 괄목할 만한 성능 향상을 이루어 냈으며, 이러한 딥러닝 기반 프레임 보간 기술은 현재 커널(Kernel) 기반 방식과 광학 흐름(Optical Flow) 방식이 존재한다. 커널 기반 방식은 입력 프레임의 모든 화소에 대해 콘볼루션을 수행하며, 이에 따라 콘볼루션 커널 크기에 따라 움직임 추정에 제한이 있어[1] 영상 전체에 대해 흐름 추적이 가능한 광학 흐름 기반 프레임 보간법이 주로 활용되고 있다[2]. 하지만 광학 흐름 기반 프레임 보간 기술 또한 프레임별 동일 위치의 픽셀 변위는 작다는 것을 전제로 하기에, 갑작스러운 조도 변화, 큰 움직임, 폐색(Occlusion)이 발생하는 경우 성능이 저하되는 단점은 여전히 기술적 어려움으로 남아있으며[3], 카메라가 움직이는 동적 카메라 환경에서는 카메라 이동에 따른 배경의 이동 및 객체의 이동, 폐색 등이 복합적으로 발생해 광학 흐름 추정이 불완전하여 프레임을 보간할 경우 배경이 일렁이는 왜곡 현상이 발생하게 된다[4].

일반적으로 광학 흐름 기반 프레임 보간 기법은 입력 프레임의 해상도를 가능한 최소로 낮추어 큰 움직임을 먼저 추정하고, 이후 해상도를 점진적으로 증가시키면서 세부적인 움직임을 추가함으로써 광학 흐름을 근사화한다. 최종적으로 근사화된 광학 흐름은 와핑(Warping)을 통해 입력 영상의 픽셀 정보를 바탕으로 가상의 보간 프레임을 만들게 된다[1].

이러한 방법은 배경의 이동에 비해 유의미한 객체의 이동을 가진 정적 카메라 환경일 경우 객체의 이동성 예측이 쉽기에 효과적으로 적용될 수 있다. 그러나 동적 카메라 환경의 광학 흐름 추정은 카메라의 움직임으로 인해 추가적인 이동성이 발생하기 때문에 정적 카메라 환경의 광학 흐름 추정보다 어렵게 인식되고 있다[5]. 특히, 동적 카메라 환경에서는 객체뿐만 아니라 배경 영역에서도 이동성이 나타나는데, 이때 배경 영역은 이동성이 적더라도 객체 영역에 비해 영상 특성의 구분성이 적어[6] 부정확한 광학 흐름이 추정될 수 있다. 이와 같이 배경 영역에서의 부정확한 광학 흐름은 보간된 프레임에서의 왜곡으로 나타날 수 있다.

이와 대조적으로, 영상 스티칭(Image Stitching) 기법에 기반해 프레임을 보간하는 경우, 다수의 카메라로 동시간대의 영상을 합성하는 게 아닌 단일 카메라에서 촬영된 프레임을 합성하는 것이기에 시간 흐름에 따른 프레임별 시차(Parallax)가 달라져 보간 프레임에서 객체가 겹치는 고스트 현상(Ghost Effect)이 발생할 수 있다[7]. 그러나 영상 스티칭의 특성상 객체 영역에서 고스트 현상, 정렬 불일치, 모션 블러 현상이 발생할 수 있지만 배경의 매칭은 아주 우수하다. 따라서 상기에서 소개한 광학 흐름 및 스티칭 기반의 보간법 특성에 착안하여 본 논문에서는 동적 카메라 영상에 대해 프레임 보간 과정에서 나타나는 배경 영역의 왜곡을 감소시키기 위해, 광학 흐름 기반 보간법과 스티칭 기반 보간법이 혼합된 스티칭 기반 프레임 보간 프레임워크를 제안하고자 한다. 이를 위해, 2장에서는 기존 프레임 보간법과 관련된 연구를 분석하고 3장에서는 스티칭 기반 프레임 보간 프레임워크에 기술하며 4장에선 제안하는 프레임워크를 평가한다. 이후 5장에서는 결론을 지어 마무리한다.

Ⅱ. 관련 연구

1. 광학 흐름 기반 프레임 보간법

광학 흐름 기반 프레임 보간법은 존재하는 영상 두 프레임을 입력으로 받아, 영상의 광학 흐름을 구하고 이를 통해 가상의 중간 프레임을 생성하는 기술이다. 이러한 광학 흐름 기반 프레임 보간 방식은 DAIN[8], VFIformer[9], Softmax Splatting[10], Super Slomo[11]이 있으며, 광학 흐름 기반 프레임 보간법은 프레임 사이 광학 흐름을 추정하고 광학흐름에 기반해 원본 프레임에서 픽셀을 차용하는 방식을 통해 프레임을 보간하게 된다.

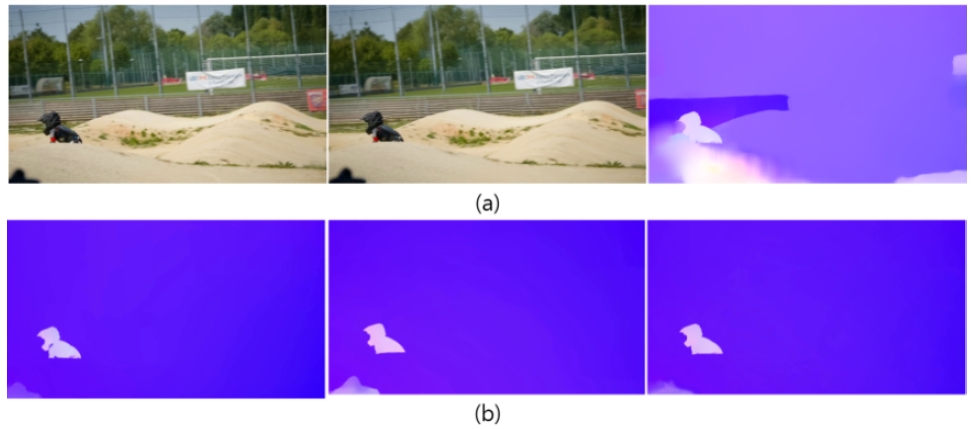

광학 흐름은 실제 세계의 3D 모션이 2D로 투영된 영상에서의 겉보기 밝기 패턴 이동성[12]으로 정의된다. 한 영상에서 t 시간에서 픽셀값을 I(x, y, t)라고 가정할 경우, t+1시간의 영상에서 해당 픽셀값은 식 (1)에서 나타나는 바와 같이 변하지 않는다는 불변성에 기반하여 광학 흐름을 추정하게 된다. 일례로, 그림 1의 (a)에서 (b)로의 광학 흐름은 그림 1의 (c)와 같이 나타난다.

| (1) |

식 (1)의 우항에 테일러 확장을 적용하여 선형 근사할 경우 이는 식 (2)와 같이 변형되며,

| (2) |

상기의 식 (2)를 정리하면, 아래 식 (3)과 같은 광학 흐름 제약 방정식으로 나타낼 수 있으며, 이는 모든 광학 흐름 기반 알고리즘에 적용된다[13].

| (3) |

앞선 가정하에서, 초기 광학 흐름 기반 프레임 보간법은 광학 흐름을 선형적으로 보간해 중간 프레임을 생성하게 된다[14]. 식 (3)의 제약조건 하에서 프레임 0에서 프레임 1로의 광학 흐름을 F0→1이라 하며, 보간된 프레임 t는 시간 축 t∈ (0,1)에 속한다고 가정한다. 마찬가지로 프레임 1에서 프레임 0으로의 광학 흐름은 F1→0으로 표기하며, 보간된 프레임 위의 임의의 점은 F로 표기한다. 이때 프레임 t에서 프레임 1로의 광학 흐름 Ft→1은 식 (4), (5)와 같이 표기된다.

| (4) |

| (5) |

프레임 1에서 프레임 0으로의 광학 흐름을 F1→0이라 할 때, 보간된 프레임 t에서 프레임 0으로의 광학 흐름 Ft→0 는 식 (6)과 같이 표기된다. 더 나아가, 양방향 광학 흐름을 사용하여 프레임 t에서 프레임 0으로 광학 흐름을 근사 시, 이는 식 (7)과 같이 표기되며 마찬가지로 프레임 t에서 프레임 1로의 광학 흐름을 근사할 시, 이는 식 (8)과 같이 표기된다. 추정된 광학 흐름을 이용하여 보간된 프레임을 합성 시 식 (9)로 표기되며, g(ㆍ,ㆍ)는 역방향 와핑 함수[15], α0는 양방향 광학 흐름의 강도를 조절하는 사용자 파라미터이다. I0는 0번째 프레임, I1은 1번째 프레임을 뜻한다.

| (6) |

| (7) |

| (8) |

| (9) |

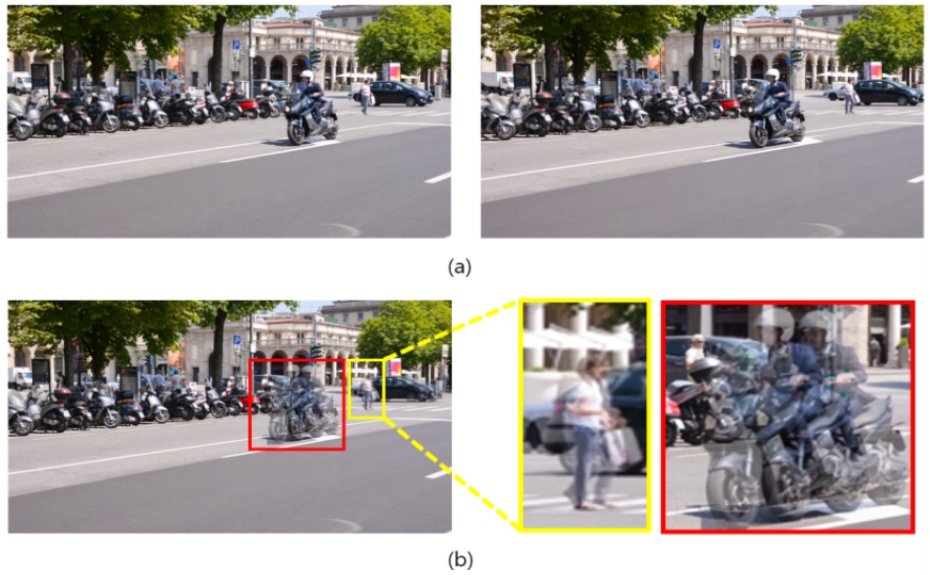

그러나 이러한 광학 흐름 기반 프레임 보간법은 급격한 카메라 움직임, 조도 변화, 폐색 등이 발생할 경우 성능이 급격하게 저하되는 단점을 가지고 있다. 특히 전경보다 픽셀간 구분성이 떨어지는 배경 영역은 이러한 단점이 더 크게 부각될 가능성이 있기에 그림 2의 (c)에서 나타나는 바와 같이 배경 영역에서 왜곡이 발생할 수 있다.

2. 영상 스티칭

영상 스티칭은 중복 영역(Overlap region)이 존재하는 여러 영상을 합성하여 더 넓은 시야각을 가진 영상을 만드는 기술을 의미한다[16]. 단일 카메라에 의해 촬영된 영상은 보통 사람의 눈보다 시야각이 작기에 시야각을 확장하기 위한 하나의 방법으로 영상 스티칭을 사용하며[17], 먼저 여러 장의 입력 영상에 대하여 영상의 크기, 회전, 밝기 등에 강인한 특징점을 추출하는 것으로 시작한다[18]. 앞선 과정을 통해 찾은 특징점을 기반으로 특징점끼리 매칭하여 변환행렬인 호모그래피(Homography)를 계산한다. 이후 합성(Composition)과 블렌딩(Blending)을 통해 영상에서 조도 차이 등 부자연스러운 부분을 개선하여 한 장의 단일영상으로 스티칭을 마무리하게 된다.

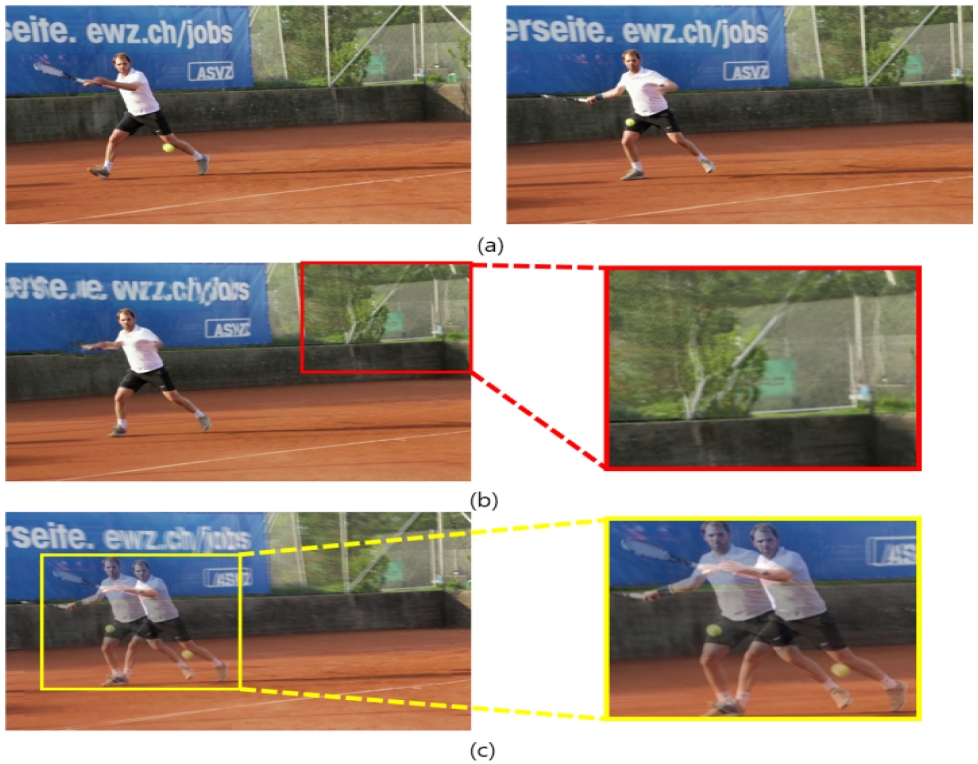

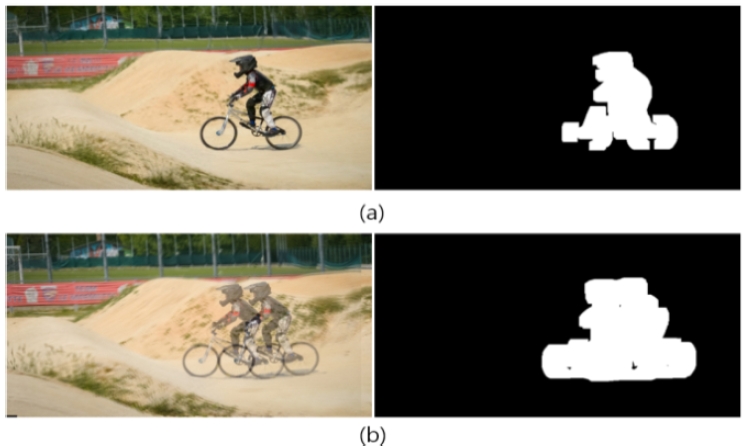

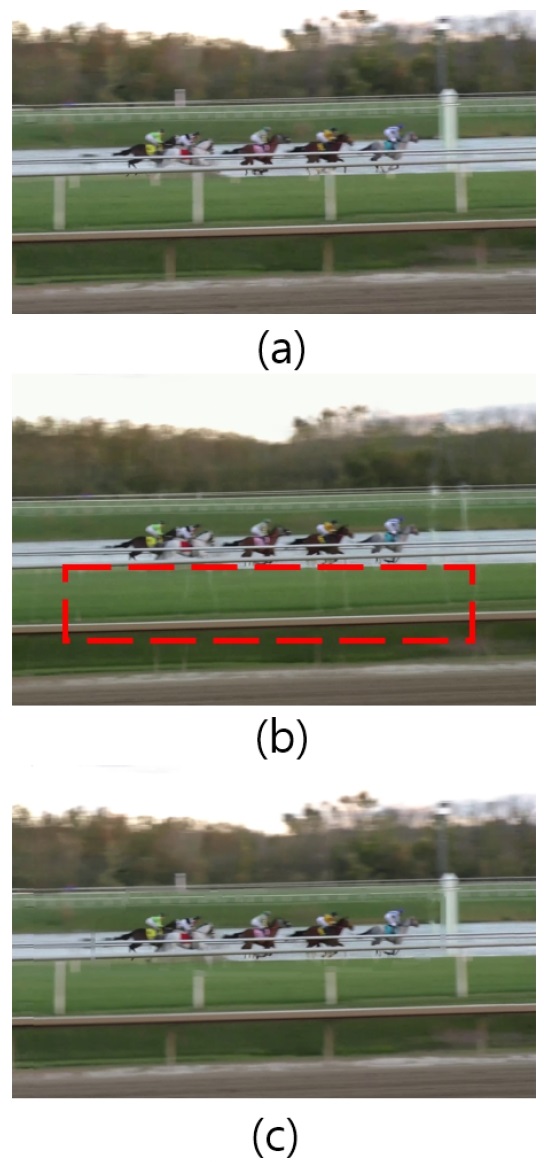

영상 스티칭 기반 프레임 보간법에서는, 입력받은 두 장의 영상에서 특징점을 찾아 매칭시키고, 합성하는 과정을 통해 보간될 영상의 배경을 생성하게 된다. 그러나 영상 스티칭을 통해 단안 동적 카메라 환경에서 프레임 보간을 진행할 경우, 그림 3 (b)와 같은 고스트 현상이 발생할 수 있다. 이는 영상 스티칭은 시간 축이 동일한 영상을 합성하는 것을 전제로 하므로 시간 축이 다른 영상을 합성할 경우, 시간 차이로 인한 시차(Parallax)가 발생하기 때문이다[19]. 이러한 고스트 현상은 동영상에서 객체가 깜박이는(Flickering) 현상으로 나타나 영상 시청에 큰 방해 요소가될 수 있다. 그러나, 그림 3의 (b)에서 나타나듯이 영상 스티칭을 통해 생성된 영상의 배경 영역은 그림 2의 (c)에서 나타나는 광학 흐름 기반 보간법보다 영상 스티칭에서 선명하게 나타나는 것을 확인할 수 있다.

영상 스티칭은 배경 영역 생성에 우수한 성능을 보이지만, 객체 영역에서는 그림 4 (c)와 같이 시차로 인한 고스트 현상이 발생하는 단점이 있다. 반면, 광학 흐름 기반 프레임 보간법은 객체 영역 생성에 강점이 있지만, 배경 영역에서는 그림 4 (b)와 같이 부정확한 광학 흐름 추정으로 왜곡이 발생할 수 있다. 본 논문에서는 이러한 두 기법의 특성을 고려하여, 전경 객체는 광학 흐름 기반 보간법에서 차용하고, 배경 영역은 스티칭 기법에서 차용하는 프레임 보간 프레임워크를 제안한다.

Ⅲ. 스티칭 기반 프레임 보간 프레임워크

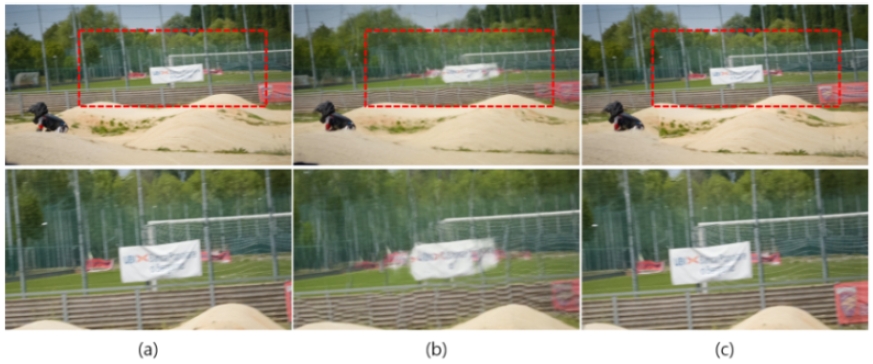

3장에서는 영상 스티칭 기반 프레임 보간 프레임워크에 대해 기술한다. 앞서 기술하듯, 동적 카메라 환경에서는 배경과 객체가 동시에 이동성을 가지며, 이에 따라 광학 흐름 추정이 어려워져 광학 흐름 기반 보간법의 성능이 저하된다. 특히, 배경 영역은 객체에 비해 구분성이 낮아 광학 흐름 추정이 더욱 어려워지고, 프레임 보간 과정에서 배경 영역에서 그림 5 (c)와 같이 더 큰 왜곡이 발생할 수 있다. 이러한 배경 영역에서의 왜곡 문제를 해결하기 위해 본 논문에서는 스티칭 기법의 장점을 활용하여 배경 영역의 왜곡을 개선하는 스티칭 기반 프레임 보간 프레임워크를 제안한다.

Artifacts of background area caused by camera mobility (a) 54th frame (b) 56th frame (c) Interpolated 55th frame

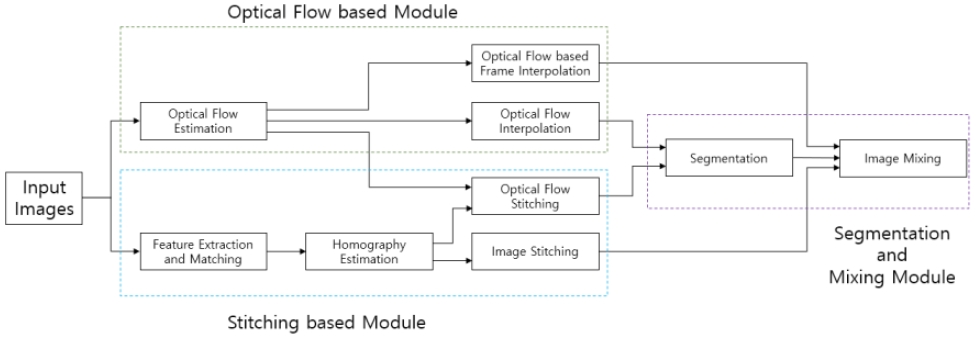

본 논문에서 제안하는 영상 스티칭 기반 프레임 보간 프레임워크는 그림 6과 같이 입력 영상을 대상으로 스티칭을 실행하는 스티칭 기반 모듈, 광학 흐름 추정과 보간을 진행하는 광학 흐름 기반 모듈, 입력받은 광학 흐름 영상을 기반으로 마스킹을 추정하는 세그멘테이션 및 믹싱 모듈로 구성된다. 스티칭 기반 모듈로 입력된 영상은 특징점 추출 및 매칭을 통해 크기, 회전, 밝기 변화 등에 강인한 특징점을 찾게 된다. 특징점들은 이후 영상 간 호모그래피 추정에 이용된다. 추정된 호모그래피 행렬을 바탕으로 영상 스티칭을 진행하게 되며, 해당 호모그래피를 기반으로 입력 영상 간의 광학 흐름 또한 스티칭한다. 광학 흐름 기반 모듈은 입력 영상의 해상도를 조절해가며 광학 흐름을 추정하며, 이후 영상 보간, 광학 흐름 영상 보간이 진행된다. 세그멘테이션 및 믹싱 모듈은 입력으로 영상 및 광학 흐름을 받으며 최종적으로 스티칭 기반 영상으로 배경을 구성하고 광학 흐름 기반 영상으로 객체를 구성하는 역할을 한다. 광학 흐름을 입력받는 세그멘테이션 모델에선 객체와 배경을 분리하는 작업을 수행하며, 일반적인 영상 세그멘테이션 모델은 동영상에서 프레임 간 객체의 연관성을 고려하지 않으므로[20] 동영상이라는 점을 고려해 동영상 객체 분할 (Video Object Segmentation) 모델을 사용한다. 광학 흐름 기반 모듈의 객체 마스크 크기와 스티칭 기반 모듈의 객체 마스크 크기는 고스트 현상으로 인해 스티칭 기반 모듈에서 더 크게 나타나므로 잔차 영역을 구성한다. 해당 잔차 영역은 스티칭 기반 객체 마스크 크기에서 광학 흐름 기반 객체 마스크 크기를 뺀 영역을 뜻하며, 영상 믹싱 모듈에서 잔차 영역과 광학 흐름 모듈의 마스크 영역을 광학 흐름 기반으로 보간된 영상에서 차용하고, 배경은 스티칭 영상에서 차용한다.

1. 광학 흐름 기반 모듈

광학 흐름 기반 모듈은 입력 영상을 대상으로 RIFE[2] 보간 모델을 활용하여 영상 및 광학 흐름의 보간 작업을 수행한다. 이 모듈의 영상 보간 과정에서는 입력 영상을 받아 그림 7의 (b)와 같이 보간된 영상을 생성하며, 동시에 보간된 영상과 원본 영상 사이의 광학 흐름을 추정한다. 이렇게 생성된 보간된 영상과 광학 흐름은 세그멘테이션 및 믹싱 모듈의 입력으로 사용되어 3-3 과정에서 마스킹을 만들게 된다.

Inaccurate optical flow in interpolated frames (a) Optical Flow between 52th frames and interpolated 53th frames (b) Optical flow between 52th and 54th frames and interpolated 53th optical flow

광학 흐름 추정 과정에서, 기존 광학 흐름 추정 방식을 활용하여 원본 영상과 보간된 영상 사이의 광학 흐름을 식 (4)와 같이 계산할 경우, 그림 7 (a)와 같이 부정확한 광학 흐름이 추정된다. 해당 광학 흐름은 52th와 54th 프레임 간 광학 흐름인 그림 7 (b)에 비해 오차가 큰 것을 확인할 수 있다. 이는 오차가 존재하는 광학 흐름을 기반으로 영상을 보간한 후, 보간된 영상과 원본 사이 광학 흐름을 재추정하였기 때문이다. 따라서 광학 흐름 기반 모듈에선 원본 영상과 보간된 영상 간 광학 흐름을 직접 추정하지 않고, 광학 흐름 영상 자체를 RIFE를 통해 보간하여 새로운 광학 흐름 영상을 간접 추정하며, 이는 그림 7 (b)와 같다.

2. 스티칭 기반 모듈

스티칭 기반 모듈은 스티칭, 광학 흐름 스티칭, 오려내기 과정을 포함하며, 각 단계는 순차적으로 수행된다. 첫 번째 단계에서는 입력된 두 영상에서 SIFT 알고리즘을 이용해 특징점을 추출하고, 이를 매칭하여 변환 행렬인 호모그래피를 계산한다. 이후 계산된 호모그래피를 기반으로 입력 영상을 와핑(Warping)하여 확장된 영상을 생성한다.

두 번째 단계에서는 광학 흐름 스티칭 과정을 통해 세그멘테이션 및 믹싱 모듈의 입력으로 필요한 광학 흐름을 생성한다. 스티칭된 영상에 고스트 현상이 포함될 경우, 원본 영상 2nd 프레임과 보간된 영상 (2nd과 3rd 프레임을 보간)간 광학 흐름 추정에서 그림 8 (b)와 같이 부정확한 결과가 나타난다. 이를 해결하기 위해, 광학 흐름 스티칭 과정에선 스티칭 과정에서 계산된 호모그래피를 기존 광학 흐름 영상에 적용하여 보간된 영상의 광학 흐름을 그림 8 (c)와 같이 간접적으로 추정한다.

3. 세그멘테이션 및 믹싱 모듈

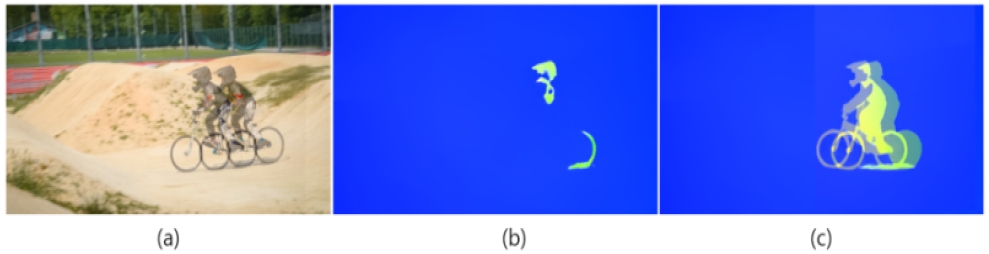

세그멘테이션 및 믹싱 모듈에선 고스트 현상이 발생한 스티칭 영상과 광학 흐름 영상을 입력으로 받으며, 광학 흐름 기반 모듈로 보간된 영상과 광학 흐름 영상을 입력으로 처리한다. 세그멘테이션 모듈에선 광학 흐름 기반 모듈과 스티칭 기반 모듈에서 받은 영상과 광학 흐름 각각에 대해 마스크를 추정하는 과정이 진행된다. 배경 영역은 스티칭 기반으로 구성하며, 객체 영역만 광학 흐름 기반으로 구성하여야 하므로, 객체의 마스크를 구하기 위해 프레임 간 광학 흐름 및 객체의 유사성을 고려해 분할하는 HCPN[21] 모델을 사용해 입력받은 영상과 광학 흐름을 토대로 마스크를 추정한다. 그러나 앞서 스티칭 기반으로 보간된 영상과 광학 흐름은 그림 8 (a)와 그림 8 (c)와 같이 고스트 현상이 나타나며, 마스크의 크기 또한 그림 9 (b)와 같이 광학 흐름 기반으로 보간된 영상의 마스킹인 그림 9 (a)보다 큰 특성을 보인다. 크기가 다름으로 인해 광학 흐름 기반 마스크와 스티칭 기반 마스크는 잔차 영역이 존재하며, 잔차 영역은 영상 믹싱 과정에서 마스킹의 정확도를 높이는 역할을 한다.

Masking of optical flow-based interpolation and stitched images (a) Masking of optical flow-based interpolation images (b) Masking of stitched images

영상 믹싱 모듈에선 스티칭 모듈을 통해 배경을 구성하며 객체는 앞선 세그멘테이션 모듈을 통해 구한 마스크의 크기만큼 광학 흐름 기반 모듈의 객체를 가져와 구성하게 된다. 일반적인 잔차 영역 마스크는 그림 10 (a)와 같으며 하얀색 픽셀의 영역이다. 광학 흐름 마스크는 그림 10 (a)의 회색 픽셀의 영역이다. 그림 10 (b)에서 알 수 있듯 입력 영상에 따라 특정 마스크가 오차로 인해 부정확하게 측정될 가능성이 존재한다. 제안 기술은 그림 10 (b)와 같은 마스킹의 오차를 줄이기 위해 잔차 영역 및 광학 흐름 마스킹 전부를 광학 흐름 기반 영상에서 차용하여 객체를 구성한다. 이를 통해 객체에서 발생하는 고스트 현상 및 세그멘테이션 모델의 마스킹 오류를 감소시키고자 한다.

Ⅳ. 실험 결과

4장에서는 제안된 프레임워크의 성능검증을 위한 실험 방법 및 결과에 관해 기술한다. 성능검증을 위한 데이터 세트로는 DAVIS[22] 및 Inter4K[23] 데이터 세트를 사용하였으며 광학 흐름을 구하는 모델은 RAFT[24], 마스크를 구하는 모델은 HCPN을 사용하였다. 프레임 보간은 입력 영상 사이의 임의의 시간을 가진 보간된 가상의 영상을 만들어내는 것으로써, N번째 프레임과 N+1번째 프레임을 입력 영상으로 임의의 시간을 가진 프레임을 보간할 경우, 비교할 원본 프레임이 없다는 특징을 가진다. 때문에, 실험은 N번째 프레임과 N+2번째 프레임을 그림 5의 스티칭 기반 프레임 보간 파이프라인의 입력으로 하였으며, N+1번째 프레임을 보간하여, 이를 원본과 PSNR, SSIM 평가지표를 통해 성능측정을 하며 이를 제안된 방법과 비교하였다. DAVIS 데이터 세트는 전체 프레임을 사용하였으며, Inter4K 데이터 세트는 0~100번째 프레임을 이용하였다. 표 1은 480p, 1080p의 두 개의 해상도를 가지며 비디오 분할(Segmentation)을 위해 벤치마킹 된 DAVIS 데이터 세트를 통해 제안된 기술과 RIFE를 실험하였으며 보간된 프레임과 원본을 PSNR, SSIM 평가지표를 통해 비교하였다. 또한 PNSR, SSIM이 영상의 공간적 모호성 같은 왜곡에는 취약하다는 점을 고려하여, LPIPS[25] 평가지표를 통해서도 성능을 검증하였다. Pivot Interval은 프레임 사이 간격을 의미한다.

제안 기술은 객체는 광학 흐름 기반 보간법을 통해 구성하며, 배경은 스티칭을 통해 구성하기 때문에, 표 1의 결과는 동적 카메라 환경에서 제안된 기술이 배경 생성에 있어서 더 우수하다는 것을 알 수 있다. 또한, 그림 11의 (a)와 같이 나타나는 입력 영상을 대상으로 광학 흐름 기반 프레임 보간법의 결과물인 그림 11 (b)는 상단에 오류가 나타낸 것과 달리, 제안된 방법은 그림 11 (c)와 같이 이와 같은 오류를 제거하였다.

Interpolated and enlarged images (a) Original frame (b) Optical flow based frame interpolation (c) Proposed method

제안 기술은 객체는 광학 흐름 기반 보간법을 통해 구성하며, 배경은 스티칭을 통해 구성하기 때문에, 표 1의 결과는 동적 카메라 환경에서 제안된 기술이 배경 생성에 있어서 더 우수하다는 것을 알 수 있다. 또한 표 1의 drift-turn 데이터의 실험 결과는 전체 데이터 세트에서 가장 낮은 성능을 기록하였는데, 이는 앞서 기술한 카메라의 동적 이동성이 크기 때문에 부정확한 광학 흐름이 추정되어 광학 흐름 기반 프레임 보간법의 성능이 낮아졌기 때문에 객체를 차용하는 제안 기술 또한 낮아진 모습을 보였다.

표 2는 프레임 보간을 위해 벤치마킹된 60fps, 1000개의 4K 비디오로 구성된 Inter4K 데이터 세트를 대상으로 제안 기술과 RIFE를 실험하였으며 보간된 프레임과 원본을 PSNR, SSIM 평가지표로 비교하였다.

표 2를 통해, 제안된 기술은 DAVIS 데이터 세트 뿐만 아니라 Inter4K 데이터 세트를 대상으로 실험하였을 때도 우수하게 동작하는 것을 알 수 있다. 표 2의 결과를 통해, Inter4K 데이터 세트는 DAVIS 데이터 세트에 비해 평균적으로 RIFE, 제안 기술 모두에서 좋은 성능을 보였음을 알 수 있는데 이는 60fps로 제작된 Inter4K 데이터 세트의 특성상, 프레임 간 카메라의 이동성이 작기에 광학 흐름 추적이 용이하므로 광학 흐름 기반 프레임 보간법에서 DAVIS 데이터 세트에 비해 더 좋은 결과를 보였다. 마찬가지로, 제안된 기술은 스티칭 기반으로 배경을 구성하기에 카메라의 이동성이 적을수록 배경 영역의 시차 또한 작아져 PSNR, SSIM 부분에서 좋은 성능을 보였다. 동일 데이터라도 입력되는 프레임 간 간격을 늘려 광학 흐름 추정이 어렵거나 프레임 간 시차가 클 경우, 두 기술 모두 성능저하를 보였으며, 1번째 프레임과 3번째 프레임을 입력으로 하여 2번째 프레임을 보간한 361 (2) 데이터와 0번째 프레임과 4번째 프레임을 입력으로 하여 2번째 프레임을 보간한 361 (4) 데이터를 보면 알 수 있다. 한편, 488 데이터는 PSNR 평가지표에서 RIFE와 제안 기술의 차이가 가장 작게 나타나는데, 이는 488 데이터는 프레임 간의 이동성이 매우 크기에 광학 흐름 기반 프레임 보간법과 제안 기술 모두 효과적으로 작용할 수 없다고 보인다.

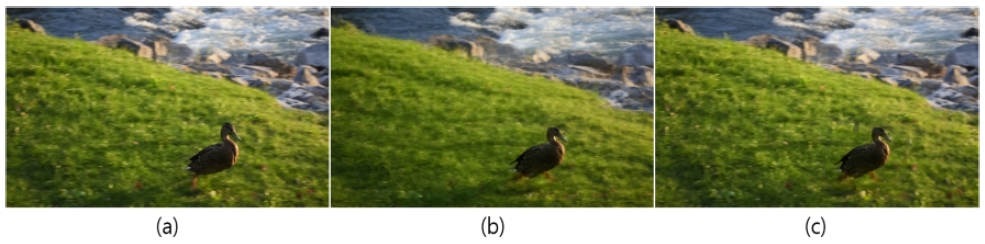

앞서 기술한 동적 카메라 환경에서 배경 추정의 어려움으로 인한 광학 흐름 기반 프레임 보간법의 배경 왜곡은 DAVIS 데이터 세트에 대해서도 동일하게 나타난다. 표 1의 보간된 프레임의 성능 차이가 가장 심한 mallad-fly 데이터는 그림 12와 같으며, 배경 영역의 광학 흐름 추정의 어려움으로 인해 보간된 프레임의 배경은 텍스처가 왜곡되는 모습을 볼 수 있다.

Background area of interpolated image (a) Original image (b) Optical flow-based frame Interpolation (c) Proposed method

그러나 PSNR, SSIM이 영상의 복잡한 왜곡에는 취약하다는 점을 고려하여 LPIPS 평가지표로 보간된 프레임의 성능측정을 하였을 땐 다른 결과나 나타났다. 표 3은 앞선 DAVIS와 Inter4K 데이터 세트를 대상으로 LPIPS 평가지표를 통해 보간된 프레임과 원본 프레임을 비교한 결과이며 앞선 PSNR, SSIM 평가지표의 결과와 상이한 것을 알 수 있다. 60fps로 촬영되어 DAVIS에 비해 비교적 작은 카메라 이동성을 가지는 Inter4K 데이터 세트는 LPIPS 평가지표에서도 전반적으로 DAVIS 데이터 세트에 비해 좋은 점수를 기록하였으며, DAVIS 데이터 세트에 대해선 제안 기술이 우수한 것으로 측정되었으나, 카메라 이동성이 줄어든 Inter4K 데이터 세트에 대해선 244, 488 데이터만이 제안 기술이 우수한 것으로 나타났다. 더불어, 361 (4) 데이터는 PSNR, SSIM 평가지표에서 361 (2) 데이터에 비해 낮은 점수를 기록하였으며, 마찬가지로 LPIPS 평가지표에서도 361 (2) 데이터에 비해 낮은 점수를 기록하였다. 이는 0번째 프레임과 4번째 프레임을 입력으로 하여 2번째 프레임을 보간한 361 (4) 데이터의 특성상 입력 영상과 보간될 영상 사이 시차가 증가하여 카메라 이동성 또한 증대되었고 이에 따라 PSNR, SSIM, LPIPS 평가지표에서 점수 하락으로 이어진 것으로 보인다. 또한 361 (2), 361 (4) 두 데이터는 PSNR, SSIM 평가지표 모두에서 제안 기술이 우수한 것으로 측정되었지만, LPIPS 결과에선 RIFE가 우수한 성능을 보였다. 데이터에 따라 차이는 있지만 전반적으로 제안 기술은 우수한 모습을 보였으며, 이러한 결과는 제안 기술이 동적 카메라 환경에서는 그림 13 (c)와 같이 배경 영역을 잘 구성하며 효과적으로 작용하는 것을 의미한다.

Interpolated 23th frame of 336 data (a) Original frame (b) Optical flow-based frame interpolation and artifact area (c) Proposed method

또한, 제안 기술과 비교 기술에 대하여 사람의 주관적 인식 평가를 비교하기 위하여 사람의 주관적 평가와 상관도가 높은 Non-Reference Image Quality Assessment (NR-IQA)인 MANIQA[26]을 통해 실험하였다. 표 4에서 나타나는 바와 같이, 해당 실험 결과는 전체 데이터 세트에 대하여 제안 기술이 RIFE보다 우수한 것으로 나타났으며, 카메라 이동성이 큰 DAVIS 데이터 세트는 Inter4K 데이터 세트보다 평균적인 MANIQA 점수가 낮게 나왔다.

Ⅴ. 결 론

본 논문에서는 동적 카메라 환경에서 광학 흐름 기반 보간법의 제한사항을 극복하기 위하여 배경은 스티칭으로 구성하며 객체는 광학 흐름 기반 보간법으로 구성하는 기술을 제안하였다. 제안 기술인 스티칭 기반 프레임 보간 프레임워크와 기존 광학 흐름 기반 프레임 보간법인 RIFE를 비교해 FR-IQA 방식 및 NR-IQA 방식으로 평가를 진행하였으며, 동적 카메라 환경에서 RIFE로 프레임 보간 경우 배경 영역에서 왜곡이 발생하는 것을 확인할 수 있었다. 반면, 제안 기술은 동적 카메라 환경에서 프레임 보간 시 우수한 성능으로 배경을 생성하였다. 그러나 비교적 카메라 이동성이 적은 데이터를 대상으로 두 기술을 실험할 경우, 제안 기술은 PSNR, SSIM 및 LPIPS, MANIQA 평가지표에서 정량적으로 우수한 성능을 보였고, 영상을 통한 주관적 품질평가 결과에서도 우수성을 보였다.

Acknowledgments

This work was supported by Korea Research Institute for defense Technology planning and advancement(KRIT) grant funded by the Korea government (DAPA(Defense Acquisition Program Administration)) (21-106-A00-007, Space-Layer Intelligent Communication Network Laboratory, 2022) and supported by the MSIT(Ministry of Science and ICT), Korea, under the ITRC(Information Technology Research Center) support program(IITP-2025- RS-2021-II212046) supervised by the IITP(Institute for Information & Communications Technology Planning & Evaluation.

References

- Heo, J. G., Yun, G. H., Kim, S. J., & Jeong, J. U. (2022). Trend of research on video frame interpolation technology based on deep learning. Broadcasting and Media Magazine, 27(2), 51-61.

-

Huang, Z., Zhang, T., Heng, W., Shi, B., & Zhou, S. (2022, October). Real-time intermediate flow estimation for video frame interpolation. In European Conference on Computer Vision (pp. 624-642). Cham: Springer Nature Switzerland.

[https://doi.org/10.1007/978-3-031-19781-9_36]

-

Zhai, M., Xiang, X., Lv, N., & Kong, X. (2021). Optical flow and scene flow estimation: A survey. Pattern Recognition, 114, 107861.

[https://doi.org/10.1016/j.patcog.2021.107861]

-

Dong, J., Ota, K., & Dong, M. (2023). Video frame interpolation: A comprehensive survey. ACM Transactions on Multimedia Computing, Communications and Applications, 19(2s), 1-31.

[https://doi.org/10.1145/3556544]

-

Sincan, O. M., Ajabshir, V. B., Keles, H. Y., & Tosun, S. (2015, September). Moving object detection by a mounted moving camera. In IEEE EUROCON 2015-International Conference on Computer as a Tool (EUROCON) (pp. 1-6). IEEE.

[https://doi.org/10.1109/eurocon.2015.7313714]

-

Beauchemin, S. S., & Barron, J. L. (1995). The computation of optical flow. ACM computing surveys (CSUR), 27(3), 433-466.

[https://doi.org/10.1145/212094.212141]

-

Su, H., Wang, J., Li, Y., Hong, X., & Li, P. (2014, December). An algorithm for stitching images with different contrast and elimination of ghost. In 2014 Seventh International Symposium on Computational Intelligence and Design (Vol. 2, pp. 104-107). IEEE.

[https://doi.org/10.1109/iscid.2014.75]

-

Bao, W., Lai, W. S., Ma, C., Zhang, X., Gao, Z., & Yang, M. H. (2019). Depth-aware video frame interpolation. In Proceedings of the IEEE/CVF conference on computer vision and pattern recognition (pp. 3703-3712).

[https://doi.org/10.1109/cvpr.2019.00382]

-

Lu, L., Wu, R., Lin, H., Lu, J., & Jia, J. (2022). Video frame interpolation with transformer. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (pp. 3532-3542).

[https://doi.org/10.1109/cvpr52688.2022.00352]

-

Niklaus, S., & Liu, F. (2020). Softmax splatting for video frame interpolation. In Proceedings of the IEEE/CVF conference on computer vision and pattern recognition (pp. 5437-5446).

[https://doi.org/10.1109/cvpr42600.2020.00548]

-

Jiang, H., Sun, D., Jampani, V., Yang, M. H., Learned-Miller, E., & Kautz, J. (2018). Super slomo: High quality estimation of multiple intermediate frames for video interpolation. In Proceedings of the IEEE conference on computer vision and pattern recognition (pp. 9000-9008).

[https://doi.org/10.1109/cvpr.2018.00938]

- Horn, B. (1986). Robot vision. MIT press.

-

Baker, S., Scharstein, D., Lewis, J. P., Roth, S., Black, M. J., & Szeliski, R. (2011). A database and evaluation methodology for optical flow. International journal of computer vision, 92, 1-31.

[https://doi.org/10.1007/s11263-010-0390-2]

-

Shimizu, J., Sun, H., & Katto, J. (2022, February). Forward and Backward Warping for Optical Flow-Based Frame Interpolation. In 2022 International Conference on Artificial Intelligence in Information and Communication (ICAIIC) (pp. 082-086). IEEE.

[https://doi.org/10.1109/icaiic54071.2022.9722682]

-

Zhou, T., Tulsiani, S., Sun, W., Malik, J., & Efros, A. A. (2016). View synthesis by appearance flow. In Computer Vision–ECCV 2016: 14th European Conference, Amsterdam, The Netherlands, October 11–14, 2016, Proceedings, Part IV 14 (pp. 286-301). Springer International Publishing.

[https://doi.org/10.1007/978-3-319-46493-0_18]

-

Szeliski, R. (2007). Image alignment and stitching: A tutorial. Foundations and Trends® in Computer Graphics and Vision, 2(1), 1-104.

[https://doi.org/10.1561/0600000009]

-

Rhee, S., Park, G. H., & Kim, K. (2023). Seam Generation Matrix Based on a Guided Energy-Depth Map for Image and Video Stitching. IEEE Access, 11, 133229-133245.

[https://doi.org/10.1109/access.2023.3336700]

-

Seongbae Rhee, Jeonho Kang, & Kyuheon Kim. (2020). Image Stitching focused on Priority Object using Deep Learning based Object Detection. Broadcasting and Media Magazine, 25(6), 882-897.

[https://doi.org/10.5909/JBE.2020.25.6.882]

-

Kang, J., Rhee, S., Lee, I., & Kim, K. (2021). Hybrid Ultra-Wide Viewing Broadcasting Platform With Reduced Keypoint Redundancy Matching and Robust Blending for Parallax Errors. IEEE Access, 9, 153775-153795.

[https://doi.org/10.1109/access.2021.3127269]

- Xu, C., Li, C. T., Hu, Y., Lim, C. P., & Creighton, D. (2023). Deep Learning Techniques for Video Instance Segmentation: A Survey. arXiv preprint arXiv:2310.12393, .

-

Pei, G., Yao, Y., Shen, F., Huang, D., Huang, X., & Shen, H. T. (2023). Hierarchical co-attention propagation network for zero-shot video object segmentation. IEEE Transactions on Image Processing, 32, 2348-2359.

[https://doi.org/10.1109/tip.2023.3267244]

-

Pont-Tuset, J., Perazzi, F., Caelles, S., Arbeláez, P., Sorkine-Hornung, A., & Van Gool, L. (2017). The 2017 davis challenge on video object segmentation. arXiv preprint arXiv:1704.00675, .

[https://doi.org/10.48550/arXiv.1704.00675]

-

Stergiou, A., & Poppe, R. (2022). Adapool: Exponential adaptive pooling for information-retaining downsampling. IEEE Transactions on Image Processing, 32, 251-266.

[https://doi.org/10.1109/tip.2022.3227503]

-

Teed, Z., & Deng, J. (2020). Raft: Recurrent all-pairs field transforms for optical flow. In Computer Vision–ECCV 2020: 16th European Conference, Glasgow, UK, August 23–28, 2020, Proceedings, Part II 16 (pp. 402-419). Springer International Publishing.

[https://doi.org/10.1007/978-3-030-58536-5_24]

-

Zhang, R., Isola, P., Efros, A. A., Shechtman, E., & Wang, O. (2018). The unreasonable effectiveness of deep features as a perceptual metric. In Proceedings of the IEEE conference on computer vision and pattern recognition (pp. 586-595).

[https://doi.org/10.1109/cvpr.2018.00068]

-

Yang, S., Wu, T., Shi, S., Lao, S., Gong, Y., Cao, M., ... & Yang, Y. (2022). Maniqa: Multi-dimension attention network for no-reference image quality assessment. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (pp. 1191-1200).

[https://doi.org/10.1109/cvprw56347.2022.00126]

- 2023년 8월 : 경희대학교 전자공학과 공학사

- 2023년 9월 ~ 현재 : 경희대학교 전자정보융합공학과 석사과정

- ORCID : https://orcid.org/0009-0001-9935-5922

- 주관심분야 : 딥러닝, 영상처리, 멀티미디어 시스템

- 2019년 2월 : 경희대학교 전자공학과 공학사

- 2021년 2월 : 경희대학교 전자정보융합공학과 공학석사

- 2021년 3월 ~ 현재 : 경희대학교 전자정보융합공학과 박사과정

- ORCID : https://orcid.org/0000-0002-7392-6870

- 주관심분야 : 딥러닝, 영상처리, 멀티미디어 시스템

- 1989년 2월 : 한양대학교 전자공학과 공학사

- 1992년 9월 : 영국 University of Newcastle upon Tyne 전기전자공학과 공학석사

- 1996년 7월 : 영국 University of Newcastle upon Tyne 전기전자공학과 공학박사

- 1996년 ~ 1997년 : 영국 University of Sheffield, Research Fellow

- 1997년 ~ 2006년 : 한국전자통신연구원 대화형미디어연구팀장

- 2006년 ~ 현재 : 경희대학교 전자정보대학 교수

- ORCID : http://orcid.org/0000-0003-1553-936X

- 주관심분야 : 디지털 방송, 영상처리, 멀티미디어 통신, 디지털 대화형 방송