전시공간에 최적화된 얼굴 교환 애플리케이션 개발

Copyright © 2024 Korean Institute of Broadcast and Media Engineers. All rights reserved.

“This is an Open-Access article distributed under the terms of the Creative Commons BY-NC-ND (http://creativecommons.org/licenses/by-nc-nd/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited and not altered.”

초록

인공지능의 발전으로 전시산업의 성장은 급성장을 이루고 있다. 특히 관객과의 소통과 협업을 기반으로 하는 체험 콘텐츠의 개발은 다양하게 이루어지고 있다. 과거의 인물과 그 시대의 역사를 배경으로 한 ‘인물 사진 체험관’은 딥페이크(deepfake) 기술로 부자연스러웠던 얼굴 합성이 정교하게 표현되어 관객들의 흥미와 재방문 효과를 가져왔다. 본 연구는 전시 콘텐츠를 개발하는 소규모 기업에서 오픈소스를 활용하여 콘텐츠를 개발하는 과정과 전시 결과를 소개한다. 오픈소스로는 GitHub에서 제공하는 Faceswap-GAN을 활용하였다. ‘인물 사진 체험’ 콘텐츠는 안중근 의사와 나란히 앉아 있는 모습을 체험자가 경험하게 된다. 체험자는 같이 사진을 찍은 결과 이미지를 소유함과 동시에 전시를 위한 대형 모니터에서도 볼 수 있도록 전시된다. 디지털 전시 콘텐츠 개발 과정을 소개함으로써 인공지능 기반의 오픈소스 활용을 통한 품질 개선 방법이 전시 산업계에 실용적으로 적용되길 기대한다.

Abstract

The growth of the exhibition industry is rapidly growing due to the development of artificial intelligence. In particular, the development of interactive content based on communication and collaboration with the audience has been diverse. The "Historical Figure Photo Experience Hall," which features historical figures and their eras, uses deepfake technology to create sophisticated facial composites that have piqued audience interest and encouraged repeat visits. This study introduces the content development process and exhibition results using open source in a small company developing exhibition content. For the open-source tool, faceswap-GAN provided by GitHub was utilized. The “Historical Figure Photo Experience” content allows participants to experience sitting next to Ahn Jung-geun. Participants can own the resulting photo taken with him, and it will also be displayed on a large monitor for the exhibition. By introducing the digital exhibition content development process, we hope that quality improvement methods through the use of artificial intelligence-based open source will be practically applied to the exhibition industry.

Keywords:

Experiential content, Deepfake, Faceswap, Exhibition content, Facial compositionsⅠ. 서 론

전시산업의 성장을 이끄는 데 있어 디지털 기술의 발전이 가장 큰 역할을 했다고 해도 과언이 아니다. 2019년 이후 국내에서는 문화체육관광부, 과학기술정보통신부, 중소벤처기업부 등에서 실감콘텐츠 사업 정책으로 전시산업이 급성장하였다. 19년도 실감콘텐츠 제작에 주로 사용되었던 기술은 VR(Virtual Reality), AR(Augmented Reality), MR(Mixed Reality)과 같은 것이었다면, 최근 주목받는 것은 AI(Artificial Intelligence) 기술이다. 특히 딥러닝을 응용한 딥페이크 기술들은 전시산업에 많은 영향을 주고 있으며, 사람(관객)과의 협업 창작 형태로 체험형 콘텐츠를 정교화하는 표현이 가능해졌다. 본 연구는 소규모의 전시 콘텐츠 개발업체가 오프라인 전시 공간에서 최근 3년간 전시되었던 체험형 콘텐츠 중 인물 합성 기술을 적용한 ‘인물 사진 체험’ 애플리케이션의 개발 과정을 설명한다. 22년에 제작한 ‘인물 사진 체험’은 얼굴 교환을 위해 얼굴 부분만 오려내어 다른 얼굴로 대치하는 과정에서 얼굴 테두리 부분이 어색한 문제점이 발생하였다. 2차 개발은 딥러닝 기술을 접목하여 인물 합성에 부자연스러웠던 부분을 수정, 보완하였다.

10여 년 전부터 과학관이나 박물관과 같은 전시장에서 관람객의 체험을 위해 시작한 ‘인물 합성 체험’ 전시 콘텐츠는 역사의 시대적 의상이나 배경 사진들과 체험자(관객)의 얼굴 사진을 합성하여 관람객에게 재미와 재방문을 유도하는 역할을 해왔다. 초창기에 주로 사용된 표현 기법은 포토샵과 같은 애플리케이션을 활용하여 체험자의 전신 또는 얼굴을 원형의 형태로 오려내어서 주변의 배경과 합성하는 방법으로 개발되었다. 이러한 방식에 기반하여 ‘인물 사진 체험’ 애플리케이션은 조금씩 발전하여, 최근 기술인 딥페이크(deepfake)가 있다. 딥페이크는 딥러닝(deep learning)과 가짜(fake)의 혼성어로 인공지능을 기반으로 한 이미지 합성 기술이다[1]. 대중적으로 사용되는 딥페이크 서비스로는 페이스앱(FaceApp), 딥스왑(DeepSwap), 딥노스탤지어(Deep Nostalgia), 페이스매직(FaceMagic), 리페이스(Reface) 등이 있다. 페이스스왑(Faceswap)도 역시 딥페이크의 일종으로 사진과 비디오 속의 얼굴을 특정 포인트인 이목구비, 피부, 머리 스타일 등을 추출하여 기존 얼굴에서 다른 사람의 얼굴로 바꾸는 기능이 있다. 본 연구에서는 CNN(Convolutional Neural Networks) 자동 인코더와 결합된 GAN(Generative Adversarial Network)을 페이스스왑에 사용하여 딥페이크를 구현한 오픈소스 모델인 Faceswap-GAN 모델을 활용하여 ‘인물 사진 체험’ 애플리케이션을 개발하였다[21]. 초기 ‘인물 사진 체험’ 버전에서 발생하였던 합성 부분에서 칼로 잘린 듯한 테두리, 조명 밝기 변화에 따른 테두리의 색 뭉개짐 현상 등을 줄이기 위해 딥러닝 기반의 얼굴 교체(Face Swap) 기술로 대치하였다.

본 연구의 구성은 다음과 같다. 2장에서는 인물 합성의 시작과 딥페이크에 대한 선행 연구를 설명한다. 3장에서는 전시 공간에서 사용된 초기 버전의 오류와 한계를 설명하고, 딥러닝을 적용한 2차 버전의 ‘인물 사진 체험’ 애플리케이션 개발 과정을 서술한다. 4장에서 페이스스왑으로 개발한 ‘인물 사진 체험’ 애플리케이션을 전시관에 설치한 결과를 보여주고 전시 상황에서 안정화를 위한 전시 기술의 필요와 보완 연구에 대한 것으로 설명하고 마무리한다.

Ⅱ. 선행 연구

딥페이크 기술을 원초적으로 정의한다면 사진 조작이라 할 수 있다. 1856년에 구스타브 르 그레이(Gustave Le Gray)는 ‘조합인화’를 선보였는데 밝은 하늘과 어두운 바다를 모두 잘 나오게 하려고 각각의 음화 필름에 담아 하나의 사진으로 인화한 방법을 소개하였다[2]. 이러한 사진 인화 기반의 이미지 합성 기법은 19세기에 개발되어 곧 영화에 적용되었다. 이를 시초로 하여 이미지 합성 기법은 20세기에 컴퓨터 그래픽스 분야에서 꾸준히 발전하여 지금의 딥페이크(Deep Fake) 기술까지 이르게 된다.

딥페이크 기술은 1990년대부터 학술 기관의 연구원들에 의해 개발되었다. 딥페이크는 얼굴 교환, 표정의 변화, 존재하지 않는 사람 얼굴을 생성하는 기술이다. 새로운 얼굴 이미지를 생성하는 데 필요한 얼굴 편집 요소에는 나이, 성별, 민족, 변형, 매력, 피부색 또는 질감, 머리 색깔, 스타일 또는 길이, 안경, 화장, 콧수염, 감정, 턱수염, 자세, 시선, 입을 벌리고 있거나 등의 얼굴 속성을 수정하는 것이 포함된다. 그림 1은 무료로 제공되는 딥페이크 앱을 사용하여 만든 편집의 예를 보여준다. (예: Faceswapper[3], Vindoz[4], Vanceai[5], Artguru[6])

Examples of difference face manipulations: first row- original samples, second row – manipulated samples

딥페이크는 얼굴 교환, 얼굴 재연, 얼굴의 속성 조작, 얼굴 전체 합성의 네 가지 주요 기술로 분류할 수 있다[7]. 본 연구와 가장 밀접한 얼굴 교환 기술은 기존 이미지에서 사람의 얼굴을 다른 사람의 얼굴과 합성하는 기술로 사용자가 원하는 얼굴의 눈, 코, 입, 얼굴형 등의 Identity에 대한 정보(ID 정보)를 제공하고, 사용자의 원본 이미지나 동영상(Reference image/video)에 주어진 ID 정보를 합성해서 새로운 이미지(Generated image/video) 또는 영상을 만든다.

얼굴 교환을 수행하는 방법에는 3D 기반 접근 방식 및 CNN 기반 접근 방식, GAN 기반 접근 방식으로 분류할 수 있다. 2008년 Bitouk의 연구팀은 대규모 이미지 데이터베이스에서 유사도 측정을 기반으로 다른 얼굴로 대치하여 이미지를 생성하는 방법을 개발하였다[8]. Dale의 연구팀은 비디오에서 얼굴을 교체하는 연구를 하였다[9]. 2010년 이후 인공지능을 지원하기 위한 하드웨어의 급격한 성장으로 많은 이미지와 동영상 데이터 학습이 가능해졌다. 그 이후 3D 기반 접근 방식으로 Suwajanakorn의 연구팀은 수많은 이미지로부터 입력 이미지와 교체(Target) 이미지 모두 3D 모델로 구축하여 입력된 얼굴의 표현을 다른 얼굴 표현으로 교체 및 제어할 수 있는 알고리즘을 개발하였다[10]. 얼굴 교환 과정에서 대부분 접근 방식은 얼굴 재구성, 추적, 정렬, 합성 과정의 복잡한 다단계 시스템을 기반으로 한다. 복잡한 다단계 시스템으로 인해 계산시간과 유사도에 따라 정확도가 급격히 저하되는 문제점들이 있다. 이를 해결하는 방법으로 CNN 기반 접근 방식으로 Korshunova의 연구팀은 얼굴 교환 방법을 개발했다. 이들의 결과는 이전 연구보다 더 발전된 이미지 사실성을 보여주었지만, 얼굴이 교환된 부분의 테두리 선이나 예술적 요소와 같은 세부 사항들이 미흡하게 표현되었다[11]. 가장 나중에 개발된 GAN 기반 접근 방식은 StyleGAN[12], Style-GAN2[13]에 의해 합성되는 얼굴이 점점 더 현실적이고 정교한 부분까지 표현되었다. GAN 기반의 얼굴 교환 알고리즘이 최근 많이 사용되는 이유는 데이터셋의 신뢰성 향상을 위해 얼굴 교환 프레임워크를 포함하기 때문이다. 프레임워크 내에서 얼굴 교환 알고리즘의 원리는 두 개의 자동 인코더 모델을 별도로 학습하여 다른 디코더를 사용하는 것이 특징이다[14,15]. 원본과 바꾸고자 하는 교체 이미지의 별도 학습은 더 정교한 결과를 가져왔다. Face Swap과 같은 애플리케이션의 발전은 디지털 성범죄, 가짜 뉴스 등에 악용되어 심각한 사회 문제를 발생시키고 있어 다양한 데이터 기반의 딥페이크 탐지 기술이 개발되고 있다. Sentinel은 정부, 국방, 기업이 딥페이크의 위협을 막을 수 있도록 ‘보호 플랫폼’을 운영하고 있으며, 인텔은 ‘FakeCatcher’, Microsoft는 ‘Video Authenticator Tool’을 개발하여 사진과 비디오를 분석하여 조작 여부를 감지한다[16].

Ⅲ. 전시 공간에 적용한 얼굴 교환 기반 체험 콘텐츠

1. 전시 공간 특성 고려

전시 공간을 이루는 기본적인 요소는 벽, 천장, 바닥이다. 3가지 요소는 입체적 공간을 이루는 하드 요소(Hard Factor)로 볼 수 있으며, 이 안에 들어가는 것은 소프트 요소(Soft Factor)라 할 수 있다. 소프트 요소는 하나하나의 전시물에 해당된다[17]. 이에 맞는 디지털 전시 콘텐츠를 결정해야 하며, 결정한 디지털 전시 콘텐츠는 전시물과 장소, 전시물과 사람, 장소와 사람의 관계를 분석하여 디지털 콘텐츠 개발 기획을 해야 한다. 표 1은 전시관으로부터 요구받은 조건에 맞춰 소규모 전시 콘텐츠 기업의 개발 프로세싱을 정리하였다. 2022년에 제작한 초기 버전의 ‘인물 사진 체험’ 전시 콘텐츠는 목포에 있는 ‘근대음악의 전당’에 설치를 위해 제작되었다. 제작 기간은 2개월로 공간 설치 및 작동 테스트까지 포함한 기간이다. 카메라 인식기반의 관객 참여형인 ‘인물 사진 체험’의 초기 버전은 합성한 부분의 테두리에 노이즈 제거가 완벽히 이루어지지 않았다. 이를 해결하기 위해 개발 기간 3개월을 소요하였으나, 완벽한 해결은 되지 않았다. 2차 버전으로 2023년 Faceswap과 Faceswap_GAN과 같은 오픈 소스를 활용하여 ‘인물 사진 체험’ 애플리케이션을 개발하였고 개발 기간은 2개월로 단축하였다.

2. 얼굴 교환 기반 ‘인물 사진 체험’ 애플리케이션 제작과 문제점

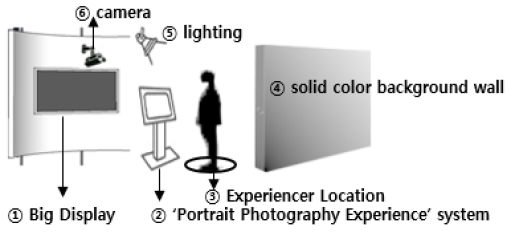

‘인물 사진 체험’의 내용은 1920~1930년대 사이에 유행했던 의류 체험을 위한 의상실 컨셉과 그 시대의 목포 장소를 체험하는 관광지 소개 컨셉을 재현하였다. 전시 공간 구성은 그림 2와 같이 ①번은 관람객이 모두 볼 수 있는 큰 화면이고, ②번은 체험자 얼굴 사진을 처리하는 시스템, ③번은 체험자가 서야 하는 위치 표기 지점이다. ④번은 배경으로 단일 색상의 스크린을 두는 것이 일반적인 설계이다. 제안한 시스템에서는 ⑤번 조명의 위치 조절이 가능하게 하였고, ⑥번의 카메라는 조명의 영향을 받지 않는 곳에 설치하였다.

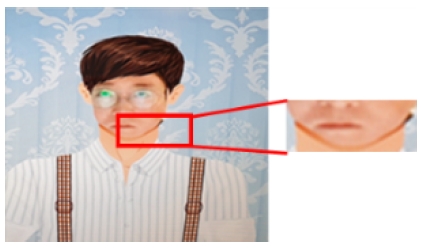

그림 3은 의상실 체험으로 얼굴 합성을 중점으로 개발한 것으로 초기 버전의 ‘인물 사진 체험’ 애플리케이션에서 발생한 문제를 보여준다. 포토샵에서 얼굴의 눈, 코, 입의 위칫값을 유니티에서 제어하는 방법으로 개발하였고, 캐릭터의 얼굴 위치에 마스크로 합성하는 방법이었다. 턱 주변이 자연스럽게 합성되지 않았는데, 전시 공간의 노출 부족이 원인으로 체험자 얼굴의 노출값을 올리기 위하여 천장에 Fomax사의 광량 30W의 LED(litepad 260C, 무제 1kg, 색온도 3,300-5,600K)를 설치하였다. 또한 포토샵을 이용하여 반투명 마스크 필터를 제작하여 원형라인 형태로 입술 밑, 눈썹 위, 귀 안쪽까지의 위치를 인식하는 트래킹 프로그램을 제작하여 적용하였으나 완벽히 제거되지 않았다.

그림 4는 그림 3에서 발생한 얼굴 주변의 어색한 합성을 최소화하기 위해 이미지 합성 부분의 영역을 얼굴과 상반신을 포함한 콘텐츠로 변경하여 제작을 하였다. 배경이미지와 체험자의 상반신을 촬영하여 합성였는데, 입은 옷의 컬러나 뒷 배경의 노출 차이에 따라서 체험자의 상반신 테두리의 색이 잘 추출되지 않은 것을 볼 수 있다. 테두리의 문제점들을 해결하기 위해서 체험자의 위치 보정, 전체 노출보정 필터, 블랜딩 필터를 개발하여 보정하였다. 체험자의 위치 보정은 실내 노출과 얼굴에서 반사하는 노출의 차이로 발생한 것으로 체험자의 머리 위에 조명의 강도와 조명수, 체험자의 서 있는 위치의 표시를 제안하는 표기를 하였다. 노출보정 필터는 얼굴을 인식하는 카메라(웹캠)로 얼굴검출과 노출데이터를 받아 픽셀단위 곱으로 가중치 맵을 생성하여 적용하였다[18]. 블랜딩 필터는 경계선 영역에 블러링을 적용한 것으로 경계선 영역에 모폴로지(morphology) 영상처리 기법인 팽창(Dilatation)을 적용하였다[19].

3. 얼굴 교환 기반 체험 콘텐츠 제작

지역 과학관이나 박물관과 같은 전시장에서 사용하는 디지털 콘텐츠들을 최상의 상태로 전시하기 위해서는 다양하게 발생하는 문제점들을 해결해야 하는데 소규모 전시 콘텐츠 개발 업체가 자체적으로 알고리즘을 개발하여 시스템을 업그래이드하는 것은 시간, 비용 등에서 많은 부담이 된다. 1차 초기 버전은 인공지능을 사용하지 않고 Unity와 포토샵을 활용하여 마스크(mask) 자동 처리 과정과 키잉(keying) 자동 처리 프로그램을 개발하였다. 2차 버전의 ‘인물 사진 체험’ 애플리케이션은 오픈소스의 딥러닝 기반 딥페이크 모델로 널리 알려진 Faceswap과 Faceswap-GAN을 활용하였다[21,22]. 인코더와 디코더, 판별자(discriminator) 학습을 위해 사용한 데이터셋은 총 20,000장으로 원본이미지와 딥페이크 이미지를 합쳐서 1:1의 비율로 구성하였으며, 모델의 입력 차원에 맞추어 256×256의 레졸루션으로 리사이즈된 3채널의 이미지가 각 데이터로 사용되었다.

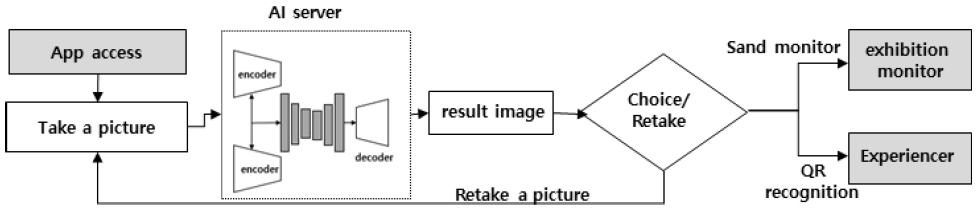

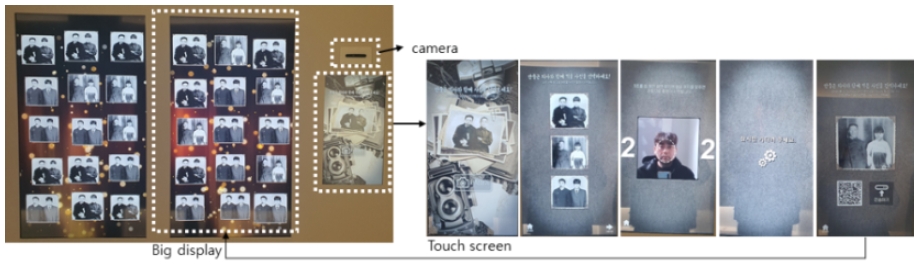

그림 5는 ‘인물 사진 체험’ 애플리케이션에서의 데이터 흐름을 설명하고 있다. 전시에서 처음 보이는 화면(App Access)은 애플리케이션 정보를 설명하고 간단한 UI를 통해 22인치의 터치모니터에서 시작버튼 하나로 시작하도록 하였다. 지원하는 시스템은 AI 엔진이 구동되는 고성능의 GPU가 필요하지만 국내의 전시관 상황은 대부분은 지원 예산이 작아 불가능할 때가 많다. 이를 고려하여 CPU 구동만으로도 가능한 오픈 소스 Faceswap_GAN을 선택하였다. 최종적으로 합성된 이미지는 체험자(관람객)에게 QR을 통한 배포와 대형 모니터로 전송된다.

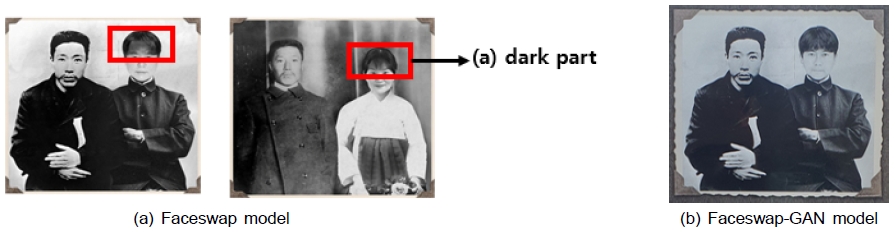

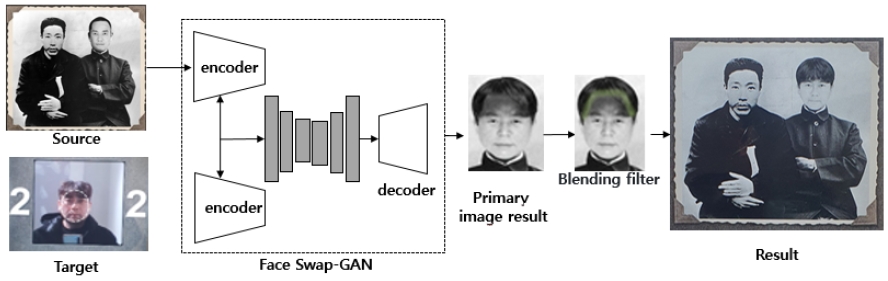

그림 6의 (a)는 Faceswap 모델을 사용했을 때 이마 부분이 어둡게 나오거나 생략되어 나오는 현상을 보였다. 2개의 훈련 데이터 세트가 피부색 분포(빛 상태, 그림자 등)가 다를 때 입출력 피부색 불일치가 발생하는 것으로 나타났다. 또한 체험자가 안경을 착용했을 때도 안경의 모습이 흐릿하게 표현이 되었다. 이를 수정하기 위해 학습 과정에 알파마스크를 포함하는 방법을 시도하였다. Faceswap 모델에서는 알파마스크를 추가하여 재학습하는데에 적합하지 않아, Faceswap-GAN 모델로 교체하여 학습을 하였다. 이 과정에도 큰 변화가 없어 1회차 생성된 출력 이미지(가짜 타겟 얼굴 이미지)를 입력으로 반복 학습하였다. 그림 7은 보완작업 과정을 설명한 개요이다.

Faceswap-GAN의 학습을 위해 Keras, TensorFlow, Python, Keras-vggface, Prefetch_generator, Face-alignment을 설치해야 한다. Prefetch_generator는 딥러닝을 위해 데이터의 미니배치를 반복적으로 처리할 때 계산량이 많아 CPU의 시간을 감소하기 위한 작업으로 사용하였다. 전처리 과정을 위한 face-alignment는 2D 및 3D 이미지 모두에서 사용할 수 있는데 얼굴의 랜드마크를 감지하는 역할을 한다. 가중치는 오픈된 MTCNN을 가져와 사용하였다[20]. 학습 모델로는 Resnet50을 사용하였다. 상기 기술한 데이터셋을 통해 학습이 완료된 인코더에 target 이미지가 입력되면 잠복면(latent face) 추출이 수행되며, 추출된 잠복면은 사전 학습된 디코더에 의해 재구성된 얼굴 이미지로 변환이 이뤄진다. 대부분의 딥러닝 모델들과 마찬가지로 빠른 추론속도에 반해 모델 학습에 많은 메모리와 연산량을 필요로 하므로, 학습 이후 발생되는 사소한 문제에 대해서는 추가 필터를 사용하여 수정 보완하는 방식을 통해 전시장에서의 재학습이 요구되는 상황을 최대한 회피하였다. 학습 이후 수정할 수 없는 설정 값은 Resolution, Face type, AE architecture, AutoEncoder dimensions, Encoder dimensions, Decoder dimensions, Decoder mask dimensions 등이 있어서 최종 단계에서 파라미터로 수정 가능한 블랜딩 필터를 추가하였다.

Ⅳ. 인물 사진 체험 결과

‘인물 사진 체험’ 애플리케이션은 2024년 3월 장흥 안중근추모기념관에 전시되었다. 그림 8은 안중근 의사와 사진을 찍어보세요! 라는 주제로 오프라인 전시 공간의 키오스크 방식을 이용하는 시작 화면이다. 화면 상단에 타이틀 및 체험 안내 문구가 표시되고 시작 버튼을 터치하여 체험을 시작한다. 사진 선택 화면은 시대적 배경과 맞는 의상을 기준으로 체험자의 얼굴이 합성될 3종의 선택 사진으로 구성된다. 세 번째 이미지는 흰색의 타원형 안에 체험자의 얼굴이 맞춰지면 5초 후 자동으로 촬영되는 화면이다. 합성사진 결과가 나오기까지의 대기 시간은 조금씩 차이가 있지만 평균적으로 2초 정도 소요되었다. 그림 8의 오른쪽 마지막 이미지는 안중근 의사와 체험자가 합성된 결과 사진과 결과 사진을 체험자의 핸드폰으로 전송할 수 있는 QR코드이다. QR코드 옆 버튼은 전시장의 대형 화면으로 사진을 보내는 전송 버튼이다. 대형 화면으로 사진을 전송하면 화면 중앙에 체험자의 사진이 비주얼 이펙트 효과와 함께 노출되었다가 다른 체험자들의 사진과 함께 표현된다. 우측의 대형 모니터에는 화면에 노출되는 사진의 수량을 20장으로 지정하고 새로운 사진이 업로드될 때마다 하나씩 지워지도록 하여 20장이 유지되도록 하였다. 설치 이후 안정된 상태를 모니터링하기 위해 별도의 모니터링 프로그램을 제작하여 체험자들의 체험 모습을 모니터하며 로깅(loggig) 데이터를 확보하였다. 또한 체험자들의 합성 결과물을 통해서도 다양한 변수 및 수정 방향을 확보하였다. 이를 통해 전시관 체험객들이 전시관 내의 다양한 콘텐츠 중 가장 많이 체험하는 콘텐츠의 비중을 확인하였으며 향후 콘텐츠 제작의 방향을 제시할 수 있었다.

표 2는 ‘인물 사진 체험’ 시스템을 1차 버전(AI 적용 이전)과 2차 버전(AI 적용 이후)의 차이를 비교 분석하고, 체험자 만족도 검사를 시행하였다. 만족도 검사에 참여한 체험자는 2024년 3월 장흥 안중근추모기념관에 설치한 후 시스템 안정화를 위해 2일간 참여한 기념관 관계자와 관람자 포함하여 50인을 대상으로 조사하였다. AI 적용 이전 조사는 2022년 근대음악의 전당에 설치 이후 방문자들이 남기고 간 체험 댓글에 대한 조사를 바탕으로 하였다. 만족도 질문에는 재미, 사진의 질, 사진의 소장 가치성, 체험을 위한 대기 시간, 시스템 조작 5개에 대한 답변으로 이루어졌으며, 49%에서 95% 향상으로 조사되었다. 기관 관계자들의 요구가 가장 차이가 나는 부분은 유지보수의 개념에서 업데이트의 개념으로 바뀌었다는 것이다. 기존에 유지보수의 개념은 하드웨어나 소프트웨어의 이상이 발생하는 때에만 표현하는 개념이었다면 최근의 유지보수는 최상의 만족도를 위한 소프트웨어의 지속적인 업데이트를 말한다. 예를 들어 인물 합성의 배경, 인물 추가, 표현 방식 변경 등 다양한 업데이트를 유지보수 개념에 포함하여 디지털 전시 콘텐츠의 체험 재미를 극대화할 수 있도록 기관이 요구하고 있다.

Ⅴ. 결 론

디지털 전시 콘텐츠를 개발하는 소규모 기업은 짧은 개발 기간과 저가의 비용으로 개발해야 하는 열악한 환경에서 최대의 전시 효과를 가져와야 한다. 본 논문은 오픈 소스 Faceswap-GAN을 활용하여 얼굴 교환을 목적으로 ‘인물 사진 체험’ 애플리케이션 개발하고, 안중근추모기념관에 설치한 과정을 소개하였다. 기념관과의 계약, 개발과 설치까지의 기간이 약 2개월로 얼굴 교환에서 발생하는 테두리의 어색한 합성 문제를 오픈 소스 Faceswap-GAN을 사용하여 해결하였지만, 데이터셋 구축, 데이터 학습, 데이터 변환, Unity에 적용, 결과 이미지 전송에 관련된 프로그램을 모두 개발하는 데는 역부족인 시간이었다. 또한 한번 학습된 데이터를 정확도 향상과 테스트 셋이 변경되어 수정 기간도 오래 걸렸다. 전시 공간 특성상 다양한 변수가 존재하고, 오픈소스로 개발하는 것이 원하는 만큼 품질이 나오지 않기 때문에 전시 안정화를 위한 후반 작업이 필요하다. 또한 소규모 디지털 전시 콘텐츠 기업은 대부분 소프트웨어 개발자를 보유하고 있지 않고 단기 계약으로 개발자에게 용역을 주는 경우가 많다. 디지털 전시 콘텐츠 개발 과정을 소개함으로써 열악한 디지털 전시 콘텐츠 개발 시장에 인공지능 기반의 오픈소스 활용을 통한 품질 개선이 다양한 방법으로 적용되길 기대한다.

References

- Wikimedia Foundation, Inc., https://en.wikipedia.org/wiki/Deepfake, , (accessed July. 22, 2024)

- Wikimedia Foundation, Inc., https://en.wikipedia.org/wiki/Gustave_Le_Gray, , (accessed July. 22, 2024)

- Faceswapper AI. Inc., https://faceswapper.ai/swapper, , (accessed July. 22, 2024)

- Vidnoz. Inc., https://www.vidnoz.com/face-swap.html, , (accessed July. 22, 2024)

- VanceAI Technology. Inc., https://vanceai.com/ai-portrait-generator/, (accessed July. 22, 2024)

- Artguru.ai. Inc., https://www.artguru.ai/swap-face/, (accessed July. 22, 2024)

-

Z. Akhtar, “Deepfakes Generation and Detection: A Short Survey,” Journal of Imaging, Vol.9, No.1, pp. 1-16. January 2023.

[https://doi.org/10.3390/jimaging9010018]

-

D. Bitouk, N. Kumar, S. Dhillon, P. Belhumeur, and S. K. Nayar. “Face Swapping: Automatically Replacing Faces in Photographs,” In ACM Transactions on Graphics (SIGGRAPH), Vol. 27, Issue 3, pp. 1 – 8, August 2008.

[https://doi.org/10.1145/1360612.1360638]

-

K. Dale, K. Sunkavalli, M. K. Johnson, D. Vlasic, W. Matusik, and H. Pfister. “Video Face Replacement,” ACM Transactions on Graphics (SIGGRAPH), Vol. 30, Issue 6, pp. 1–10, December 2011.

[https://doi.org/10.1145/2070781.2024164]

-

S. Suwajanakorn, S. M. Seitz, and I. Kemelmacher-Shlizerman, “What makes Tom Hanks look like Tom Hanks,” In 2015 IEEE International Conference on Computer Vision, ICCV 2015, Santiago, Chile, pp. 3952–3960, December 2015.

[https://doi.org/10.1109/ICCV.2015.450]

-

I. Korshunova, W. Shi, J. Dambre and L. Theis, “Fast Face-Swap Using Convolutional Neural Networks,” In Proceedings of the IEEE International Conference on Computer Vision (ICCV), Venice, Italy, pp. 3697–3705, October 2017.

[https://doi.org/10.48550/arXiv.1611.09577]

-

T. Karras, S. Laine, and T. Aila, “A Style-based Generator Architecture for Generative Adversarial Networks,” In Proceedings of the IEEE Transactions on Pattern Analysis and Machine Intelligence, Vol. 43, pp. 4401–4410, December 2019.

[https://doi.org/10.1109/TPAMI.2020.2970919]

-

T.ero Karras, S. Laine, M. Aittala, J. Hellsten, J. Lehtinen and T. Aila, “Analyzing and Improving the Image Quality of StyleGAN,” IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), pp. 8107-8116, August 2020.

[https://doi.org/10.1109/CVPR42600.2020.00813]

- C. Wang and J. Jang, “Deep face swap with GAN”, Stanford CS 230 Projects, 2019.

- GitHub, Inc., https://github.com/shaoanlu/faceswap-GAN, , (accessed July. 22, 2024)

-

J. A. Hong and S. K. Kim, “A Study on the Basic Direction of Interaction Exhibition Content Based on the Fourth Industrial Revolution Technology,” Journal of Integrated Design Research, Vol. 20, No. 3, pp.75-88, September 2021.

[https://doi.org/10.21195/jidr.2021.20.3.005]

- Alex McFarland, “Best Of5 Best Deepfake Detector Tools & Techniques” Unite.AI, August 1, 2024. https://www.unite.ai/ko/best-deepfake-detector-tools-and-techniques/, , (accessed August. 22, 2024)

-

I.J. Park, D. J. Park and J. C. Jeong, “Modified Exposure Fusion with Improved Exposure Adjustment Using Histogram and Gamma Correction”, Journal of the Korean Institute of Broadcast and Media Engineers, Vol. 22, No. 3, May 2017.

[https://doi.org/10.5909/JBE.2017.22.3.327]

-

J. Canny, “A Computational approach to edge detection,” IEEE Trans. on Pattern Analysis and Machine Intelligence, Vol. 8, No. 6, pp. 679-698, November 1986.

[https://doi.org/10.1109/TPAMI.1986.4767851]

- GitHub, Inc., https://github.com/iart-ai/FaceSwap-API, , (accessed July. 22, 2024)

- faceswap-GAN, https://github.com/shaoanlu/faceswap-GAN, , (accessed August. 22, 2024)

- faceswap, https://github.com/deepfakes/faceswap, , (accessed August. 22, 2024)

- 2010년 ~ 현재 : (주)타임미디어 대표

- 2023년 8월 : 공주대학교 동양학과 박사졸업

- 2023년 9월 ~ 현재 : 덕성여자대학교 박사과정

- ORCID : https://orcid.org/0009-0002-7988-5042

- 주관심분야 : 전시콘텐츠, 딥러닝

- 1998년 3월 : 큐슈대학교 정보전달학과 석사

- 2009년 2월 : 중앙대학교 첨단영상대학원 박사

- 2010년 ~ 현재 : 덕성여자대학교 가상현실융합학과 교수

- ORCID : https://orcid.org/0000-0002-3725-0025

- 주관심분야 : 멀티미디어, 인터랙티브아트, UX/UI, 딥러닝