학습기저함수 기반 3D 메쉬 텍스쳐 맵 생성 기법

Copyright © 2024 Korean Institute of Broadcast and Media Engineers. All rights reserved.

“This is an Open-Access article distributed under the terms of the Creative Commons BY-NC-ND (http://creativecommons.org/licenses/by-nc-nd/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited and not altered.”

초록

본 논문은 고정된 함수의 구면 조화함수(Spherical Harmonics, SH) 대신 딥러닝을 활용하여 학습된 기저함수에 기반하여 3D 메쉬(mesh) 텍스쳐 맵을 생성하는 방법을 제안한다. 구면 조화함수를 이용한 메쉬 텍스쳐 맵 생성 방법은 기존의 렌더링 파이프라인(pipeline)에 잘 통합되어 널리 사용되고 있으나, 기저함수가 고정되어 있다는 제약으로 인해 입력 다시점 영상의 세밀한 특성을 잘 반영하지 못하는 텍스쳐 맵이 생성된다. 그로 인해 구면 조화함수 기반의 생성된 텍스쳐 맵을 이용해 임의 시점에 대한 영상을 합성했을 때 주관적인 화질 저하가 발생한다. 본 연구는 이러한 문제를 해결하기 위해 경량화된 MLP(Multi-Layer Perceptron) 레이어들로 구성된 기저함수 학습 네트워크를 통해 입력 다시점 영상에 최적화된 기저함수를 바탕으로 렌더링 화질을 개선하는 메쉬 텍스쳐 맵을 생성하는 방법을 제안한다. 제안된 학습 기저함수 네트워크를 통해 생성된 메쉬 텍스쳐 맵은 기존 방법 대비 동일 합성된 임의 시점에서 개선된 주관적 화질을 보인다.

Abstract

This paper proposes a method for generating mesh texture maps based on basis functions learned through deep learning, as opposed to the fixed basis function of Spherical Harmonics. While the traditional method using Spherical Harmonics for mesh texture mapping is well integrated with existing rendering pipelines and is widely used, it generates texture maps that fail to reflect the fine features of input multi-view images, resulting in a subjective quality degradation when synthesizing a novel view. To address this issue, this paper proposes a method for generating enhanced mesh texture maps by learning optimized basis functions for input multi-view images through a lightweight Multi-Layer Perceptron (MLP) layers network. The mesh texture maps created through the proposed learned basis function network demonstrate improved subjective quality when synthesizing a novel view.

Keywords:

3D representation, Mesh, Texture map, Learnable basis, MLPⅠ. 서 론

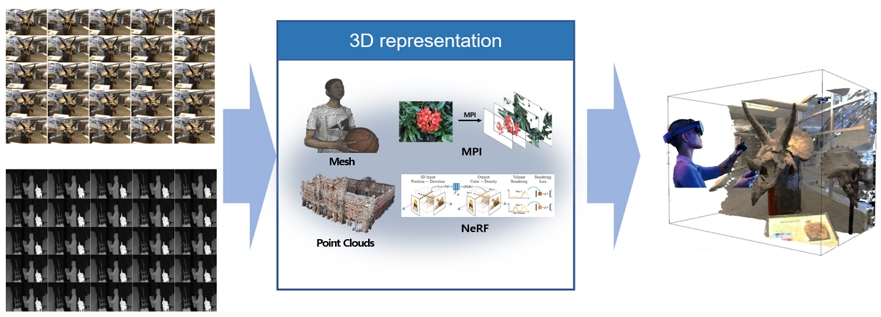

최근 메타버스에 대한 관심이 증가하고 3D 캡처 및 디스플레이 시스템의 기술 발전으로 인해 VR/AR, 홀로그램 등의 콘텐츠와 함께 컴퓨터 그래픽스, 3D 디스플레이, 게임 산업과 같은 실감 미디어에 대한 수요가 증가하고 있다. 이에 따라 현실 세계에서 포착한 3D 콘텐츠로 가상 공간으로 생성하려는 시도가 증가하고 있다. 보다 사실적인 3D 콘텐츠를 사용자에게 제공하기 위해서 다시점(multi-view) 2D 입력 영상을 통해 3D 콘텐츠를 생성하여 사용자가 원하는 가상 시점 생성 기술에 대한 연구가 이뤄지고 있고, 그림 1과 같이 메쉬(mesh)[1,2], MPI(Multi-Plane Image)[3], 포인트 클라우드(point cloud), NeRF(Neural Radiance Field)[4] 등 다양한 3D 표현 기술들이 연구되고 있다. 이 중, 메쉬는 3D 모델 데이터를 저장하고 렌더링하는 데 가장 널리 사용되는 3D 장면 표현 방법 중 하나로 메쉬 기하는 정점(vertex)이라고 하는 점의 집합과 이 정점들을 연결하여 평평한 면을 정의하는 연결 구조로 구성된다. 생성된 메쉬에 대해서 UV 언래핑(unwrapping)[5]을 통해 각 메쉬 정점에 UV 좌표(텍스쳐 좌표)를 할당하고, 이 좌표를 사용해 메쉬 표면의 점을 텍스쳐 맵의 해당 화소에 매핑하여 텍스쳐 맵을 생성한다[6]. 이렇게 생성된 고해상도 텍스쳐 맵은 메쉬가 나타내는 기하 구조를 넘어서 더 섬세하고 상세한 시각적 표현을 3D 메쉬 표면에 제공한다.

이 때, 최근 MPI, NeRF, Gaussian Splatting와 같이 딥러닝 기반의 3D 표현 생성 기술에 많이 활용되는 구면 조화함수(spherical homonic function)를 이용해 생성된 메쉬 텍스쳐 맵은 기존의 시점 별로 텍스쳐 맵을 생성하는 방법이 아닌 빠른 학습 속도와 실시간 렌더링이 가능하고, 훨씬 적은 데이터 양으로 고품질의 이미지 생성이 가능하다는 장점이 존재한다. 하지만, 구면 조화함수는 시점 방향에 따른 고정된 기저함수에 대응되는 계수를 가지고 텍스쳐 맵을 생성하기 때문에 전체적인 구조는 잘 표현할 수 있지만, 3D 메쉬 표면의 미세한 텍스쳐나 복잡한 표면을 포착하는데 한계가 존재한다. 이를 해결하기 위해 본 논문에서는 적은 MLP로 구성된 기저함수 학습 네트워크를 통해 영상 특성에 맞는 최적화된 기저함수와 고품질의 텍스쳐 맵을 생성하는 방법을 제시한다. 제안하는 방법의 성능향상을 검증하기 위하여 구면 조화함수 기반의 메쉬 텍스쳐 맵을 렌더링하여 생성한 임의 시점 영상과 주관적 화질 및 객관적 화질을 비교한다.

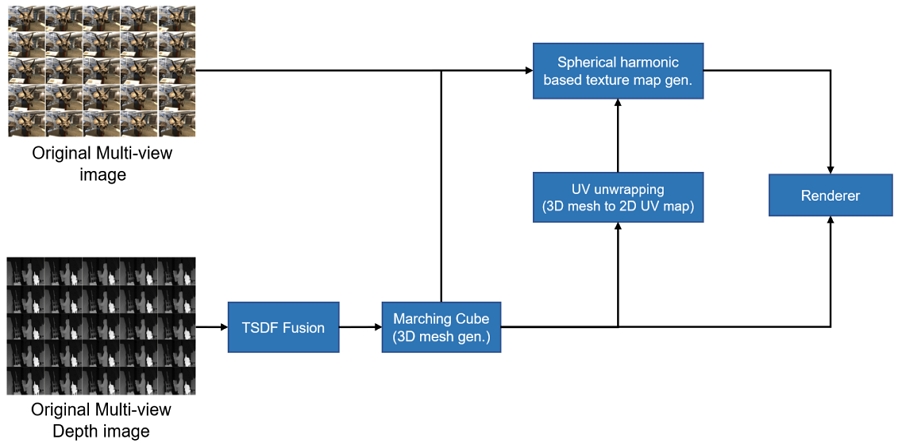

본 논문의 구성은 다음과 같다. 2장에서는 그림 2와 같이 3D 메쉬 텍스쳐 맵 생성 과정에서 사용되는 기술을 소개하고, 3장에서는 본 논문에서 제시하는 기저함수 학습 네트워크를 설명한다. 4장에서는 실험결과를 확인하고 마지막으로 5장에서 결론을 맺는다.

Ⅱ. 3D 메쉬 텍스쳐 맵 생성

본 장에서는 그림 2와 같이 전체적인 3D 메쉬 텍스쳐 맵 생성 과정에서 사용되는 주요 기술에 대한 설명과 구면 조화함수 기반의 텍스쳐 맵 생성 방법에 대해 기술한다.

1. 절삭된 부호 거리 필드(TSDF) 융합

TSDF(Truncated Signed Distance Field)[7] 융합은 컴퓨터 비전 및 3D 데이터 재구성 분야에서 핵심적인 데이터 구조로, 복잡한 3차원 환경을 정확하고 효율적으로 구성할 수 있는 방법이다. 깊이 센서로부터 얻은 다시점의 깊이 영상을 통합하여 하나의 스칼라 필드(D(x))로 결합하여 연속적인 3D 공간에서 객체의 표면을 세밀하게 구성하고, 이를 식 1과 같이 정의한다:

| (1) |

여기서 x는 중심에 의해 정의된 복셀의 위치이다. wi(x)는 깊이 정보의 신뢰도에 따라 각 측정에 할당된 가중치이며 복셀(voxel)의 업데이트가 필요한 경우 1, 필요가 없는 경우에는 0의 값을 가진다. di(x)는 i번째 깊이 영상에서 캡처된 표면과 복셀 중심 위치와의 근접성을 측정하는 부호 거리 함수이고, 이 부호 거리는 입력 깊이 영상, 카메라 내부 파라미터 정보와 입력 영상 별 변환 행렬 정보를 통해 구한다. 이 거리 값은 표면으로부터의 실제 거리를 재는 것이 아니라 임계값으로 절단된 거리를 사용하여 저장하고 이를 통해 불필요한 데이터의 축적을 방지하고 메모리 사용을 최적화한다.

2. 마칭 큐브 알고리즘

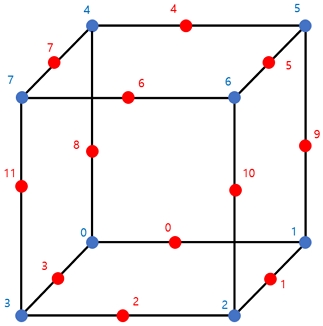

마칭 큐브(marching cubes) 알고리즘[8,9]은 3차원 데이터에서 삼각형 메쉬를 추출하는데 널리 사용되는 기술로, TSDF를 통해 생성된 복셀의 여덟 개 꼭짓점을 포함하는 큐브를 순차적으로 탐색한다. 각 큐브는 그림 3과 같이 복셀 그리드에서 정의된 구조로 복셀 간의 12개 모서리와 함께 색인화 되어있다. 각 큐브가 표면을 어떻게 자르는지를 결정하는 8비트 구성 인덱스에 의해 결정되어 256가지 가능한 큐브 구성이 존재하고, 룩업(look-up) 테이블[10]을 사용하여 각 구성에 대한 메쉬 토폴로지(topology)를 정의하는 에지 시퀀스를 포함한다. 구성 인덱스에 따라 여러 개의 삼각형들이 구성되고, 이 삼각형들은 각각의 버텍스 위치가 해당 에지의 복셀에서 선형 보간을 통해 계산되는 3차원 좌표를 통해 형성한다. 마칭 큐브 알고리즘을 통해 각 큐브에 대한 로컬 메쉬가 추출되며, 최종적으로 전체 3차원 장면의 메쉬로 통합된다.

3. 구면 조화함수 기반 텍스쳐 맵 생성

마칭 큐브 알고리즘을 통해 생성된 메쉬에 대해서 UV 언래핑을 수행하여 각 메쉬 정점에 UV 좌표(텍스쳐 좌표)를 할당하고, 이 좌표들을 활용하여 메쉬 표면의 점을 UV 맵의 해당 픽셀에 매핑함으로써 텍스쳐 맵을 생성한다. 이 과정에서 텍스쳐 맵은 입력 다시점 영상들에 대해 렌더링된 영상 간 모든 픽셀 위치에서의 왜곡의 합을 손실함수로 사용하여 손실을 최소화하도록 텍스쳐 맵을 지속적으로 업데이트한다. 이 최적화 과정은 여러번 반복 실행되며 L1 손실함수를 통해 왜곡을 계산한다. 이러한 최적화를 수행하여 텍스쳐 맵을 생성할 때, 시점 독립 텍스쳐 맵과 시점 종속 텍스쳐 맵을 분리하여 생성한다. RGB 3채널로 구성된 시점 독립적 텍스쳐 맵은 모든 시점에서 일관된 품질로 렌더링할 수 있도록 최적화되지만, 빛 반사와 같이 시점 변화에 따라 텍스쳐가 변하는 표면을 렌더링할 때 성능이 저하된다. 이를 해결하기 위해 구면 조화함수[11][12]를 기반으로 한 시점 종속적 텍스쳐 맵을 추가로 최적화한다. 시점 종속적 텍스쳐 맵은 시점 방향을 입력으로 받아서 계산된 구면 조화함수에 대응하는 종속 성분을 반영하는 계수를 가지도록 최적화된다. 시점 독립적 텍스쳐 맵과 시점 종속적 텍스쳐 맵은 동시에 최적화되고, 최종적으로 렌더링된 영상은 각각 최적화된 시점 독립적 및 시점 종속적 텍스쳐 맵에 대한 렌더링 결과를 더하여 생성되며 식 2와 같이 정의된다.

| (2) |

여기서 , 는 각각 렌더링된 시점 독립 영상과 시점 종속 영상을 의미하고, 는 최종 렌더링된 영상을 의미한다. 시점 종속 영상의 경우, 식 3과 같이 9개의 구면 조화함수에 대응되는 시점 종속 텍스쳐 맵의 9개의 계수를 곱하여 모두 더해 한 채널의 시점 종속 영상을 생성하고, 시점 독립 영상과 더하기 위해 3채널로 복사한다.

| (3) |

Ⅲ. 학습기저함수 기반 텍스쳐 맵 생성

본 장에서는 2장에서 기술한 3D 메쉬 텍스쳐 맵 생성 파이프라인에 기반하여 학습 기저함수 네트워크를 통해 텍스쳐 맵을 최적화하는 방법을 제안한다. 또한, 학습 기저함수 네트워크의 구조 및 학습 기법에 대해 기술한다.

1. 네트워크 구조

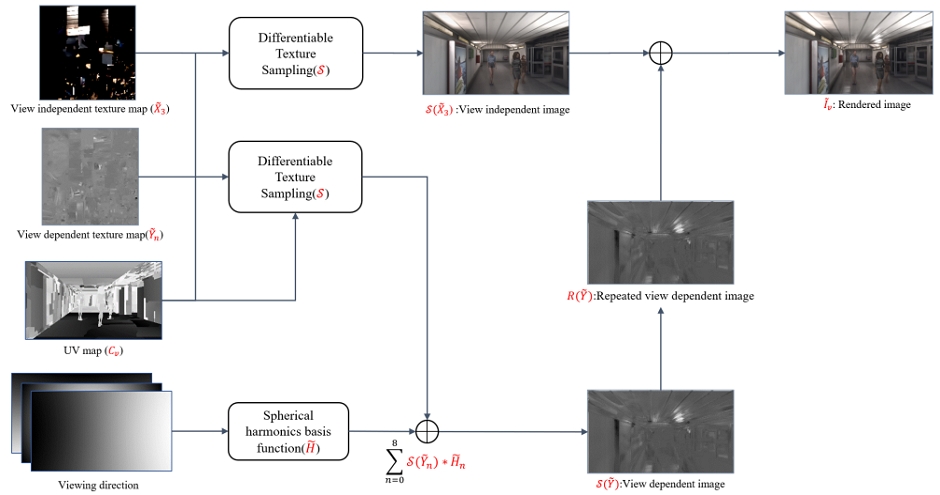

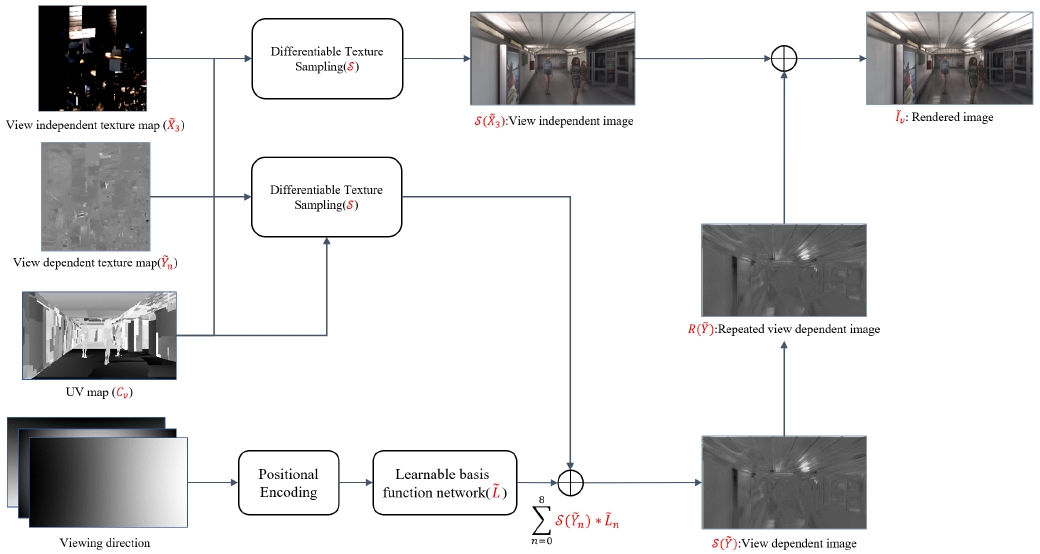

제안된 학습 기반 함수 네트워크를 이용한 3D 메쉬 텍스쳐 맵 생성 파이프라인은 그림 5에 나타나 있으며, 이는 기존의 구면 조화함수를 학습 기반 함수 네트워크로 대체하여 구성된다. 최적화 과정은 구면 조화함수를 사용했던 방식과 동일하게 수행되며, 제안된 방법에서는 시점 방향을 네트워크의 입력으로 사용하기 전에 위치 부호화(positional encoding)를 통해 시점 방향의 채널 수를 확장한다. 이렇게 확장된 시점 방향은 세 개의 MLP 레이어를 거치며, 각 레이어 사이에는 LeakyReLU 활성화 함수가 적용된다. 렌더링 과정의 복잡성을 최소화하기 위해 중간의 두 MLP 레이어는 각각 64개의 작은 채널을 사용한다. 최종 레이어는 학습된 기저함수를 출력하고, 시점 종속적 텍스쳐 맵은 네트워크를 통해 얻은 학습된 기저함수에 대응하는 종속 성분을 반영하는 계수를 가지도록 최적화된다. 시점 독립적 텍스쳐 맵과 시점 종속적 텍스쳐 맵은 학습 기반 함수 네트워크와 함께 동시에 학습되며, 최종 렌더링된 영상은 최적화된 시점 독립적 및 시점 종속적 텍스쳐 맵의 렌더링 결과를 더하여 생성된다. 시점 종속 영상의 경우, 구면 조화함수를 사용했던 기존 방식과 유사한 데이터 량 대비 성능을 비교하기 위해 식 4와 같이 9개의 생성된 기저함수에 대응되는 시점 종속 텍스쳐 맵의 9개의 계수를 곱하여 모두 더해진 한 채널의 시점 종속 영상을 생성하고, 시점 독립 영상과 더하기 위해 3채널로 복사한다.

| (4) |

2. 학습 기법

제안된 텍스쳐 맵 생성 파이프라인의 학습 과정 중 사용하는 복원 손실함수(Lrec)는 256x256 패치에 대해 식 5와 같이 원본 영상(In)과 최종 렌더링된 영상 간의 왜곡과 원본 영상(In)과 시점 독립 영상 간의 모든 화소 위치에서의 왜곡의 합이 최소화가 되도록 한다. 이 때, 렌더링된 임의 시점의 주관적 화질을 높이기 위해서 L1 손실함수와 MS-SSIM(Multi-Scale Structural Similarity) 손실함수를 조합하여 복원 손실함수로 사용한다.

| (5) |

또한, UV 언래핑 과정을 통해 생기는 메쉬 표면 경계에서 발생하는 아티팩트(artifact)를 완화하기 위해 식 6과 같이 추가로 임의 시점에 대해 렌더링한 영상에 대한 전체 변동 손실함수(Total Variation, TV)를 더하여 최종 손실함수(Ltotal)를 계산한다. 최종 손실 함수를 통해 최적화하는 과정에서 학습 속도를 효율적으로 하기 위해 Adam 최적화기에서 일정 횟수가 반복될 동안 손실함수가 줄어들지 않는 경우 학습률 감소를 수행하고, 학습률이 일정 이하가 되면 학습을 조기 종료한다. 네트워크가 매우 경량화된 MLP 레이어로 구성되어 있기 때문에 제안 방법의 학습에 걸리는 시간은 구면 조화함수 기반 텍스쳐 맵 최적화에 소요되는 시간과 차이가 나지 않는다.

| (6) |

학습을 위한 데이터 셋의 경우, 그림 6과 같이 21x21 RGB-D 카메라 어레이로 구성된 1920x1080의 해상도를 가지는 3개의 다시점 8비트 RGB 셋 중 일부를 사용한다. 학습에 사용되는 영상은 21x21 카메라 어레이 중 일정한 간격을 가지는 5x5 RGB-D 카메라 어레이로 25개의 영상으로 구성된다. 학습에 사용되지 않은 영상은 실험결과를 비교하는데 사용된다.

Ⅳ. 실험결과

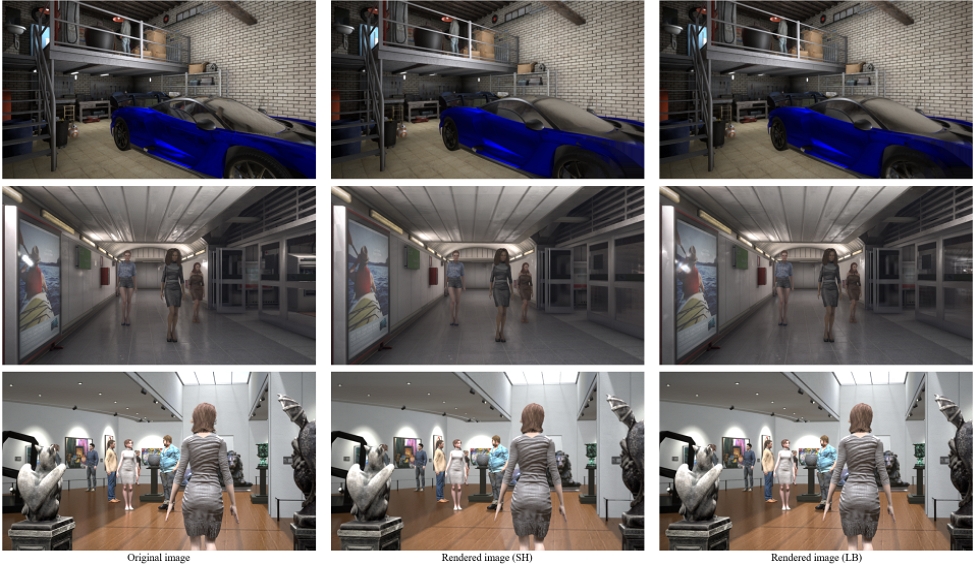

본 논문의 실험은 데이터 셋 별로 구면 조화함수 기반의 텍스쳐 맵 생성과 제안하는 방법을 통해 렌더링한 영상을 통해 성능을 비교한다. 성능을 비교하기 위해서 데이터 셋 별로 학습에 사용되지 않은 임의 시점에 대해 렌더링한 영상에 대해 주관적 화질 비교와 객관적 화질 비교를 수행하였다. 객관적 화질 평가의 경우, 임의 시점에 대한 원본 영상과 렌더링한 영상 간의 PSNR과 MS-SSIM을 이용해 객관적 화질 평가를 측정하였다. 표 1은 객관적 화질 평가의 결과를 보여주고 구면 조화함수에 비해 제안하는 방법을 통해 렌더링한 영상이 PSNR과 MS-SSIM 모두 나은 성능을 보이는 것을 확인할 수 있다. 그림 6은 임의 시점에 대한 원본 영상과 렌더링한 영상 간의 주관적 화질을 비교한다. 제안 방법을 통해 렌더링 된 영상이 원본 영상의 객체 혹은 거울과 같은 표면에 반사되는 빛을 보다 잘 반영하고 있음을 확인할 수 있다.

Ⅴ. 결 론

최근, 다양한 3D 공간의 임의 시점 합성을 위한 연구들에서 공통적으로 구면 조화함수가 활용되고 있다. 본 논문에서는 렌더링 성능을 높이기 위해서 구면 조화함수 기반의 텍스쳐 맵 학습이 아닌 데이터 셋에 최적화된 기저함수와 그에 대응되는 텍스쳐 맵을 학습하는 방법을 제안하였다. 제안하는 방법은 기존의 구면 조화함수와 비교하였을 때, 객관적 화질과 주관적 화질 모두 원본과 보다 유사한 결과를 렌더링한다. 본 논문에서는 렌더링 성능을 높이는 것에 초점을 맞췄지만, 전송되어야 할 텍스쳐 맵의 데이터 양을 줄이기 위해 텍스쳐 맵 압축율을 높이면서 렌더링 성능을 유지할 수 있도록 하는 연구가 추가적으로 필요하다. 또한, 네트워크를 사용함에 따라 추가적으로 발생하는 파라미터들에 대한 효율적인 전송 방법이 필요하다.

Acknowledgments

이 논문의 연구 결과 중 일부는 한국방송·미디어공학회 “2024년 하계학술대회”에서 발표한 바 있음.

This work was supported by Institute for Information & communications Technology Planning & Evaluation (IITP) grant funded by the Korea government (MSIT) (No. 2017-0-00072, Development of Audio/Video Coding and Light Field Media Fundamental Technologies for Ultra Realistic Tera-media)

References

-

S. Kim and J. Kang, “Voxel‐wise UV parameterization and view‐dependent texture synthesis for immersive rendering of truncated signed distance field scene model,” ETRI Journal, vol. 44, no. 1. Wiley, pp. 51–61, 2022.

[https://doi.org/10.4218/etrij.2021-0300]

-

Worchel, M., Diaz, R., Hu, W., Schreer, O., Feldmann, I. and Eisert, P., “Multi-View Mesh Reconstruction With Neural Deferred Shading,” Proceedings Of The IEEE/CVF Conference On Computer Vision And Pattern Recognition, pp.6187-6197, 2022.

[https://doi.org/10.1109/CVPR52688.2022.00609]

-

Richard Tucker and Noah Snavely, “Single-view view synthesis with multiplane images,” Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pp.551–560, 2020.

[https://doi.org/10.1109/CVPR42600.2020.00063]

-

Ben Mildenhall, Pratul P Srinivasan, Matthew Tancik, Jonathan T Barron, Ravi Ramamoorthi, and Ren Ng. “Nerf: Representing scenes as neural radiance fields for view synthesis,” Proceedings Of European Conference on Computer Vision, pp.405–421,2020.

[https://doi.org/10.1007/978-3-030-58452-8_24]

- Jonathan Young, jpcy/xatlas: UV unwrapping library. https://github.com/jpcy/xatlas.git, (2022)

-

S. Kim, J. Do, J. Kang and H. Y. Kim, “Rate-Rendering Distortion Optimized Preprocessing for Texture Map Compression of 3D Reconstructed Scenes,” IEEE Transactions on Circuits and Systems for Video Technology, vol. 34, no. 5, pp. 3138-3155, May 2024.

[https://doi.org/10.1109/TCSVT.2023.3310522]

-

Zhang, J., Yao, Y. and Quan, L., “Learning signed distance field for multi-view surface reconstruction,” Proceedings Of The IEEE/CVF International Conference On Computer Vision. pp.6525-6534, 2021.

[https://doi.org/10.1109/ICCV48922.2021.00646]

-

W. E. Lorensen and H. E. Cline, Marching cubes: a high resolu-tion 3D surface construction algorithm, SIGGRAPH Comput.Graph.21, no. 4, pp.163–169, 1987.

[https://doi.org/10.1145/37402.37422]

-

C. Montani, R. Scateni, and R. Scopigno, “A modified look-uptable for implicit disambiguation of marching cubes,” The Vis.Comput., no. 6, pp.353–355, 1994.

[https://doi.org/10.1007/BF01900830]

- P. Bourke, Polygonising a scalar field (marching cubes), 2016. Dostopno na: : http://paulbourke.net/geometry/polyg, .

-

Thomas Müller, Alex Evans, Christoph Schied, and Alexander Keller, “Instant Neural Graphics Primitives with a Multiresolution Hash Encoding,” ACM Trans. Graph. 41, 4, Article 102, 2022.

[https://doi.org/10.1145/3528223.3530127]

-

Bernhard Kerbl, Georgios Kopanas, Thomas Leimkuhler and George Drettakis, “3d gaussian splatting for real-time radiance field rendering,” ACM Transactions on Graphics(ToG), 42(4):1–14, 2023.

[https://doi.org/10.1145/3592433]

- 2018년 2월 : 한국항공대학교 항공전자정보공학부 학사

- 2020년 2월 : 한국항공대학교 항공전자정보공학부 석사

- 2020년 3월 ~ 현재 : 한국전자통신연구원 연구원

- ORCID : https://orcid.org/0000-0002-8254-2481

- 주관심분야 : 2D/3D 비디오 부호화, 영상 처리, 컴퓨터 비전, 인공지능

- 2002년 ~ 2006년 : ATSC T3/S2 ACAP 데이터방송 표준 에디터

- 2008년 ~ 2013년 : MPEG FTV AhG 그룹 EE 코디네이터

- 2011년 ~ 2012년 : MIT RLE ATSP 그룹 방문 연구원

- 2014년 : 고려대학교 컴퓨터학 박사

- 2022년 ~ 현재 : MPEG INVR AhG 그룹 Co-chair

- 현재 : 한국전자통신연구원 초실감메타버스연구소 표준전문위원/책임연구원

- ORCID : https://orcid.org/0000-0003-4355-599X

- 주관심분야 : 2D/3D 비디오 부호화, 영상 처리, 컴퓨터 비전, 인공지능

- 1990년 2월 : 경북대학교 전자공학과 학사

- 1992년 2월 : KAIST 전기 및 전자공학과 석사

- 2005년 2월 : KAIST 전기 및 전자공학과 박사

- 1992년 3월 ~ 2007년 2월 : 한국전자통신연구원(ETRI) 선임연구원/팀장

- 2001년 9월 ~ 2002년 7월 : Columbia University 연구원

- 2015년 12월 ~ 2016년 1월 : UC San Diego, Visiting Scholar

- 2007년 9월 ~ 현재 : 한국항공대학교 항공전자정보공학부 교수

- ORCID : http://orcid.org/0000-0003-3686-4786

- 주관심분야 : 비디오 부호화 표준, 비디오 신호처리, Immersive Video, Deep Learning