2D CNN 기반 XR 사용자 뇌파 인증 및 BCI Illiteracy 자동 분류 프로토콜 개발

Correspondence to: ‡문성철(Sungchul Mun) E-mail: : sungchul.mun@jj.ac.kr Tel: +82-63-220-2398

Copyright © 2023 Korean Institute of Broadcast and Media Engineers. All rights reserved.

“This is an Open-Access article distributed under the terms of the Creative Commons BY-NC-ND (http://creativecommons.org/licenses/by-nc-nd/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited and not altered.”

초록

본 연구는 XR 환경에서 사용자 인증과 BCI illiteracy 현상을 동시에 판별하는 프로토콜을 제안하였다. 주기적인 시각 자극과 목표 자극 이미지 통합을 통해 실험참가자의 선별적 집중을 유도하였으며, 이를 통해 ERP는 사용자 인증에, SSVEP는 BCI illiteracy 판별에 활용되었다. 실험 결과, 10 Hz grow/shrink 알파벳 이미지 자극이 가장 효과적인 자극 방법으로 나타났으며, 사용자 분류를 99%의 정확도로 달성하였다. 따라서, 제안된 프로토콜은 XR 환경에서의 사용자 인증 및 BCI illiteracy 판별 시스템 구축에 활용될 수 있다. 이러한 본 연구의 결과는 XR 환경에서의 Universal 뉴럴 인터페이스 구축에 중요한 토대가 될 것으로 기대된다.

Abstract

This study proposed a protocol for simultaneous user authentication and Brain-Computer Interface (BCI) illiteracy detection in eXtended Reality (XR) environments. Selective participant focus was induced by using periodic visual stimuli incorporating target stimulus images. Event-Related Potential (ERP) was utilized for user authentication, while Steady-State Evoked Potential (SSVEP) was utilized to identify BCI illiteracy. Experimental results revealed that the 10 Hz grow/shrink alphabet image stimulus was the most effective, achieving a 99% accuracy in user classification. Therefore, the proposed protocol can be applied to establish a user authentication and BCI illiteracy detection system in XR environments. These findings are expected to serve as a significant foundation for the development of Universal Neural Interface in XR environments.

Keywords:

Neural Interface, Biometric Authentication, Convolutional Neural Network, Event-Related Potential, Steady-State Visually Evoked PotentialⅠ. 서 론

Brain-Computer Interface (BCI)는 뇌의 활동으로 변화하는 뇌파 데이터를 측정하고 해석하여 컴퓨터나 기계 장치와 상호 작용하는 시스템이다[1]. 이 시스템은 주로 비침습적인 방법으로 뇌파를 측정하여 사용자의 의도를 파악하고, 이를 기반으로 기기를 제어한다. 뇌파는 신체 움직임이 수반되는 생체신호가 아니기 때문에, 척수 손상과 같이 행동에 제한이 있는 사람들에게 보행이나 의사소통 보조 기기의 제어 수단으로 주로 사용되어왔다[2]. 그러나, 최근 휴먼데이터 기반 인공지능 기술의 발전으로, 중증장애인의 대안 소통 수단을 넘어 휴먼 인터페이스 편의성 향상을 위한 수단으로 확장되고 있다. 특히 일상생활에서 사용될 수 있는 BCI 기술은 미래 인터페이스와 사용자 경험을 높이는 데 기여하고 있다.

BCI 기술은 eXtended Reality (XR)의 주요 요소인 실재감 및 몰입감을 유도할 수 있는 미래 인터페이스로 주목받고 있다. Putze[3]은 증강현실(AR: Augmented Reality) 환경에서 Steady-State Evoked Potential (SSVEP)를 활용한 BCI 기반 스마트 홈 컨트롤 시스템을 개발하였으며, Dasdemir[4]은 메타버스 환경에서 BCI 기술을 활용하여 문을 열거나, 특정 위치로 이동하는 기술을 구현하였다. 또한 XR 시장의 대표주자인 글로벌 IT 기업 Meta의 Reality Labs 연구그룹은 웨어러블 BCI 및 미래 뉴럴 인터페이스 선행기술의 발전을 주도하고 있다. 이러한 연구 흐름은 BCI와 XR의 결합이 미래 디지털 인터페이스의 중심축이 될 가능성을 보여주며, 사용자 경험의 가치가 제고된 네츄럴한 미래 상호작용의 컨셉을 나타내고 있다.

이러한 미래 지향적인 BCI 기술이 XR 산업 분야에서 지속 가능한 응용 기술로 자리 잡기 위해서는 사용자 인증 시스템 개발과 함께 BCI illiteracy 문제를 해결해야 한다. 현재 XR 환경에서의 보안 시스템으로 Personal Identification Number (PIN)나 홍채, 지문, 얼굴과 같은 생체 인식 시스템이 주로 사용되고 있다[5]. 그러나, 이러한 시스템들은 보안성이 취약하거나 추가적인 측정 센서나 장치가 필요한 경우가 많아, XR 환경에서의 효율성 및 사용자 편의성을 저해할 수 있다. 이에 반해, 뇌파는 개인마다 고유한 패턴을 지니는 매우 개인화된 바이오 마커이며, 위조하거나 변조하기가 어려운 특성이 있다[6]. 이러한 특징으로 인해 뇌파는 미래 보안 인증 수단으로 주목받고 있으며[7-10], 미래 XR 플랫폼과 접목되어 해킹에 대한 취약성을 획기적으로 향상시킬 수 있는 수단으로 각광받고 있다[11].

BCI illiteracy 현상은 개인 뇌피질의 폴딩 구조의 차이, 폴딩 구조에 복합적으로 매핑되는 뇌 기능 및 개인의 인지 기능의 차이로, 특정 BCI 프로토콜을 사용하지 못하는 현상으로 널리 알려져 있다. 약 15~30%의 사람이 BCI illiteracy에 해당하며, 이들은 특정 뇌파 변화에 기반한 BCI 제어 시 오탐이 발생할 가능성이 높아, BCI 기술을 활용하는데 제약이 존재한다[12]. 뇌파 기반 사용자 인증 시스템은 특정 자극에 대한 뇌파의 반응 여부를 사전에 확인함으로써 BCI illiteracy를 판별할 수 있다. 이러한 조기 BCI illiteracy 판별 시스템은 BCI 프로토콜 사용 전에 BCI illiteracy에 속하는 사람들을 구분하고, 이들에게 BCI 이외의 대안 인터페이스를 효율적으로 제공할 수 있는 장점이 있다.

외부 자극에 대한 뇌파의 반응은 뇌파 기반 사용자 인증 시스템에 활용될 수 있다. Event-Related Potential (ERP)는 특정 정보를 내포하고 있는 자극에 의해 변화하는 뇌의 전기적 활동을 의미한다[13]. 자극에 대한 정보 처리 과정의 각 단계들을 반영하는 시간과 관련된 뇌파의 특정 구간의 최대 진폭(Peak amplitude) 값들로 정의된다. ERP의 P300은 자극의 특성이나 실험참가자의 상태에 따라서 자극 제시 후 250-600 ms 사이에 나타나는 최대 진폭 값을 의미한다[14]. 실험참가자가 사전에 인지하고 있는 목표 자극이 제시되었을 때 발생하는 P300의 진폭이 표준 자극의 P300보다 유의하게 크다고 보고되고 있다[15]. 만약 XR 사용자가 특정 목표 자극을 사전에 인지하고 있다면, 목표 자극과 표준 자극에 대한 P300 차이를 사용자 인증에 활용할 수 있다. SSVEP는 ERP와 다르게 실험참가자의 인지 과정 없이 발생하는 뇌파 반응이다. SSVEP는 일정한 주기로 반복되는 시각 자극을 응시하였을 때 뇌의 시각피질에서 동일한 주파수 성분의 뇌파가 발현되는 특성을 의미한다[16]. SSVEP 기반 BCI 기술은 상대적으로 사용자 훈련 시간이 짧고 높은 정확도의 제어가 가능하므로, 많은 BCI 프로토콜에서 활용되고 있다[17]. 따라서 SSVEP 유발 여부는 BCI 기술 활용에 중요한 요소일 뿐만 아니라 BCI illiteracy를 판별하는데 효율적 요소이다.

본 연구는 XR 플랫폼의 해킹에 대한 취약성을 보완하기 위해 XR 환경에서 ERP와 SSVEP를 동시에 유발할 수 있는 새로운 시각 자극 패러다임을 제시하고, 사용자 인증 및 BCI illiteracy 판별 시스템으로의 활용 가능성을 확인하였다. BCI 기술의 사용 가능 여부를 확인할 수 있는 서로 다른 유형의 뇌파 신호인 ERP와 SSVEP의 동시 유발은 추가적인 뇌파 수집 없이 사용자 인증 단계에서 BCI illiteracy를 판별할 수 있는 장점이 있다[18-21]. 시각 자극 패러다임의 효과성과 활용성을 테스트하기 위해서 시각 자극 중 목표 자극과 표준 자극의 P300 값을 비교하였다. 시각 자극에 반응한 뇌파 데이터를 활용하여, 목표 자극과 표준 자극 분류 모델과 2D Convolutional Neural Network (2D-CNN) 기반 사용자 분류 모델을 개발하였다. 또한 SSVEP 유발 여부를 활용하여 BCI illiteracy 판별 시스템을 구현하였다. 본 연구에서 수행한 XR 시각 자극 제시 프로토콜 효과성 테스트는 XR 사용자 인증 및 BCI illiteracy 현상을 동시에 분류하는 프로토콜을 Universal 뉴럴 인터페이스에 적용하기 위한 사전 실험 관점에서 진행되었다.

Ⅱ. XR 뇌파 보안 인증 프로토콜 실험

1. 실험참가자

20대 4명(남자 3명, 여자 1명, 평균 나이: 22.5±1.5)이 본 실험에 참여하였다. 실험참가자는 0.8 이상의 교정시력과 사시, 난시, 외사위 등의 징후가 없는 자로 선정하였다.

2. 실험환경

실험참가자는 혼합현실(MR, Mixed Reality) 디바이스 HoloLens2(Microsoft Inc., Redmond, WA)를 착용하고, 본 연구 프로토콜을 수행하였다. SSVEP와 ERP 신호를 유발하기 위한 시각 자극은 HoloLens2를 통해 실험참가자에게 제시되었다. 실험참가자는 HoloLens2의 화면 중앙에 제시되는 시각 자극 이미지에 주의 집중하였다.

시각 자극 이미지는 총 50개의 조류 이미지가 5 Hz 속도로 반복적으로 깜빡이는 시각 자극으로 구성되었다(그림 1). 50개 중 2개의 조류 이미지를 목표 자극으로 설정하였고, 나머지 48개의 조류 이미지를 표준 자극으로 설정하였다. 흰색 배경에 삽입된 1개의 조류 이미지는 100 ms 동안 제시되었고, 이어서 검은색 배경의 빈 화면이 100 ms 동안 제시되었다. 1 trial은 10개의 이미지(목표 자극 비율 4%)로 구성되었다(2초). 1 블록은 5 trials로 구성되었으며, trial 간 간격은 2초로 설정되었다. 분석을 위한 충분한 데이터 확보를 위해, 300 블록의 실험을 진행하였다. 300 블록 중 49 블록을 무작위로 선택하여 분석에 활용하였다.

실험참가자의 실험 수행 집중도를 최대화하기 위해, 실험참가자는 총 24 trials(trial 간 간격 포함 약 5분 소요)의 프로토콜을 빛이 차단된 환경에서 수행하였다. 목표 자극에 대한 실험참가자의 인식을 확인하기 위해, 목표 자극이 제시될 때마다 제공된 키보드의 스페이스 바를 눌러 목표 자극에 대한 인식을 기록하였다.

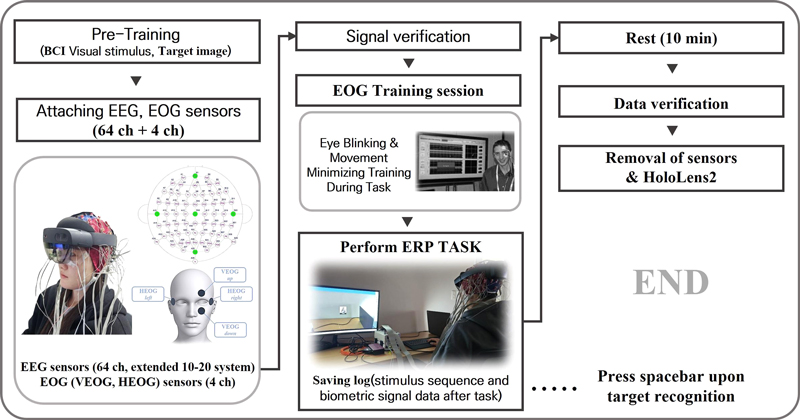

3. 실험절차

각 실험참가자는 조류 이미지가 5 Hz의 속도로 변화하는 일련의 시각 자극에서 목표 자극을 찾는 과제(Task)를 수행하였다. XR 환경에서 목표 자극에 대한 사전 트레이닝을 5분 동안 진행한 후, Biosemi ActiveTwo(Biosemi., Amsterdam, Netherlands) electroencephalogram (EEG) 센서(64 ch)와 electrooculogram (EOG) 센서(4 ch)를 부착하였다(임피던스 < 3 kΩ). 실험 전 Actiview recording software(Biosemi., Amsterdam, Netherlands)를 통해 EEG 및 EOG 신호의 안정성을 사전에 확인하였다. 또한 실험 전, 동공 움직임으로 인한 노이즈를 최소화하기 위한 훈련을 진행하였다. 과제 수행이 완료되고 데이터 확인 후, 센서와 디바이스를 제거하였다(그림 2).

4. 데이터 수집

Biosemi ActiveTwo 시스템(AD-box, USB2 Receiver)을 통해 EEG(64 ch)과 EOG(4 ch) 데이터를 512 Hz로 수집하였다.

5. 데이터 분석

데이터 분석은 MATLAB version R2023(MathWorks Inc., Natick, MA, US)을 활용하였다. ERP 분석을 위해 다음과 같이 전처리 과정을 수행하였다. 수집된 EEG 데이터는 1~12 Hz 대역의 4차 버터워스 밴드 패스 필터(Butterworth band-pass filter)를 적용하였으며, 각 채널의 첨도가 10 이상일 때, 구면 선형보간법으로 데이터를 보정하였다. 목표 자극과 표준 자극 분리를 위해 시각 자극 전 200 ms부터 시각 자극 후 1000 ms까지 분절화(Epoching) 하였다. 각 분절은 시각 자극 전 200 ms 구간의 평균 진폭값을 이용하여 각 분절의 기저선 보정(Baseline correction)을 하였다. 신뢰도 있는 분석을 위해 EOG 데이터를 통해 노이즈 요소인 눈 깜박임이 포함된 trial을 제거하였다. 모든 trial의 평균값을 구한 후 base-to-peak 방식으로 두정엽 및 후두엽(P1, P2, P3, P4, Pz, O1, O2, Oz) 지점의 P300 성분을 수집하였다. 최종적으로 목표 자극과 표준 자극 간의 P300의 진폭을 대응표본 t 검정(Paired t-test)을 이용하여 비교하였다.

SSVEP 분석을 위해 1~35 Hz 대역의 4차 버터워스 밴드 패스 필터를 적용하였고, 2초 길이로 분할하였다. 분할된 데이터는 Fast Fourier Transform (FFT)을 수행하여 Power density spectrum을 추정하였다.

6. 5 Hz flicker 시각 자극 실험 결과

조류 이미지 기반의 5 Hz 플리커 프로토콜 수행 결과 4명의 실험참가자의 목표 자극과 표준 자극 데이터의 grand average에서 P300 성분을 추출하였다. 대응표본 t 검정 수행 결과, P2, P4, O1 지점에서 P300 값의 유의한 차이가 관측되었다(그림 3). ERP 신호와 더불어 5 Hz 주파수로 시각 자극을 제공하였으나, 유효한 패턴의 SSVEP는 검출되지 않았다. 이는, 두 가지 관점으로 해석된다. 실험참가자가 BCI illiteracy인 것으로 해석되거나 혹은 기존 시각 자극이 SSVEP를 유발하는데 최적의 프로토콜이 아닌 것으로 해석된다. 본 실험은 흰색 배경과 검은색 배경의 화면이 반복되는 시각 자극을 이용하였지만, 조류 이미지가 명암 대비 플리커 섬광효과를 저감하여 1차 시각피질에서의 SSVEP 신호 유발이 효과적으로 되지 않은 것으로 추정된다.

(a) Topographical maps of 5 Hz flicker protocol targets and non-target stimuli based on bird images. (b) EEG time-series data of target and non-target stimuli at the P2, (c) P4, and (d) O1 area. (e) P300 amplitude data of target and non-target stimuli for 4 experimental participants (n=4, mean±1S.D)

따라서 본 연구에서는 조류 이미지를 활용한 시각 자극이 SSVEP를 유발하는데 적절한지 판단하기 위해서 SSVEP와 ERP를 동시에 효율적으로 유발할 수 있는 수정 프로토콜을 추가로 제안하고 그 효과를 테스트하였다.

Ⅲ. ERP와 SSVEP 패턴을 동시에 유발하기 위한 grow/shrink 시각 자극 프로토콜

1. grow/shrink 시각 자극 실험환경

1차 실험의 문제점을 해결하기 위해, 일련의 알파벳과 알파벳을 감싸고 있는 (사각형) 배경의 크기가 일정한 주파수로 변화하는 프로토콜을 설계하였다(그림 4). 전체 배경 화면과 알파벳은 검은색, 사각형의 색은 흰색으로 설정하였다. SSVEP를 효과적으로 유발하기 위해, 10 Hz의 속도로 2개의 다른 크기의 사각형(전체 배경 화면 대비 80% & 25%)이 반복적으로 나타나도록 설계하였다. 알파벳은 500 ms마다 새로운 알파벳으로 업데이트되었다. 5명의 실험참가자(남자 4명, 여자 1명, 평균 나이: 22.2±1.8)를 대상으로 해당 프로토콜의 효과성을 테스트하였다. 실험참가자는 화면에 2 Hz의 속도로 디스플레이 되는 알파벳 중 목표 알파벳에 선별적으로 집중하는 과제를 수행하였다. 세부 자극 제시 프로토콜은 다음과 같다. 1 trial은 100개의 이미지(목표 자극 비율 4%)로 구성되며, 총 50초가 소요되었다. 8 trials을 1 블록으로 구성했으며, trial 간 간격은 2초, 블록 간 간격은 10초로 설정하였다. 총 26개의 알파벳이 무작위로 추출되어 제시되었으며, 목표 알파벳은 각 블록이 시작되기 전에 실험참가자에게 사전 공지되었다.

2. grow/shrink 시각 자극 실험 결과

실험참가자 5명을 대상으로 진행한 알파벳 이미지 기반의 10 Hz grow/shrink 시각 자극 프로토콜 수행 결과, O1, O2, Oz에서 목표 자극의 P300 진폭이 표준 자극의 P300 진폭에 비해 유의하게 컸다(대응 표본 t 검정, p < 0.01; 그림 5). 또한, 두정엽(P1, P2, P3, P4, Oz) 및 후두엽(O1, O2, Oz) 부근에서 10 Hz grow/shrink 시각 자극에 반응한 SSVEP 신호가 유발되었다(그림 6).

(a) Topographical maps of 10 Hz growth/shrink protocol targets and non-target stimuli based on alphabetical images. (b) EEG time-series data of target and non-target stimuli at the (b) O1, (c) O2, and (d) Oz area. (e) P300 amplitude data of target and non-target stimuli for 5 experimental participants (n=5, mean±1S.D)

Ⅳ. XR 사용자 인증 시스템 적용 가능성 평가

1. 목표-표준 자극 뇌파 분류 모델

ERP를 유발하기 위한 알파벳 이미지 시각 자극 프로토콜이 XR 사용자 인증 시스템에 적용될 수 있는 가능성을 확인하기 위해 목표 자극과 표준 자극을 분류할 수 있는 2D-CNN 모델을 구현하였다. 모델의 입력은 전체 실험참가자의 목표 자극과 표준 자극의 뇌파로 구성되었다. 총 325개의 목표 자극 분절 수에 맞춰서 표준 자극 분절 중 325개를 무작위 추출하였다. 2D-CNN 모델에 맞는 입력 신호를 구성하기 위해, 64개의 EEG 채널의 분절화된 뇌파 신호(615개 데이터 포인트)를 2차원으로 결합하였다(615 x 64). 따라서 325 x 615 x 64 크기의 목표 자극 신호와 표준 자극 신호를 구성하였다. 모델은 10-fold 교차 검증을 통해 평가되었다. 각 fold마다 총 325개의 분절화된 신호 중 90%가 train 데이터 셋으로 10%가 validation 데이터 셋으로 할당되었으며, 할당된 후 목표 자극 신호 데이터(1 x 615 x 64)와 표준 자극 신호 데이터의 평균(1 x 615 x 64)을 계산하였다. 목표 자극 신호 데이터와 표준 자극 신호 데이터를 결합한 데이터(2 x 615 x 64)를 입력 데이터로 사용하였다.

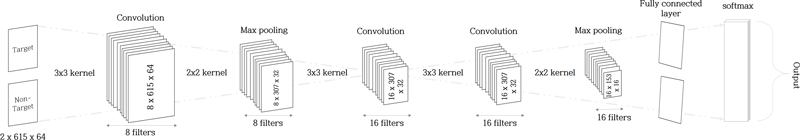

2D-CNN 모델의 구조는 3개의 컨벌루션 층과 2개의 최댓값 풀링 층(Max pooling layer), 1개의 완전연결층으로 구성하였다. 활성함수는 Rectified Linear Unit (ReLU)을 이용하였으며, 컨벌루션 층 필터 크기는 3 x 3, 풀링 층 필터 크기는 2 x 2, 스트라이드는 2로 설정하였다(그림 7). 학습 환경은 배치 사이즈는 16, 최적화(Optimizer)는 Stochastic gradient descent with momentum (SGDM), Learning rate는 1e-4로 설정하였다. Epoch는 최대 20으로 설정하였지만, 평균적으로 10 epoch 이내에 수렴하였다. 분류 결과, 100%의 목표 자극과 표준 자극 뇌파 데이터의 분류 정확도가 도출되었다.

2. 사용자 분류 모델

사용자 분류는 사용자 인증 시스템의 중요한 요소이다. 알파벳 실험 자극에 대한 뇌파 데이터로 사용자 분류 가능성을 확인하기 위해서 2D-CNN 모델을 활용한 뇌파 기반 사용자 분류 모델을 구현하였다. 5명의 실험참가자 데이터 중 목표 자극의 최소 분절화 데이터 수는 51개였다. 모든 실험참가자가 같은 양의 분절화된 데이터를 보유하기 위해 목표 자극 분절화 데이터와 표준 자극 분절화 데이터를 각각 51개씩 무작위로 추출하였다. 충분하지 않은 데이터의 양을 고려하여 부트스트랩 샘플링으로 모델을 평가하였다. 51개 중 무작위로 추출한 25개의 데이터를 train 데이터로 할당하였고, 나머지 26개의 데이터를 test 데이터로 할당하였다. 목표-표준 자극 뇌파 분류 모델의 입력 데이터와 같이 train 데이터는 25 x 615 x 64로 결합하였고, test 데이터는 26 x 615 x 64 형태로 결합하였다. 데이터가 train, test 데이터로 할당된 후, 평균을 구하였으며, 목표 자극 데이터와 표준 자극 데이터를 결합하였다(2 x 615 x 64). 그리고 모든 실험참가자 데이터를 결합하였다(5 x 2 x 615 x 64). 이 과정을 1000번 반복하여 모델을 평가하였다.

2D-CNN 모델의 구조는 5개의 컨벌루션 층과 2개의 최댓값 풀링 층, 1개의 완전연결층으로 구성하였다. 활성함수는 ReLU를 이용하였으며, 컨벌루션 층 필터 크기는 3 x 3, 풀링 층 필터 크기는 2 x 2, 스트라이드는 2로 설정하였다(그림 8). 학습 환경은 배치 사이즈 16, 최적화는 ADAM, Learning rate는 1e-4, Epoch는 최대 50으로 설정하였다. 1000번의 수행 결과, 분류 정확도는 0.99±0.014, AUC는 0.90±0.12로 높은 분류 정확도를 도출하였다(그림 9).

Ⅴ. 고찰 및 결론

본 연구는 XR 환경에서 BCI illiteracy 현상을 동시에 판별할 수 있는 사용자 인증 프로토콜을 제안하였다. 주기적인 시각 자극에 목표 자극 이미지를 삽입하여 실험참가자가 선별적으로 집중하도록 설계하였다. 선별적 집중에 따른 ERP는 사용자 인증에, SSVEP는 BCI illiteracy 판별에 사용되었다. 5 Hz 플리커 자극 기반 조류 이미지를 활용한 시각 자극 프로토콜은 표준 자극 P300에 비해 유의하게 큰 목표 자극 P300 진폭을 유발하였으나, SSVEP를 유발하지 못했다. 반면, 10 Hz grow/shrink 알파벳 이미지 자극에서는 ERP 및 SSVEP 모두 효과적으로 유발되었다(표 1, 그림 5 & 6). 따라서, 5 Hz 플리커의 SSVEP 유발 실패는 BCI illiteracy가 아닌 조류 이미지의 섬광효과 미흡 때문으로 판명될 수 있다. grow/shrink 자극은 주기적인 이미지 크기 변화로 1차 시각피질의 네츄럴한 뇌반응을 유도하기 때문에, 플리커 자극보다 배경 색에 민감하지 않고[22], 색이 대비되는 주기적 자극에 비해 시각적 편안함을 제공한다[23]. 또한 이러한 자극 타입이 SSVEP BCI에서도 더 높은 분류 정확도를 보여주고 있다[22]. 따라서, XR 환경에서의 SSVEP 유발은 grow/shrink 시각 자극이 플리커 자극보다 더욱 효과적이라고 결론지을 수 있다.

ERP 유발을 목적으로 하는 알파벳 이미지 시각 자극의 XR 사용자 인증 시스템 적용 가능성을 검토하기 위해, 목표 자극 뇌파 데이터와 표준 자극 뇌파 데이터 분류 모델을 구현하였다. 분류 결과, 목표 자극과 표준 자극 뇌파 사이에 100% 정확도의 분류 성능을 도출하였다. 이 결과는 목표 자극으로 유발된 뇌파는 표준 자극 뇌파와 다른 특성을 가진다는 것을 시사하며, 목표 자극으로 유발된 ERP를 사용자 인증 시스템에 적용할 수 있다는 가능성을 보여준다. 목표 자극에 대한 정보가 없는 비인가 XR 사용자는 인가 사용자와 같은 목표 자극 반응을 나타낼 수 없다. 이러한 XR 비인가 사용자와 인가 사용자의 차이는 사용자 인증 시스템에 주요한 요소가 될 수 있을 것으로 기대된다.

사용자(5명) 분류 모델에서 약 99%의 정확도와 90% 이상의 AUC를 도출하였다. 본 연구와 유사한 방식의 인증 시스템을 개발한 선행 연구에서는 본인 및 지인의 사진 또는 단순 그림을 시각 자극으로 활용하였다[24-26]. 해당 시각 자극을 활용한 ERP 기반 사용자 분류 모델은 높은 분류 정확도(>95%)를 보였다. 그러나 이러한 연구들은 상대적으로 소요 시간이 긴 프로토콜(>10min)을 사용하였으며, 일관된 목표 자극만을 활용하였다. 또한, 선행 연구들은 XR 환경에서 수행되지 않았으며, 일반 LCD 모니터를 사용하여 시각 자극을 제시하였다. 반면, 본 연구는 XR 환경에서 수행되었으며, 선행 연구에 비해 짧은 프로토콜 시간(<5min)을 필요로 했다. 짧은 시간의 사용자 인증 시스템은 사용자 경험을 최적화하는데 기여한다. 또한 데일리(Daily) 보안 업데이트가 가능한 알파벳을 목표 자극으로 채택함으로써, 보안성을 상대적으로 강화할 수 있다. 그러므로 본 연구의 시각 자극 패러다임은 XR 환경에서 효율적인 사용자 인증 시스템 구축에 중요한 기여를 할 수 있을 것으로 기대된다.

모든 실험참가자가 같은 시각 자극 프로토콜을 활용한 과제를 수행했다는 것을 고려하면, 높은 사용자 분류 모델 정확도는 뇌파의 개인적 고유성을 강조한다. 만약, XR 비인가 사용자가 목표 자극에 대한 정보를 입수하더라도 사용자 뇌파 특성을 위조할 수 없어서 사용자 인증에 실패할 수 있다. 이러한 개인적 고유성이 강한 뇌파의 특성은 위조에 취약한 기존 인증 시스템의 한계점을 극복할 수 있는 중요한 요소이다[6]. 다만, 본 실험에서는 실험참가자 수가 많지 않았고(n=5), 사용자 뇌파의 시간 변동성을 고려하지 않았다. 많은 사용자를 분류하려면 더 복잡한 모델이 요구된다. 복잡한 모델의 많은 연산량은 사용자 인증에 걸리는 시간을 증가시키는 단점이 존재한다. 또한 사용자가 가지는 뇌파의 시간 변동성이 사용자 인증의 실패를 가져올 수 있다. 예를 들면, 2주 후에 수집한 사용자 뇌파가 현재 수집된 사용자 뇌파 기반의 사용자 분류 모델에 적합하지 않을 수 있다. 이러한 한계점을 극복할 수 있는 추후 연구가 필요하다.

별도의 추가 세션 없이 목표 자극을 포함한 주기적 시각 자극이 제공될 때, 동시에 제공된 grow/shrink 시각 자극은 모든 실험참가자의 SSVEP를 유발하였다. 즉, 하나의 시각 자극 프로토콜이 XR 환경에서 ERP와 SSVEP를 함께 유발하였다. 동시에 유발된 ERP와 SSVEP는 하나의 세션에서 각각 사용자 인증과 BCI illiteracy 판별을 동시에 진행할 수 있음을 시사한다. 만약 본 프로토콜을 통해 BCI illiteracy로 판별된다면, 뇌파 이외의 생체신호인 EOG나 electromyogram (EMG)를 활용한 사용자 인증 시스템과 speller를 대안으로 제시해야 한다[27, 28]. 따라서, BCI illiteracy 판별 시스템과 대안 인터페이스 제공 시스템이 연결된 파이프라인을 구축하는 것이 필요하다. 향후 관련 연구 수행을 통해, 사용자 특성에 기반한 XR 유니버셜 뉴럴 인터페이스 연구를 진행할 예정이다.

본 연구는 XR 유니버셜 뉴럴 인터페이스 구축을 위한 사전 실험 관점에서 수행되어 실험참가자 수의 한계가 있으나, 뇌파 기반 사용자 인증 관련 선행연구에서도 적은 수의 훈련용/테스트용 데이터를 활용하여 제안한 시스템을 검증한 사례가 존재한다. Palaniappan[9]은 5명의 실험참가자를 대상으로 제안한 2단계 뇌파 인증 방법의 성능을 평가하였으며, Zeynali[10]은 7명의 실험참가자를 대상으로 단일 채널 뇌파 인증 시스템의 성능 비교를 통해 최적의 머신러닝 분류 모델을 도출하였다. 또한, SSVEP 데이터 분석 시 기본 주파수와 배수에 해당하는 하모닉 주파수 특성을 추가적으로 분석하여, 개인 맞춤형 머신러닝 알고리즘을 개발하는 것이 필요하다. 개인마다 상이하게 도출되는 주파수 패턴의 최적화는 인터페이스의 오탐을 저감하고 뇌파 패턴의 연결성을 강화하여 알고리즘의 성능을 개선할 수 있다. 마지막으로, 본 실험에서는 뇌파 신호 수집을 위해 Cap 형태의 EEG 측정 센서를 이용하였다. 향후 XR 환경의 효용성과 사용자 편의성 향상을 위해 전자피부와 뉴로모픽 융합에 대한 연구를 수행할 예정이다. 전자피부는 타투 형태로 기존 상용 센서에 비해 피부 트러블이 거의 없고, 가볍고, 장시간 부착이 가능하다. 따라서, 사용자의 불편함을 최소화하여 번거로운 센서 부착 없이 XR 미래 인터페이스를 개발할 수 있는 장점을 가지고 있다. 이러한 전자피부-뉴로모픽 컴퓨팅 기술의 융합은 XR 환경에서 BCI 기술을 이용한 미래 인터페이스의 가능성을 더욱 강조하며, 이에 따른 BCI 연구의 중요성을 더욱 부각시킬 것으로 기대한다.

Acknowledgments

이 논문의 연구 결과 중 일부는 “한국방송·미디어공학회 2023년 하계학술대회”에서 발표한 바 있음.

This work was partly supported by an Institute of Information & Communications Technology Planning & Evaluation(IITP) grant funded by the Korean government(MSIT) (No. 2023-0-00432, Development of Non-invasive Integrated BCI SW Platform to Control Home Appliance and External Devices by User’s Thought via AR/VR Interface, 30%), National Research Foundation of Korea(NRF) grant funded by the Korean government(MSIT) (No. NRF-2022R1C1C1010458, Cross Bio-sensing System for the Future XR Interface, 30%), and Basic Science Research Program through the National Research Foundation of Korea(NRF) funded by the Ministry of Education (No. RS-2023-00247958, Development of XR Cross-modal Neural Interface with Adaptive Artificial Intelligence, 40%).

References

-

S. N. Abdulkader, A. Atia, and M. S. M. Mostafa, "Brain computer interfacing: Applications and challenges," Egyptian Informatics Journal, Vol.16, No.2, pp.213-230, July 2015.

[https://doi.org/10.1016/j.eij.2015.06.002]

-

R. Na, C. Hu, Y. Sun, S. Wang, S. Zhang, M. Han, W. Yin, J. Zhang, X. Chen, and D. Zheng, "An embedded lightweight SSVEP-BCI electric wheelchair with hybrid stimulator," Digital Signal Processing, Vol.116, pp.103101, September 2021.

[https://doi.org/10.1016/j.dsp.2021.103101]

-

F. Putze, D. Weiß, L. M. Vortmann, and T. Schultz, "Augmented reality interface for smart home control using SSVEP-BCI and eye gaze," 2019 IEEE International Conference on Systems, Man and Cybernetics (SMC). IEEE, Bari, Italy, pp.2812-2817, October 2019.

[https://doi.org/10.1109/SMC.2019.8914390]

-

Y. Dasdemir, "A brain-computer interface with gamification in the Metaverse," Dicle Üniversitesi Mühendislik Fakültesi Mühendislik Dergisi, Vol.13, No.4, pp.645-652, December 2022.

[https://doi.org/10.24012/dumf.1134296]

-

Y. Huang, Y. J. Li, and Z. Cai, “Security and privacy in metaverse: A comprehensive survey,” Big Data Mining and Analytics, Vol.6, No.2, pp.234-247, January 2023.

[https://doi.org/10.26599/BDMA.2022.9020047]

-

Z. B, Hu, V. Buriachok, M. TajDini, and V. Sokolov, “Authentication System by Human Brainwaves Using Machine Learning and Artificial Intelligence,” In: Advances in Computer Science for Engineering and Education IV. Springer International Publishing, Vol.83, pp.374-388, July 2021.

[https://doi.org/10.1007/978-3-030-80472-5_31]

-

P. Arias-Cabarcos, M. Fallahi, T. Habrich, K. Schulze, C. Becker and T. Strufe, “Performance and Usability Evaluation of Brainwave Authentication Techniques with Consumer Devices,” ACM Transactions on Privacy and Security, Vol.26, No.3, pp.1-36, March 2023.

[https://doi.org/10.1145/3579356]

-

N. Rathi, R. Singla, and S. Tiwari. “A novel approach for designing authentication system using a picture based P300 speller,” Cognitive Neurodynamics, pp.1-20, January 2021.

[https://doi.org/10.1007/s11571-021-09664-3]

-

R. Palaniappan, "Two-stage biometric authentication method using thought activity brain waves," International journal of neural systems, Vol.18, No.01, pp.59-66, 2008, doi: https://www.worldscientific.com/doi/abs/10.1142/s0129065708001373

[https://doi.org/10.1142/S0129065708001373]

-

M. Zeynali, and H. Seyedarabi, "EEG-based single-channel authentication systems with optimum electrode placement for different mental activities," Biomedical Journal, Vol.42, No.4, pp.261-267, August 2019.

[https://doi.org/10.1016/j.bj.2019.03.005]

-

S. Saulynas, and R. Kuber, "Towards brain-computer interface (bci) and gestural-based authentication for individuals who are blind," Proceedings of the 19th International ACM SIGACCESS Conference on Computers and Accessibility, pp.403-404, October 2017.

[https://doi.org/10.1145/3132525.3134785]

-

S. Becker, K. Dhindsa, L. Mousapour, and Y. A. Dabagh, "BCI Illiteracy: It’s Us, Not Them. Optimizing BCIs for Individual Brains," 10th International Winter Conference on Brain-Computer Interface (BCI) IEEE, Gangwon-do, Korea, Republic, pp.1-3, March 2022.

[https://doi.org/10.1109/BCI53720.2022.9735007]

-

D. Friedman, Y. M. Cycowicz, and H. Gaeta, “The novelty P3: an event-related brain potential (ERP) sign of the brain's evaluation of novelty,” Neuroscience & Biobehavioral Reviews, Vol.25, No.4, pp.355-373, June 2001.

[https://doi.org/10.1016/S0149-7634(01)00019-7]

-

S. A. Hillyard, and M. Kutas, “Electrophysiology of cognitive processing,” Annual review of psychology, Vol.34, No.1, pp.33-61, February 1983.

[https://doi.org/10.1146/annurev.ps.34.020183.000341]

-

J. Li, J. Pu, H. Cui, X. Xie, S. Xu, T. Li, and Y. Hu, “An online P300 brain–computer interface based on tactile selective attention of somatosensory electrical stimulation,” Journal of Medical and Biological Engineering, Vol.39, pp.732-738, October 2019.

[https://doi.org/10.1007/s40846-018-0459-x]

-

G. R. Müller-Putz, R. Scherer, C. Brauneis, and G. Pfurtscheller, “Steady-state visual evoked potential (SSVEP)-based communication: impact of harmonic frequency components,” Journal of neural engineering, Vol.2, No.4, pp.123, October 2005.

[https://doi.org/10.1088/1741-2560/2/4/008]

-

B. Allison, T. Luth, D. Valbuena, A. Teymourian, I. Volosyak, and A. Graser, “BCI demographics: How many (and what kinds of) people can use an SSVEP BCI?,” IEEE transactions on neural systems and rehabilitation engineering, Vol.18, No.2, pp.107-116, April 2010.

[https://doi.org/10.1109/TNSRE.2009.2039495]

-

C. Guger, S. Daban, E. Sellers, C. Holzner, G. Krausz, R. Carabalona, F. Gramatica, and G. Edlinger, "How many people are able to control a P300-based brain–computer interface (BCI)?," Neuroscience Letters, Vol.462, No.1, pp.94-98, September 2009.

[https://doi.org/10.1016/j.neulet.2009.06.045]

-

C. Guger, B Allison, B. Grosswindhager, R. Prück, C. Hintermüller, C. Kapeller, M. Bruckner, G. Krausz, and G. Edlinger, " How many people could use an SSVEP BCI?," Frontiers in Neuroscience, Vol.6, pp.169, November 2012.

[https://doi.org/10.3389/fnins.2012.00169]

-

B. Allison, T. Lüth, D. Valbuena, A. Teymourian, I. Volosyak, and A. Gräser, "BCI demographics: how many (and what kinds of) people can use an SSVEP BCI?," IEEE transactions on neural systems and rehabilitation engineering, Vol.18. No.2, pp.107-116, January 2010.

[https://doi.org/10.1109/TNSRE.2009.2039495]

-

I. Volosyak, D. Valbuena, T. Lüth, T. Malechka, and A. Gräser, "BCI demographics II: how many (and what kinds of) people can use a high-frequency SSVEP BCI?," IEEE Transactions on Neural Systems and Rehabilitation Engineering, Vo.19, No.3, pp.232-239, March 2011.

[https://doi.org/10.1109/TNSRE.2011.2121919]

-

K. M. Choi, S. Park, and C. H. Im, “Comparison of Visual Stimuli for Steady-State Visual Evoked Potential-Based Brain-Computer Interfaces in Virtual Reality Environment in terms of Classification Accuracy and Visual Comfort,” Computational intelligence and neuroscience, July 2019.

[https://doi.org/10.1155/2019/9680697]

-

J. Xie, G. Xu, J. Wang, M. Li, C. Han, and Y. Jia, “Effects of Mental Load and Fatigue on Steady-State Evoked Potential Based Brain Computer Interface Tasks: A Comparison of Periodic Flickering and Motion-Reversal Based Visual Attention,” PloS one, Vol.11, No.9, pp.e0163426, September 2016.

[https://doi.org/10.1371/journal.pone.0163426]

-

Q. Wu, Y. Zeng, C. Zhang, L. Tong, and B. Yan, “An EEG-Based Person Authentication System with Open-Set Capability Combining Eye Blinking Signals,” Sensors, Vol.18, No.2, pp.335, January 2018.

[https://doi.org/10.3390/s18020335]

-

N. Kaongoen, M. Yu, and S. Jo, “Two-Factor Authentication System Using P300 Response to a Sequence of Human Photographs,” IEEE Transactions on Systems, Vol.50, No.3, pp.1178-1185, March 2020.

[https://doi.org/10.1109/TSMC.2017.2756673]

-

N. Rathi, R. Singla, and S. Tiwari, “A novel approach for designing authentication system using a picture based P300 speller,” Cognitive Neurodynamics, pp.1-20, January 2021.

[https://doi.org/10.1007/s11571-021-09664-3]

-

D. Saravanakumar and M. R. Reddy, “A high performance asynchronous EOG speller system,” Biomedical Signal Processing and Control, Vol. 59, pp.101898, May 2020.

[https://doi.org/10.1016/j.bspc.2020.101898]

-

E. Eddy, E. J, Scheme, and S. Bateman, “A Framework and Call to Action for the Future Development of EMG-Based Input in HCI,” In: Proceedings of the 2023 CHI Conference on Human Factors in Computing Systems, pp.1-23, April 2023.

[https://doi.org/10.1145/3544548.3580962]

- 2022년 1월 : Northern Arizona University, PhD in Bioengineering

- 2022년 2월 ~ 2023년 2월 : 전주대학교 산학협력단 의과학융합연구소 연구교수

- 2023년 3월 ~ 2023년 8월 : 전주대학교 산학협력단 휴먼데이터융합연구소 연구교수

- 2023년 9월 ~ : 경일대학교 스포츠재활의학과 조교수

- ORCID : https://orcid.org/0000-0001-7081-6900

- 주관심분야 : EEG, HCI, AI, Digital Healthcare, Muscle Mechanics, Titin

- 2023년 8월 : 전주대학교 산업공학과 학사

- 2023년 9월 ~ 현재 : 전주대학교 산업공학과 석사과정

- ORCID : https://orcid.org/0009-0008-5198-8246

- 주관심분야 : Metaverse, Brain-Computer Interface, Human Data Science

- 2023년 8월 : 전주대학교 산업공학과 학사

- 2023년 9월 ~ 현재 : 전주대학교 산업공학과 석사과정

- ORCID : https://orcid.org/0009-0002-9249-4636

- 주관심분야 : XR, Human Data Science, Healthcare

- 2012년 8월 : 상명대학교 감성공학과 공학석사

- 2016년 2월 : 상명대학교 감성공학과 공학박사

- 2016년 4월 ~ 2019년 3월: 상명대학교 산학협력단 특임교수

- 2019년 4월 ~ 2022년 3월 : 한국과학기술연구원 바이오닉스연구단 Post-Doc

- 2022년 4월 ~ 현재 : 한양대학교 산학협력단 연구원

- ORCID : https://orcid.org/0000-0002-1236-0754

- 주관심분야 : Emotion Engineering, Social Emotion, Human Factors, 3D, Brain-Computer Interface

- 2016년 2월 : 한양대학교 생체공학과 & 전기공학과 공학사

- 2016년 2월 ~ 2022년 8월 : 한양대학교 생체공학과 공학박사

- 2022년 9월 ~ 현재 : 한국과학기술원 바이오닉스연구단 Post-Doc

- ORCID : https://orcid.org/0000-0001-7671-0162

- 주관심분야 : Brain-Computer Interface, Deep Learning

- 2019년 3월 ~ 현재 : 전주대학교 산업공학과 학사과정

- ORCID : https://orcid.org/0009-0008-7691-2053

- 주관심분야 : Brain-Computer Interface, Data Science, Metaverse

- 2018년 3월 ~ 현재 : 전주대학교 산업공학과 학사과정

- ORCID : https://orcid.org/0009-0005-0390-0172

- 주관심분야 : AI, Brain-Computer Interface, Data Science

- 2015년 2월 : 한국과학기술연구원(UST) HCI & Robotics 공학박사

- 2015년 3월 ~ 2016년 11월 : 한국과학기술연구원 국가기반기술연구본부 박사후연구원

- 2016년 12월 ~ 2017년 6월 : 골프존뉴딘그룹 전략사업실 과장 / 뉴로사이언스 그룹 책임연구원

- 2017년 7월 ~ 2019년 6월 : CJ 그룹 CJ Hello 미래기술전략랩 부장

- 2019년 6월 ~ 2020년 8월 : 서울시 서울기술연구원 도시전략연구실 연구위원

- 2020년 8월 ~ 현재 : 전주대학교 산업공학과 조교수

- 2022년 9월 ~ 현재 : 전주대학교 휴먼데이터융합연구소 연구소장

- 2023년 6월 ~ 현재 : 전주대학교 소프트웨어융합대학 데이터공학과 준비위원장

- ORCID : https://orcid.org/0000-0003-4596-9889

- 주관심분야 : Data Science, Deep Learning, Machine Learning, XR-AI, Digital Healthcare, Neuroscience, HCI