원격 영상에서 심층 잔차 밀집 기반의 초고해상도 기법을 이용한 차량 검출 알고리즘

Copyright © 2023, The Korean Institute of Broadcast and Media Engineers

This is an Open-Access article distributed under the terms of the Creative Commons BY-NC-ND (http://creativecommons.org/licenses/by-nc-nd/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited and not altered.

초록

원거리에서 특정 영역의 물리적 특성 또는 상황에 대한 정보를 얻기 위해 원격 탐사 영상에 객체 검출 기법이 연구되고 있다. 이때 저해상도인 원격 영상은 정보의 손실로 인해 객체 검출의 정확도가 떨어지는 문제가 발생한다. 본 논문에서는 이러한 문제점을 해결하기 위해 초고해상도 기법과 객체 검출 방법을 하나의 네트워크로 구성하여 원격 영상에서 객체 검출의 성능을 높이는 방법을 제안한다. 제안한 방법은 심층 잔차 밀집 기반의 네트워크를 구성하여 저해상도 영상에서 객체의 특징을 복원하고자 하였다. 추가적으로 이를 객체 검출 단계인 YOLOv5와 하나의 네트워크로 구성함으로써 객체 검출의 성능을 향상시키고자 하였다. 제안한 방법은 저해상도 영상을 위해 VEDAI 데이터를 이용하였으며 차량 검출에서 VISIBLE 기준으로 mAP@0.5에 대해 81.38%까지 향상됨을 확인하였다.

Abstract

Object detection techniques are increasingly used to obtain information on physical characteristics or situations of a specific area from remote images. The accuracy of object detection is decreased in remote sensing images with low resolution because the low resolution reduces the amount of detail that can be captured in an image. A single neural network is proposed to joint the super-resolution method and object detection method. The proposed method constructs a deep residual-based network to restore object features in low-resolution images. Moreover, the proposed method is used to improve the performance of object detection by jointing a single network with YOLOv5. The proposed method is experimentally tested using VEDAI data for low-resolution images. The results show that vehicle detection performance improved by 81.38% on mAP@0.5 for VISIBLE data.

Keywords:

Autonomous Vehicle, Super Resolution, Residual-based network, Object DetectionⅠ. Introduction

자율주행에서 도로 위의 차량 검출은 안전한 주행을 위한 필수적 요소 중의 하나이다[1-3]. 그러나 항공 이미지는 높은 고도에서 촬영되는 특성상 차량 검출 성능이 크게 저하된다. 또한, 위성 영상과 같은 저해상도의 영상은 특징에 대한 정보의 손실이 더 심하기 때문에 객체 검출 시 물체를 정확하게 식별하기 어렵다[4-5]. 이러한 경우, 초고해상도(Single Image Super Resolution) 기법은 저해상도 영상의 열악한 감지 성능을 극복하기 위해 사용된다. 초고해상도를 통한 객체 검출 알고리즘은 딥러닝 알고리즘의 발전과 함께 지속적으로 발전하고 있다. Ivan 등[6]은 컨볼루션 신경망과 초고해상도 기법을 이용해 객체 검출 성능을 향상시켰다. Sheng 등[7]은 초고해상도와 심층 융합 신경망(Deep Fusion Network)를 활용해 공공안전을 위한 효율적인 영상검출 기법을 개발했다. 한편, 초고해상도 알고리즘과 별도로 객체 검출에 대한 알고리즘도 함께 발전하고 있다. Xinqing 등[8]은 교통 현장에서의 객체 검출을 위한 하나의 영상에서 멀티박스 검출기(SSD)를 향상시켰다. Luc 등[9]은 소형 물체 탐지를 위한 보조 생성적 적대 신경망(GAN)과 함께 초고해상도를 사용하여 신경망을 구현했으며 Yunyan 등[10]은 원격 탐사 이미지에서 초고해상도로 평면을 감지하기 위해 생성적 적대 신경망을 최적화했다. 최근 Chen et al.[14]는 항공 영상의 객체를 검출하기 위하여 방향성을 고려한 멀티 스케일과 계층적 특징 맵을 설계하여 신경망에 적용하는 방법을 제안하였다. 이를 통해 크기가 작고 방향이 변하더라도 객체를 탐지하는 성능을 높이고자 하였다. 한편, Yogendra et al.[15]는 스펙트럼 정규화 기반의 잔차 블록을 이용하여 저해상도의 특징 정보를 복원하는 방법을 제안하였다. 이 방법은 학습단계에서 발생하는 가중치의 급격한 변화를 줄여줌으로써 안정적인 학습이 가능하여 결과적으로 저해상도 영상의 복원시 화소 손실을 줄여주는 역할을 한다.

본 논문에서는 제안한 초고해상도 알고리즘을 객체 검출 알고리즘에 접목하여 하나의 네트워크로 구성함으로써 위성 영상과 같은 저해상도의 물체에 대한 객체 검출 성능을 높이는 알고리즘을 제안한다. 제안한 방법은 기존 방법들과 달리 두 가지의 차별점이 있다. 첫 번째는 새로운 초고해상도 방법인 DRDN 기법의 제안이다. 이 방법은 잔차 블록을 심층적으로 구성함으로써 저해상도 영상으로부터 계층적 특징과 전역적인 특성을 복원할 수 있다. 두 번째는 제안한 초고해상도 기법을 객체 인식 방법인 YOLOv5과 융합하여 하나의 네트워크로 구성한 것이다. 이를 통해 초고해상도와 객체 인식 네트워크가 하나로 학습됨으로써 원격 영상과 같은 저해상도의 객체 인식의 성능을 높일 수 있게 되었다. 제안한 방법을 검증하기 위해 공개 데이터인 VEDAI-VSIBLE 및 VEDAI-IR 데이터를 이용하였으며, 이를 통해 기존 방법들보다 우수한 성능을 확인할 수 있었다.

Ⅱ. 제안한 심층 잔차 블록 신경망 기반 객체 검출 네트워크

위성 원격 영상은 시스템의 한계로 충분한 정보가 제공되기 어렵다. 특히 본 논문에서와 같이 도로 위의 객체 즉 움직이는 자동차를 검출하는 응용에서는 날씨 등의 변수를 제외하더라도 영상의 블러링 등이 객체의 특징 정보를 더욱 제한하여 검출의 결과에 영향을 준다. 제안한 방법은 원격 영상에서 초고해상도와 객체 검출을 하나의 네트워크로 연결하여 작은 객체인 차량을 검출하고자 한다.

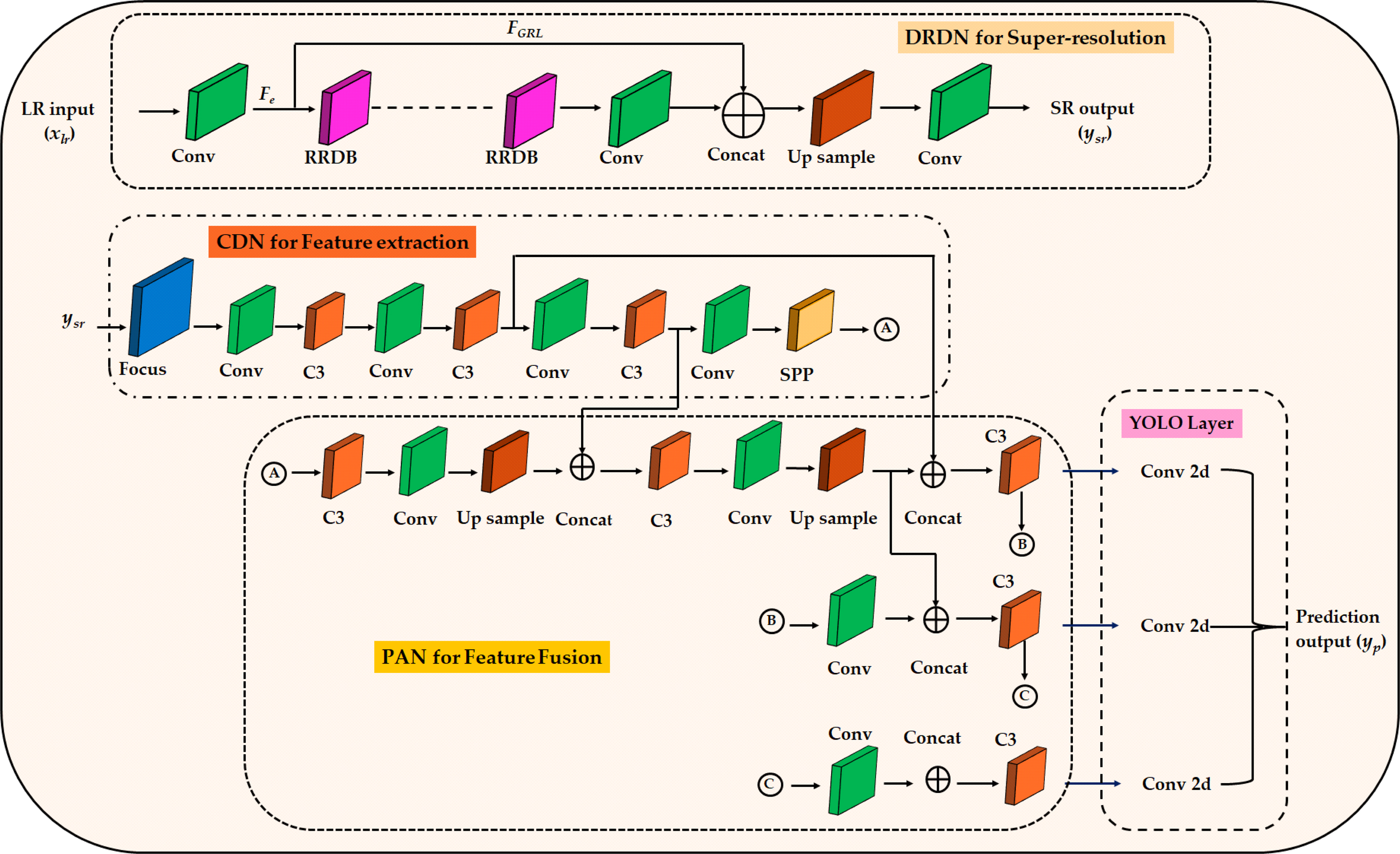

이때, 시스템을 최적화하여 시간 복잡성을 줄이고 검출 성능을 향상하는 데 중점을 둔다. 그림 1은 제안한 네트워크의 흐름도이다. 시스템의 입력으로는 저해상도 영상이 사용되고 최종 출력은 훈련된 클래스인 차량을 예측하는 데 사용된다. 세부 구조로는 초고해상도와 객체 검출 신경망을 각각 훈련하는 게 아니라, 하나로 구성하게 된다. 이때 초고해상도는 심층 잔차 밀집 신경망으로 구성함으로써 고주파 성능에 대한 특징 추출을 목적으로 하고, 객체 검출 단계에서는 계층적 특징 검출이 가능한 YOLOv5 네트워크를 사용하여 검출의 성능을 높이고자 하였다. 제안한 초고해상도 기반 객체 검출 신경망은 초고해상도 네트워크와 객체 검출 네트워크로 구성된다. 첫 번째 구성요소인 초고해상도 기법은 잔차 신경망으로 구성된다. 일반적으로 심층 신경망(Deep Neural Network)을 설계하는 데 있어서 잔차 신경망에서는 기울기 소실(gradient vanishing)을 방지하고 네트워크의 유연성을 확보하기 위해 건너뛰기 연결(skip connection)을 사용한다. 최근, 초고해상도 신경망 모델 중 하나인 초고해상도 목적의 강화된 심층 잔차 신경망(EDSR)이 초고해상도 성능을 크게 향상시킨 것으로 나타났다. 본 논문에서는 BN 블럭을 제거하여 초고해상도 신경망을 개선하고 높아진 연산 비용을 개선하기 위해서 단층 잔차 신경망을 기반으로 설계된 심층 잔차 밀집 신경망(DRDN)으로 설계하였다. 심층 잔차 밀집 신경망의 기본 구조는 그림 1에 묘사되어 있으며 20개의 이중 잔차 농도 블록(Residual-Residual Dense Block, RRDB)들이 순차적으로 연결되어 있는 것이 특징이다.

제안된 작은 객체를 검출하기 위한 초해상화 기반의 객체 검출 신경망 흐름도Fig. 1. Flowchart of small object detection network based on super-resolution for remote sensing images

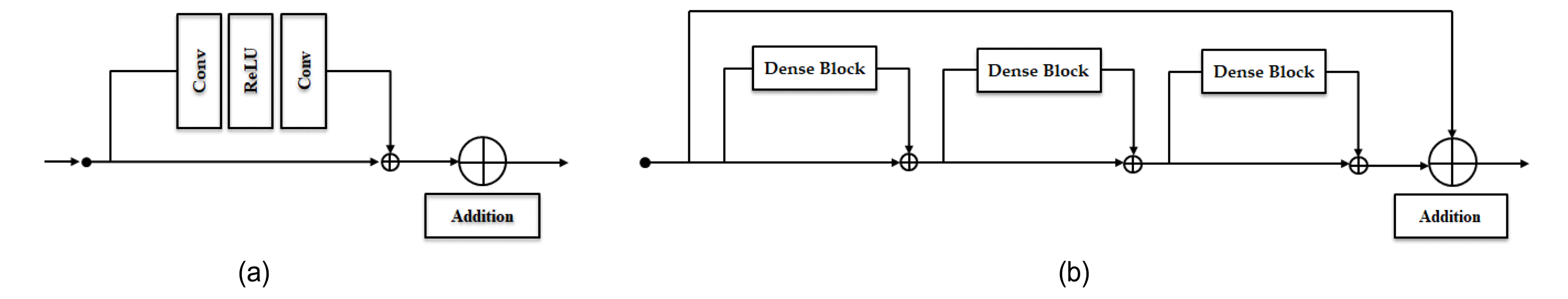

EDSR의 잔여 블록과 제안된 모델 간의 비교는 그림 2에 나와 있다. EDSR 방법은 그림 2(a)와 같이 두 개의 컨볼루션 레이어와 ReLU(Rectified Linear Unit)로 구성되어 있다. 컨볼루션 레이어는 특징 추출에 사용되었으며 ReLU는 네트워크를 활성화하는 데 사용된다. 본 논문에서 제안한 방법은 모델의 깊이에 따라 RRDB 레이어 수는 동일하게 구성되며 제안한 RRDB 모델은 그림 2(b)와 같이 3개의 잔여 농도 블록(Residual dense block, RDB)으로 구성된다. 각각의 RRDB에는 세 개의 잔차 밀집 블록이 사용되고, 각각의 잔차 밀집 블록은 또다시 다섯 개의 컨볼루션 레이어로 구성된다. 그 중 4개의 컨볼루션 레이어는 3X3 크기의 커널과 64개의 특징 맵(feature map)으로 구성되고 뒤따라 활성화 함수로써 Leakey Rectified Linear Unit(LReLU)을 사용한다. 나머지 하나의 컨볼루션 레이어는 잔차 밀집 블록(RDB)에서 잔차 학습을 통해 특징들을 합산하는 데 사용된다. 이 모델의 진행과정은 입력으로 사용되는 저해상도 이미지 xlr로 시작해 DRDN 모델의 출력인 ysr을 도출한다. 저해상도 이미지의 특징 맵 정보는 x이며, 수학적으로 컨볼루션 레이어는 다음과 같이 나타낼 수 있다.

잔여 블록의 모델의 비교 (a) EDSR 기법, (b) 제안한 방법Fig. 2. Comparison of residual blocks model. (a) EDSR residual block, (b) Proposed method with deep residual block

여기서 𝑙은 lth 컨볼루션 레이어, Wl은 lth 컨볼루션 레이어의 필터 개수를 나타내고 Gl-1은 이전 레이어에서의 출력의 특징 맵을 나타낸다. 𝐹𝑒은 특징 맵의 출력이며 '∗'는 컨볼루션 연산을 나타낸다. RRDB 레이어의 결과값은 수학적으로 (2)와 같이 표현된다.

여기서 rd는 잔차 밀집 블록(RDB) 안의 rdth 잔차 레이어(Residual Layer), HRDB,rd는 rdth 잔차 레이어의 LReLU 활성화 함수와 컨볼루션의 결합 연산을 나타낸다. FRRDB는 모든 결합된 RDB들과 RRDB인 Frrl의 합이다. 신경망들의 융합인 Ffusion은 (3)과 같이 나타난다.

여기서 Fe는 특징 맵의 출력을 나타내고 FRRDB는 RRDB의 출력을 나타낸다. 그리고 FGRL은 전역 잔차 학습을 나타낸다. 마지막으로 초고해상 모델에서 도출된 이미지는 다음 식 (4)와 같이 표현된다.

여기서 HDRDN은 초고해상도 모델의 컨볼루션 연산, ysr은 모델의 초고해상도 과정 후 출력 이미지를 나타내고 xlr은 저해상도 입력 이미지를 나타낸다.

초고해상도 이미지는 제안한 방법의 다음 단계인 객체 검출 신경망에 제공된다. 제안한 방법에서 객체 검출 신경망으로는 YOLOv5를 사용하며 초고해상도 모델에서 생성된 초고해상도 이미지에 대해 학습한다. 객체 인식 신경망은 업샘플링 된 블록이 있는 세 단계(백본, 넥, 헤드)로 구성된다. 첫 번째 단계는 백본 신경망인 CDN(Cross stage spatial network & Darknet Network)로써 특징추출을 위해 사용된다. CDN은 크로스 스테이지 공간 신경망과 다크넷(Darknet)으로 구성되는데, 전자는 각각 입력된 영상에서 세분화된 공간 세부 정보를 추출하고, 후자는 객체 검출 분류를 위한 학습 및 평가를 위해 개발된 네트워크이다. 두 번째 단계는 일반적으로 경로 집계 신경망인 PANet으로써, 하나의 객체 검출 아키텍처로 구성된다. 즉, 영역 제안 및 객체 검출에서 기존의 2단 구조가 아닌 단일 신경망을 사용해 이미지에서 객체의 경계 영역 및 확률을 예측한다. 마지막 단계는 YOLO 레이어라 불리는 헤드 신경망이다. 데이터는 먼저 특징 추출을 위해 CDN에 입력된 다음 특징 융합을 위해 PANet에 공급된다. 마지막으로 YOLO 레이어는 다음 수식과 같이 객체의 검출 결과를 나타낸다.

Hfe는 CSPNet과 DarkNet을 이용해 ysr의 특징을 추출하는 컨볼루션 연산을 나타낸다. 그 다음 Hff는 CDN과 PAN을 통한 특징 융합 그리고 HYOLO는 초해상화 이미지에서 객체를 분류하기 위한 헤드 신경망의 컨볼루션 연산을 의미한다. 제안한 방법의 최종 결과는 다음 식으로 표현된다.

여기서 PDds는 초고해상도 이미지에서 물체를 분류하기 위한 클래스에 대한 예측이고 yp는 초고해상도 영상에서의 차량 물체에 대한 예측을 나타낸다. 또한, 신경망은 훈련하기 위한 손실함수가 필요하다. 훈련에서 사용된 손실은 최적화를 위해 널리 이용되는 방법이며 픽셀 단위 손실 또는 평균제곱오차로써 손실함수에 대한 식은 다음과 같이 나타낸다.

Ⅲ. 실험 및 결과

제안한 방법은 원격 위성 영상 데이터인 VEDAI-VISIBLE을 이용하였으며, CUDA 11.6이 설치된 단일 NVIDIA RTX A6000 GPU에서 진행되었다. 본 논문의 실험은 위성 영상에서 객체 인식에 초점을 맞췄다. 실험 데이터의 훈련을 위해서 저해상도 및 고해상도 데이터로 분할하였다. 두 데이터 세트의 고해상도 데이터 세트는 각각 크기가 512X512인 688개의 이미지로 구성되어 있고 저해상도 데이터 세트를 4배 축소하였다. 실험을 수행하기 위해 데이터 세트를 무작위로 반으로 분할하여 훈련 및 검증 세트를 구성하였다. 훈련 매개변수는 다음과 같다. 운동량은 0.937, 가중치 감소 함수는 0.0005, 초기 학습률은 0.01, 배치 크기는 16, 합집합 임계값은 0.25, 에포크는 300, 기본 입력 이미지 크기는 512X512. 워밍업 모멘텀은 0.8로 설정되었으며 임의의 색조, 채도, 값, 이미지 회전(가로, 세로), 이미지 상하 반전, 이미지 좌우 반전을 사용하였다. 실험을 위해 배치 크기는 1로 입력 크기는 훈련과 동일하게 하였고, 예측 상자에 대한 신뢰 임계값은 0.001, 비최대 억제에 대한 IoU 임계값은 0.65이다. 훈련 및 검증을 수행하는 동안 신경망은 각 감지 레이어에 대한 좌표 손실, 경계자 회귀 손실(box_loss), 객체 손실(obj_loss) 및 분류 손실(cls_loss)을 이용하여 손실을 다음과 같이 계산한다.

여기서

는 격자 셀 i의 jth 경계 박스에 의해 감지된 객체이다. xi, yi, wi, hi는 실제 경계 박스 좌표이고 예측 경계 박스 좌표는

는 격자 셀 i의 jth 경계 박스에 의해 감지된 객체이다. xi, yi, wi, hi는 실제 경계 박스 좌표이고 예측 경계 박스 좌표는

,

,

,

,

,

,

이다. Ci는 셀 i에 있는 실제 박스의 신뢰도 점수이고

이다. Ci는 셀 i에 있는 실제 박스의 신뢰도 점수이고

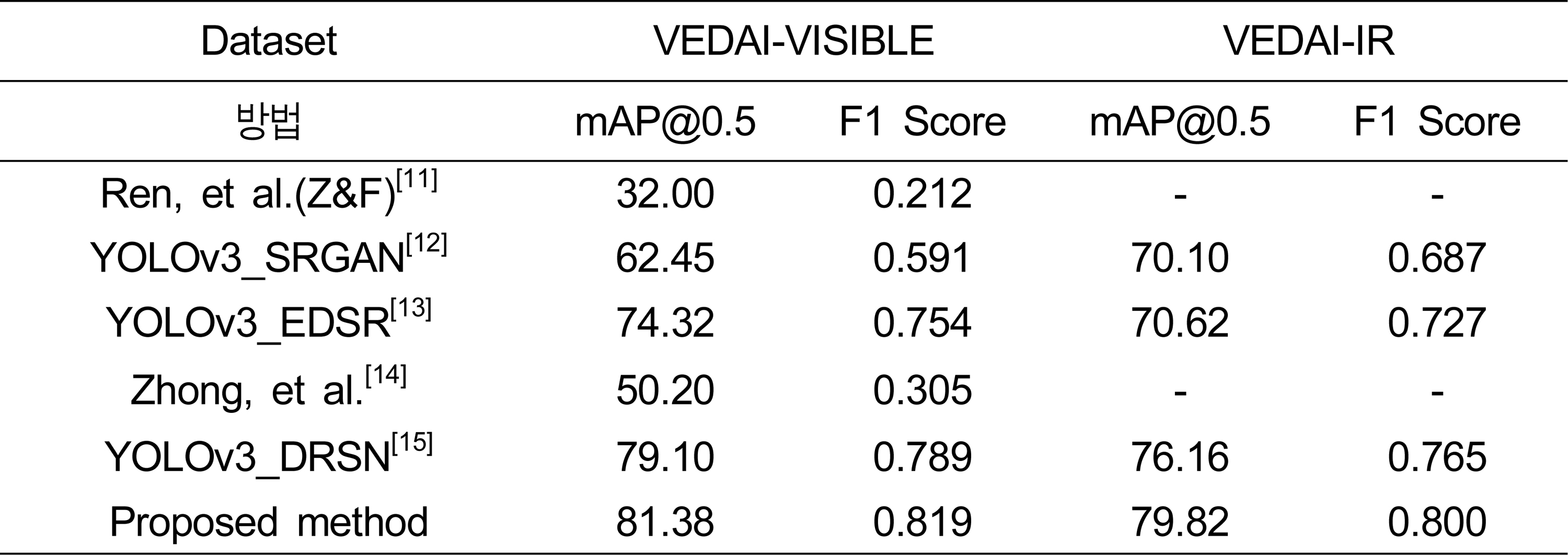

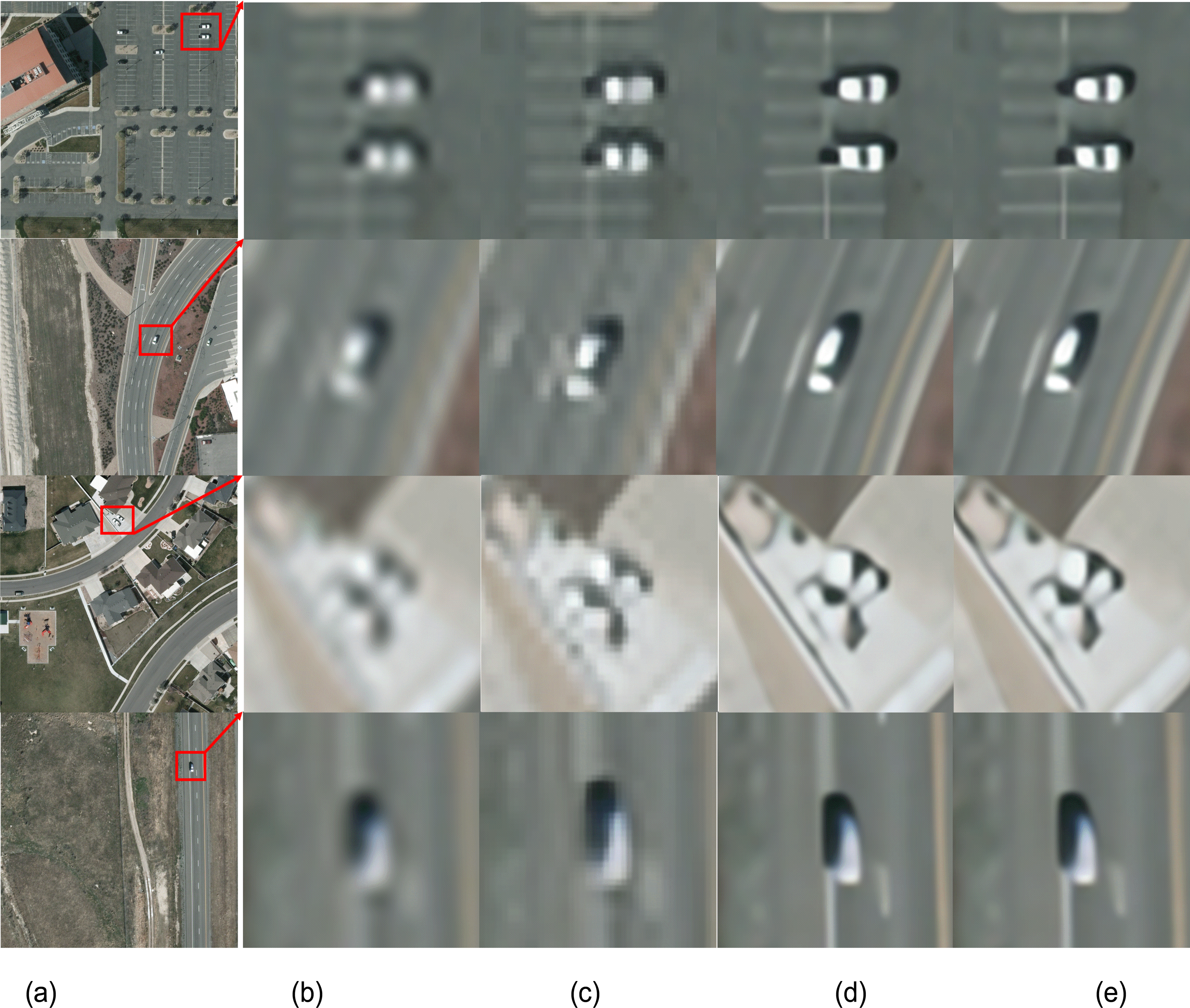

는 예측된 박스의 신뢰도 점수이다. 그림 3에는 다양한 방법의 초해상도 방법에 대한 결과를 나타내었다. 영상에서 특정 영역을 기존의 VDSR과 EDSR 및 제안한 방법과 비교하였다. 더 나아가 표준 데이터인 VEDAI-VISIBLE과 VEDAI-IR로써, 성능을 평가하기 위해 PSNR, SSIM, PIQE 및 NIQE를 활용하였다. 제안한 방법의 정확도 평가 결과는 표 1에 나타내었다. 성능 평가를 위해 항공 영상에서 차량 감지에 대해 mAP 및 F1 점수와 같은 정량적 메트릭을 사용하였다. VEDAI-VISIBLE과 VEDAI-IR에 대하여 mAP 값과 F1 점수는 유효성에 따라 다양한 방법에 대해 결과를 계산하였다. mAP는 다양한 재현율 값에서 최대 정밀도의 평균으로 계산했다. mAP는 각 클래스의 평균 정밀도(AP)를 사용하여 계산하고 전체 클래스 수로 나눈다.

는 예측된 박스의 신뢰도 점수이다. 그림 3에는 다양한 방법의 초해상도 방법에 대한 결과를 나타내었다. 영상에서 특정 영역을 기존의 VDSR과 EDSR 및 제안한 방법과 비교하였다. 더 나아가 표준 데이터인 VEDAI-VISIBLE과 VEDAI-IR로써, 성능을 평가하기 위해 PSNR, SSIM, PIQE 및 NIQE를 활용하였다. 제안한 방법의 정확도 평가 결과는 표 1에 나타내었다. 성능 평가를 위해 항공 영상에서 차량 감지에 대해 mAP 및 F1 점수와 같은 정량적 메트릭을 사용하였다. VEDAI-VISIBLE과 VEDAI-IR에 대하여 mAP 값과 F1 점수는 유효성에 따라 다양한 방법에 대해 결과를 계산하였다. mAP는 다양한 재현율 값에서 최대 정밀도의 평균으로 계산했다. mAP는 각 클래스의 평균 정밀도(AP)를 사용하여 계산하고 전체 클래스 수로 나눈다.

VEDAI-Visual 데이터에 대한 다양한 방법의 초고해상도 실험 결과 (a) HR, (b) LR, (c) VDSR, (d) EDSR, (e) 제안한 방법Fig. 3. Experiment results of the several methods for VEDAI-Visual data (a) HR, (b) LR, (c) VDSR, (d) EDSR, and (e) Proposed method

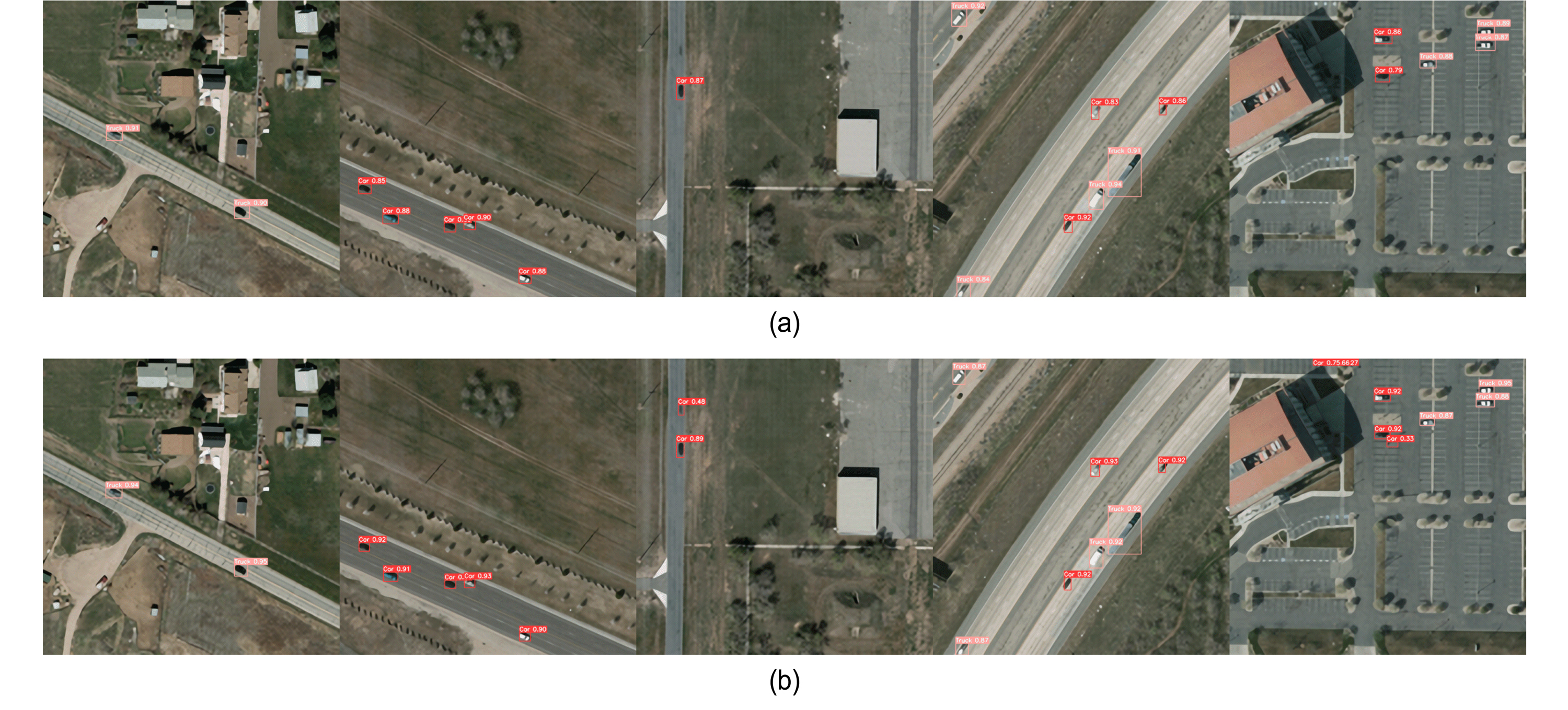

본 논문에서 0.5의 임계값에서 mAP를 계산했으며, 여기서 제안한 방법의 각 데이터 세트의 mAP는 각각 81.38, 79.82였다. 추가적으로 VEDAI-VISIBLE에 대한 차량 감지 결과는 그림 4에 나타내었다. 이 결과에서 EDSR에서 검출하지 못한 차량을 제안한 방법에서는 인지함을 확인할 수 있다.

Ⅳ. 결 론

이 논문에서는 원격탐사 영상에서 객체 검출의 성능을 높이기 위해 초고해상도 기법을 이용한 객체 검출을 제안했다. 저해상도 영상을 복원하기 위해서는 심층 잔차 밀집 기반 네트워크를 이용하여 인지 특성을 높이고자 하였으며, 객체 검출 단계에서는 YOLOv5와의 결합을 통해 성능을 개선하였다. 제안한 방법의 성능을 평가하기 위해 위성 데이터에 대해 실험을 수행했으며, 제안한 방법이 기존 방법들에 비해서 객체 검출 성능 측면에서 더 우수한 결과를 나타냄을 확인하였다.

Notes

References

-

Thomas, M., Farid, M., Automatic Car Counting Method for Unmanned Aerial Vehicle Image, IEEE Transactions on Geoscience and Remote Sensing, (2014, Mar.), 52(3), p1635-1647.

[https://doi.org/10.1109/TGRS.2013.2253108]

-

Liu, K, Mattyus, G., Fast Multi-class Vehicle Detection on Aerial Images, IEEE Geosci. Remote Sens. Lett., (2015), 12(9), p1938-1942.

[https://doi.org/10.1109/LGRS.2015.2439517]

-

Shengjie, Z., Jinghong, L., Yang, T., Yujia, Z., Chenglong, L., Rapid Vehicle Detection in Aerial Images under the Complex Background of Dense Urban Areas, Remote sensing, (2022), 14(9), p1-22.

[https://doi.org/10.3390/rs14092088]

-

Saeed, A., Salman, K., Nick, B., A Deep Journey into Super-resolution: A Survey, ACM Comput. Surv., (2020), 53, p1-21.

[https://doi.org/10.48550/arXiv.1904.07523]

-

Jiandan, Z., Tao, L., Guangle, Y., Robust Vehicle Detection in Aerial Images Based on Cascaded Convolutional Neural Networks, Sensors, (2017), 17(12), p1-17.

[https://doi.org/10.3390/s17122720]

-

Ivan, G., Marcos, B., Ezequiel, R., Improved Detection of Small Objects in Road Network Sequences using CNN and Super Resolution, Expert Systems, (2021), 39(2), p1-17.

[https://doi.org/10.1111/exsy.12930]

-

Sheng, R., Jianqi, L., Tianyi, T., Yibo, P., Jian, J., Towards Efficient Video Detection Object Super-Resolution with Deep Fusion Network for Public Safety, Security and Communication Networks, (2021), 1, p1-14.

[https://doi.org/10.1155/2021/9999398]

-

Xinqing, W., Xia, H., Feng, X., Yuyang, L., Xiaodong, H., Pengyu, S., Multi-Object Detection in Traffic Scenes Based on Improved SSD, Electronics, (2018), 7(11), p1-28.

[https://doi.org/10.3390/electronics7110302]

-

Luc, C., Tan, P., Sebastien, L., Small Object Detection in Remote Sensing Images Based on Super-Resolution with Auxiliary Generative Adversarial Networks, Remote Sensing, (2020, Sep.), 12(19), p1-19.

[https://doi.org/10.3390/rs12193152]

-

Yunyan, W., Huaxuan, W., Luo, S., Chen, P, Zhiwei, Y., Detection of Plane in Remote Sensing Images using Super-resolution, Plosone, (2022, Apr.), 17(4), p1-19.

[https://doi.org/10.1371/journal.pone.0265503]

-

Ren, S., He, K., Girshick, R., Sun, J., Faster R-CNN: Towards Real-Time Object Detection with Region Proposal Networks, IEEE Trans. Pattern Anal. Mach. Intell., (2017, June), 39(6), p1137-1149.

[https://doi.org/10.1109/TPAMI.2016.2577031]

-

Mostofa, M., Ferdous, S., Riggan, B., Nasrabadi, N., Joint-SRVDNet: Joint Super Resolution and Vehicle Detection Network, IEEE Access, (2020, May), 8, p82306-82319.

[https://doi.org/10.1109/ACCESS.2020.2990870]

-

Bee, L., Sanghyun, S., Heewon, K., Seungjun, N., Kyoungmu, L., Enhanced Deep Residual Networks for Single Image Super-Resolution, Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Honolulu, HI, USA, (2017, June), p21-26.

[https://doi.org/10.48550/arXiv.1707.02921]

-

Chen, C., Zhong, J., Tan, Y., Multiple-oriented and Small Object Detection with Convolutional Neural Networks for Aerial Image, Remote Sensing, (2019), 11(18), p1-23.

[https://doi.org/10.3390/rs11182176]

- Yogendra, M., Arvind, M., Seol, K., Single Image Super-Resolution Using Deep Residual Network with Spectral Normalization, 17th International Conference on Multimedia Information Technology and Application, Jeju, Korea, (2021, July), p1-2.

권 오 설

- 2008년 8월 : 경북대학교 전자공학과 박사

- 2008년 9월 ~ 2010년 8월 : New York University, Psychology 박사후연구원

- 2010년 9월 ~ 2011년 8월 : 삼성전자 영상디스플레이사업부 책임연구원

- 2021년12월 ~ 2022년 8월 : Princeton University, Electrical & Computer Engineering 방문교수

- 2011년 9월 ~ 현재 : 창원대학교 로봇제어계측공학과 교수

- 주관심분야 : 영상처리, 인공지능, 로봇비전