Light-field 이미지로 변환된 다중 평면 홀로그램 영상에 대해 객체 검출 알고리즘을 적용한 평면별 객체의 깊이 정보 해석 및 조절 기법

Copyright © 2023, The Korean Institute of Broadcast and Media Engineers

This is an Open-Access article distributed under the terms of the Creative Commons BY-NC-ND (http://creativecommons.org/licenses/by-nc-nd/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited and not altered.

초록

재생하고자 하는 3차원 이미지에서 발현되는 빛의 간섭 무늬를 계산하여 얻게 되는 Computer Generated Hologram(CGH)은 본래의 3차원 이미지와 유사관계를 찾기 힘든 형태로 형성되기에 직접적인 초점 위치 혹은 크기 등의 변환이 어려운 것으로 알려져 있다. 본 논문은 이러한 문제 중 하나인 다중 평면으로 구성된 3차원 이미지 CGH의 평면별 초점 거리를 변환하는 문제를 해결하는 기술을 제안한다. 제안하는 기술은 CGH로부터 재생되는 3차원 이미지를 여러 각도에서 관측한 2차원 이미지의 집합으로 구성된 Light-Field (LF) 이미지로 변환하고, 관측한 각도별로 이동하는 객체의 위치를 객체 탐지 알고리즘인 YOLOv5(You Only Look Once version 5)로 분석한 뒤, 이를 조절함으로써 초점 거리가 변환된 LF 이미지와 이를 역변환한 결과인 CGH를 생성한다. 해당 기술은 CGH의 픽셀 사이즈가 3.6 μm, 해상도가 3840⨯2160인 상황에서 10 cm 거리에 재생되는 상에 적용되어 영상 품질의 큰 손실 없이 약 3 cm 정도의 범위에서 초점 거리를 변환시킬 수 있음을 시뮬레이션 분석과 실제 실험 관측을 통해 확인하였다.

Abstract

Directly converting the focal depth and image size of computer-generated-hologram (CGH), which is obtained by calculating the interference pattern of light from the 3D image, is known to be quite difficult because of the less similarity between the CGH and the original image. This paper proposes a method for separately converting the each of focal length of the given CGH, which is composed of multi-depth images. Firstly, the proposed technique converts the 3D image reproduced from the CGH into a Light-Field (LF) image composed of a set of 2D images observed from various angles, and the positions of the moving objects for each observed views are checked using an object detection algorithm YOLOv5 (You-Only-Look-Once-version-5). After that, by adjusting the positions of objects, the depth-transformed LF image and CGH are generated. Numerical simulations and experimental results show that the proposed technique can change the focal length within a range of about 3 cm without significant loss of the image quality when applied to the image which have original depth of 10 cm, with a spatial light modulator which has a pixel size of 3.6 μm and a resolution of 3840⨯2160.

Keywords:

Digital hologram, Computer generated hologram, Light field image, Object detection algorithm, Image conversionⅠ. 서 론

홀로그램은 현재까지 발표된 3차원 영상 재생 기술들 중 가장 이상적인 기술로 지목받고 있으며, 최근에는 정보 보안 장치 및 차세대 반도체 공정 등의 분야에서도 활용 가능성을 인정받아 다양한 분야에 접목되어 연구되고 있다[1][2]. 이러한 홀로그램의 원리는 구현하고자 하는 3차원 이미지로부터 반사되어 나오는 빛이 이루어내는 간섭무늬를 획득하고, 이를 다시 재생함으로써 당초 목표한 이미지를 구현하는 것이라 할 수 있다. 해당 과정에서 3차원 이미지로부터 시작하는 빛들의 간섭 양상을 컴퓨터로 직접 계산하여 얻는 홀로그램을 Computer-Generated-Hologram (CGH)라고 한다[3]-[5].

CGH는 주로 공간 광 변조 장치(Spatial light modulator, SLM)라는 디스플레이 장비를 통해 재생되기에 그로부터 제한되는 픽셀 수와 크기를 기반으로 연산이 이루어지게 되며, 매우 작은 범위에서 구현되는 CGH를 계산하는 과정조차 필요로 하는 연산량이 매우 방대하여 현재까지 지속적인 연산 최적화 연구가 진행되어왔다. 해당 연구의 대표적인 성과인 푸리에 해석에 기반한 효율적인 CGH 연산 방식인 Angular spectrum method(ASM)와 최근 주목받고 있는 경사하강법에 기반한 CGH 연산 기법 등은 연산 시간 대비 획득하게 되는 CGH의 품질을 극적으로 향상시키는데 이바지하였으나 실시간 CGH 생성 수준의 기술 구현은 현재까지도 도전해야 할 과제로 남아있다[6]-[9].

이에 대한 해결방안 중 하나로 CGH 영상 수정 기술이 많은 연구자들의 관심을 끌고 있다[10]-[13]. 해당 기술은 복잡한 CGH 연산 과정을 개별 이미지별로 따로 수행하는 것을 회피하고 기존에 생성된 CGH를 수정함으로써 유사한 이미지를 재생하는 CGH를 획득하는 방법을 말한다. 그러나 CGH 영상 수정 기술은 직관적으로 받아들여지는 2차원 영상과는 달리 빛의 간섭무늬에 대해 이루어지기에 많은 문제점이 나타나게 된다. 특히 3차원 영상의 크기 변환 문제에 있어 디스플레이 장비에 평행한 방향과 수직인 방향으로의 변환 비율이 비선형적으로 이루어지는 문제 등이 대표적인 사례에 해당한다.

우리는 이러한 CGH 영상 수정 문제들 중 하나인 3차원 영상의 객체별 초점 거리 조절을 수행하는 기술로, 다중 평면으로 구성된 3차원 영상을 여러 각도 성분으로 구분된 2차원 영상의 집합인 LF 이미지로 변환하고, 현재 보편화된 객체 검출 알고리즘인 YOLOv5l 모델을 사용하여 영상을 구성하는 평면별 객체를 검출한 뒤, 평면별 깊이 정보 해석을 거쳐 객체가 뷰 별로 이동하는 범위를 조절함으로써 객체의 깊이 정보를 수정하는 기술을 제안하고자 한다. 본 논문은 제안하는 기술을 통해 초점 거리를 조절한 이미지에서 나타나는 신호대비 잡음비를 비교함으로써 조절 가능한 범위를 확인하고, 실제 실험을 수행하여 이를 검증하는 내용을 포함한다.

Ⅱ. CGH 영상의 LF 변환과 각도 성분별 객체 이동 분석

1. CGH 영상의 LF 변환

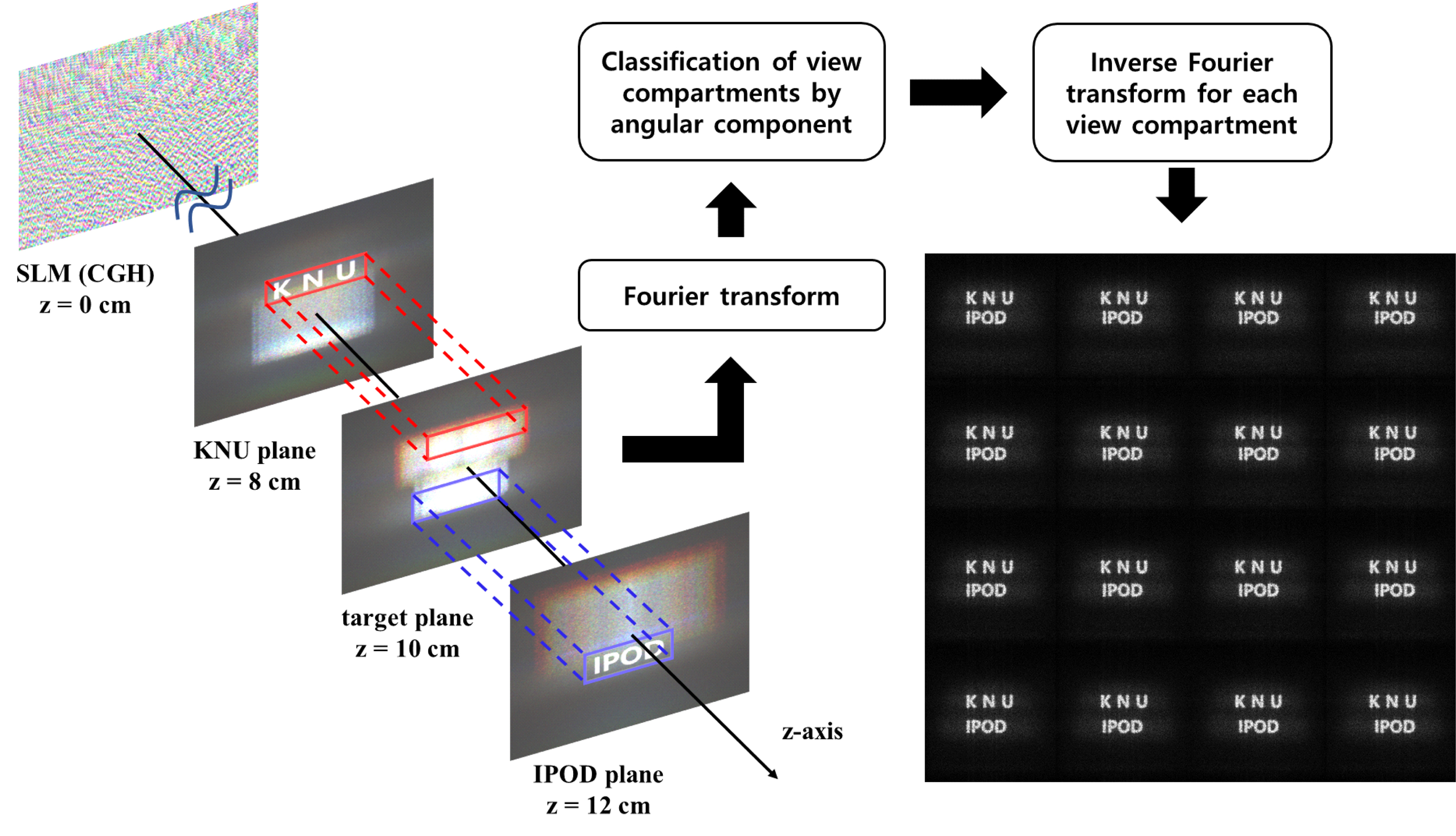

우리는 먼저 재생된 3차원 이미지를 여러 각도 관점에서 바라본 결과들의 집합으로 구성된 LF 이미지로 변환하는 과정을 설명하고자 한다. 그림 1에서 왼쪽 부분의 모식도는 SLM에 입력된 CGH를 통해 8 cm 거리에서 KNU, 12 cm 거리에서 IPOD 글자가 재생되는 상황을 나타낸다. 그림 내의 CGH는 ASM 방식에 기반한 시뮬레이션 셋업 상에서 8 cm, 12 cm 거리에서 검은 바탕 위에 흰색 KNU와 IPOD 글자가 적힌 이미지가 있는 경우를 가정하고 계산하여 획득하였다. 계산과정에 고려된 픽셀 사이즈는 3.6 μm, CGH 해상도는 3840⨯2160이고, 빛의 파장은 각각 660 nm, 521 nm, 445 nm에 대하여 계산하였다.

우리는 이들 중 10 cm 지점에서 나타나는 이미지에 대하여 푸리에 변환을 수행하였고, x, y 축 각각의 방향으로 약 2.1도 이내에 상응하는 공간주파수 영역을 책정하였다. 그리고 해당 영역 내에서 겹치는 부분을 허용하며 256⨯256 크기의 해상도를 지닌 16⨯16개의 하위 영역을 산출하고 각 영역에 대해 개별적으로 역 푸리에 변환을 수행하여 LF 이미지를 획득하였다. 각각의 하위 LF 이미지 영역들은 재생한 다중 평면 3차원 영상을 각 x, y 방향으로 –2.1도에서 2.1도 범위 내에서 16개의 동일 간격으로 떨어진 위치에서 바라본 결과를 의미하며, 그림 1의 오른쪽 아래 그림은 위 과정에서 얻은 LF 이미지의 가장 가운데 각도 성분 16개의 결과를 나타낸다.

그림 1의 LF 이미지를 살펴보면 각각의 KNU, IPOD 이미지가 뷰별로 상하좌우로 이동하고 있음을 알 수 있다. 이러한 현상은 그림 1의 왼쪽 모식도를 통해 이해할 수 있는데, 먼저 KNU 객체의 경우 당초에 설정하였던 8 cm 지점에서는 깔끔하게 나타나지만, CGH와의 거리가 멀어질수록 안개처럼 뿌연 상이 더 넓어지는 것을 확인할 수 있다. 먼저, CGH로부터 8 cm 떨어진 지점에서는 KNU 글자가 있는 부분에 픽셀 사이즈로부터 제한되는 최대 회절각 이내의 모든 각도 성분이 포함되어있기에 깔끔한 상이 재생되는 것으로 볼 수 있다. 그러나 CGH로부터 8 cm 보다 더 먼 지점에서는 기존 KNU 글자영역에 모여있던 각도 성분들이 z 축 방향으로 진행함에 따라 분산하게 되어 좁은 범위의 각도 성분만을 가진 KNU 상이 마구 흩뿌려진 것으로 이해할 수 있다. 마찬가지로 IPOD 객체의 경우에도 12 cm 지점에서 모여야 할 IPOD 상이 10 cm 지점에서는 덜 모인 채로 흩뿌려져 있는 것으로 볼 수 있다. CGH로부터 10 cm 떨어진 거리에서 획득한 LF 이미지는 결국 좁은 범위의 각도 성분만으로 이루어진 불완전한 상을 좁은 각도 범위로 구분하여 출력한 결과에 해당하며, 각 객체들은 제한된 각도 성분으로 인해 기존 상과 이미지 출력 위치 간 거리 차이와 각도 성분의 크기에 비례하여 LF 이미지 뷰 별로 이동하게 된다.

CGH로부터 재생한 다중 평면 3차원 이미지로부터 LF 이미지를 출력하는 과정 모식도와 일부 LF 이미지 결과Fig. 1. A schematic diagram of the process of reproducing an LF image from a multi-plane 3D image generated from CGH and part of the LF image results

또한 이미지의 변환과정 중 홀로그램 이미지로부터 LF 이미지 뷰로 변환 시 Hogel정보로 분할된 각주파수 구획들은 영상 내 객체의 크기와 위치를 고려하여 픽셀 크기에 의해 규정되는 최대 회절각 보다 더 좁은 범위로 설정되어야 한다. 이 과정에서 고각도의 각주파수 성분 유실로 인하여, 영상의 품질 저하가 발생하게 된다. 만약 LF 이미지를 생성하는 각도 성분 범위를 단순히 최대 회절각에 맞추어 설정하는 경우에는 고각도의 LF 이미지에서는 객체의 일부 정보가 유실되게 되고, 그에 따른 객체 탐지가 불가능해지기에 최대 회절각 이내에서 객체 전체가 온전히 재생되는 최대 범위의 각주파수 성분으로 LF이미지의 뷰 추출 범위를 보다 좁게 추려야 한다. 본 연구결과에서 사용한 샘플이미지 및 재생 조건의 경우 약 2.1도로 계산되었다.

2. YOLOv5 알고리즘을 활용한 LF 이미지 내의 객체 검출

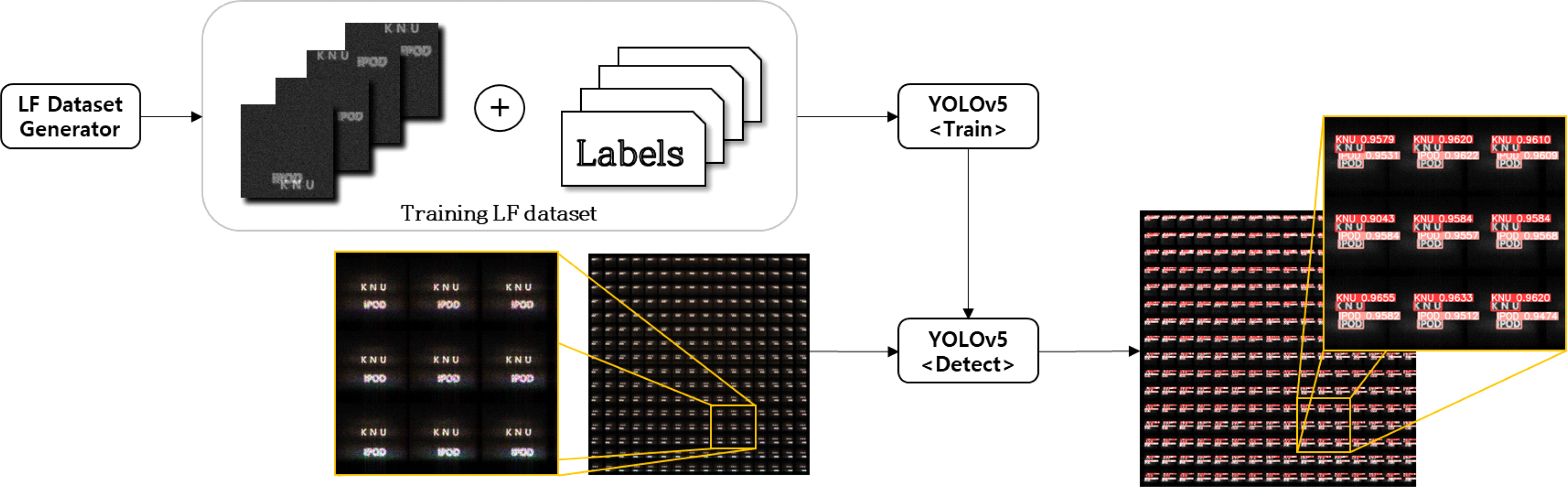

출력한 LF 이미지는 그림 2에서 보이는 바와 같이 다양한 관점에서 관찰되는 많은 수의 이미지 집합으로 구성되어 이를 사람이 하나하나 분석하는 것은 매우 비효율적이다. 본 연구에서는 이러한 문제를 해결하기 위해 LF 이미지 내의 객체 검출에 1-Stage detector인 YOLOv5l 모델을 사용하였다. 객체 검출은 단순히 이미지의 클래스를 구분해 주는 Classification 알고리즘과는 달리, 검출하고자 하는 객체의 바운딩 박스를 출력하여 객체의 좌표, 크기 그리고 클래스를 알려주는 알고리즘이다. 이러한 객체 검출 모델은 크게 1-Stage detector와 2-Stage detector로 나뉜다. 2-Stage detector는 바운딩 박스의 localization문제와 classification문제를 순차적으로 해결하는 것으로 RCNN(Girshick et al.)[14], ResNet(He et al.)[15] 등이 여기에 해당한다. 그에 반해 1-Stage detector는 localization과 classification이 동시에 이루어진다. YOLO(Redmon et al)[16], SSD(Liu et al.)[17] 등이 여기에 해당된다. 2-Stage detector는 검출 정확도가 우수하다는 장점이 있으나 추론 및 학습 시간이 느리다는 단점이 있고 1-Stage detector는 추론 및 학습 시간이 빠르다는 장점이 있지만 검출 정확도가 낮다는 단점이 있다.

Object의 위치와 Depth를 각각의 Label과 함께 무작위로 생성한 후 YOLOv5에 학습시켜 LF 이미지에서 KNU와 IPOD 객체를 검출하는 모식도Fig. 2. A schematic diagram of detecting KNU and IPOD objects in LF images with YOLOv5 trained after randomly generating the object position and depth along with each label

YOLO(You Only Look Once)는 실시간에 가까운 객체 검출로 2016년에 C언어 기반으로 처음 공개되어 2017년에는 개선된 YOLOv2가, 이후 2018년에 YOLOv3가 공개되었다. 이때부터 2-Stage detector 방식의 R-CNN계열 모델의 검출 정확도를 거의 따라잡았다. 이후 2020년에 Tensor-Flow 기반의 YOLOv4에 잇따라 Pytorch Framwork로 작성된 YOLOv5가 공개되었다. YOLOv5는 모델의 크기에 따라 nano, small, medium, large, xlarge으로 여러 가지 버전이 제공된다. n(nano) 모델이 가장 빠르지만 정확도는 가장 낮으며 반대로 x(xlarge) 모델은 가장 느리지만 정확도가 가장 높다.

YOLOv5의 구조는 backbone, Neck, Head 크게 3개의 계층으로 구분된다. backbone은 여러 층의 합성곱 레이어와 풀링 레이어들을 거치며 입력한 이미지 내에서 다양한 사이즈의 특징을 추출한다. Neck에서는 PANnet 을 통해 backbone에서 추출된 다양한 크기의 특징을 융합하여 성능을 높인다. Head는 합성곱 레이어를 통해 Neck에서 나온 특징을 출력으로 나타내주는 계층이다. 본 알고리즘을 적용하여 출력되는 결과물은 탐지한 객체의 중심좌표, 폭, 높이 파라미터와 객체의 신뢰도이다. 본 연구에서 제안하는 모델이 적용되는 LF 이미지의 경우 각 하위 이미지 당 256⨯256 해상도를 가지는 16⨯16 개 이미지의 집합이기 때문에 총 4096⨯4096 해상도의 거대한 이미지가 입력된다. 따라서 비교적 거대한 이미지를 처리할 수 있는 Large 모델인 YOLOv5l을 적용하였다. YOLOv5는 다양한 크기의 객체를 검출할 수 있도록 앵커 박스가 설정되어 있어 LF 이미지의 특성을 고려하여 앵커 박스의 크기를 한 view 이하로 설계하면 최적화할 수 있다.

우리는 YOLOv5l 알고리즘으로 객체 검출하기 앞서 먼저 그림 2와 같이 출력한 LF 이미지의 한 뷰에서 나타나는 KNU, IPOD 객체를 앵커 박스와 같은 모양으로 추출하였다. 그리고 이에 대해 0.8에서 1.2배 사이 수준으로 크기를 재조정하고 최대 신호 대비 30% 수준 이내의 크기를 가지는 랜덤한 잡음을 입력한 뒤, 256⨯256 해상도의 검은색 평면 이미지 상에서 랜덤한 지점에 위치시킨 1000개의 학습 데이터를 생성하였다. YOLOv5l는 이를 학습하여 LF 이미지 내에서 KNU와 IPOD 객체를 탐지할 수 있도록 설정되었고, 우리는 여기에 도출한 LF 이미지를 입력하여 뷰별로 객체들의 위치 정보를 획득하였다.

3. LF 이미지 객체 움직임 분석

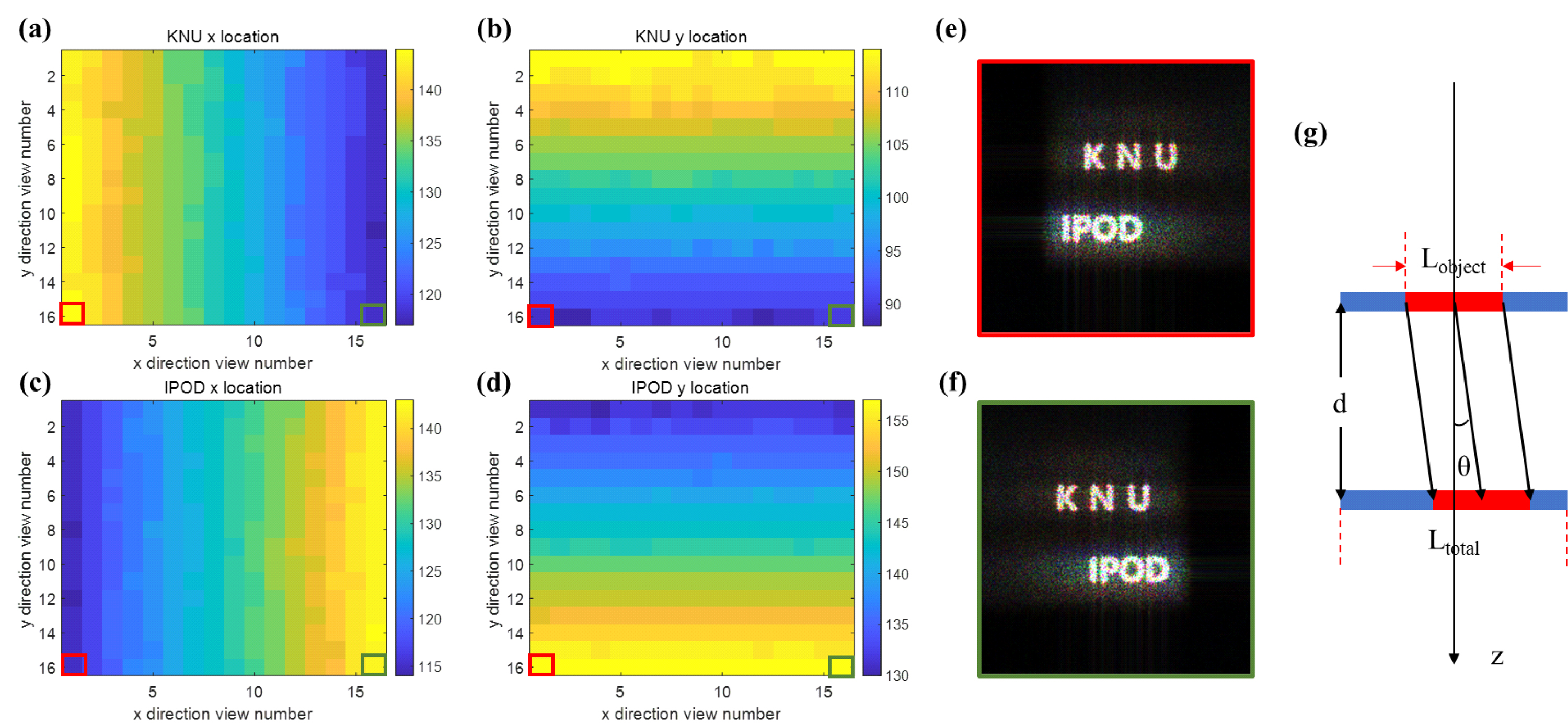

그림 3(a)-(d)는 검출한 LF 이미지 내에서 각각 KNU와 IPOD 객체들이 개별 LF 이미지 뷰에서 가지는 x, y축 방향으로의 위치 정보를 나타낸다. 그림에서 x축 방향 뷰 넘버가 16인 경우 약 2°를 중심각으로 하는 관점에서의 뷰이고 1에 해당하는 지점은 약 –2°를 중심각으로 하는 관점에서의 뷰에 해당한다. y축 뷰 넘버는 이와 반대로 1에서 약 –2°, 16에서 약 2°를 중심각으로 하는 관점 뷰를 의미한다. 또 이미지 내의 좌표는 왼쪽 위에서부터 x, y 좌표값이 1부터 시작하는 값을 취한다. 결과적으로 그림 3을 통해 이전 그림에서 보인 바와 같이 각 객체들이 각도 관점에 따라 선형적으로 변해감을 확인할 수 있다.

해당 자료에서 LF 이미지를 검출한 10 cm 지점보다 보다 SLM 방향으로 2 cm 가까이 있는 KNU 객체는 x축 관점 중심각도가 증가함에 따라 뷰 내 객체의 x 좌표값이 왼쪽으로 이동한다. 이와는 반대로 당초 이미지가 2 cm 더 멀어진 IPOD 객체는 x축 관점 중심각도가 증가함에 따라 뷰 내 객체의 x 좌표값이 오른쪽으로 이동한다. 또한 각 객체의 뷰내 y 좌표값은 x축 관점 중심각도와는 독립적인 결과가 나타난다. 마찬가지로 y축 관점 중심각도의 변화에 대해서는 뷰 내에서 각 객체의 y 좌표값이 서로 반대되는 방향으로 이동하고, x 좌표값은 그에 독립적인 경향을 보인다. 그림 3(e), 3(f)는 각각 x, y 뷰 넘버가 (16, 1), (16, 16) 인 경우의 LF 관점 뷰에 해당하며 앞선 그림에서 나타난 정보와 일치하게 객체들이 움직임을 보여준다.

각 객체의 위치정보 변화 크기는 아래의 식 (1)로부터 유추할 수 있다. 식 (1)에서 d는 객체의 기존 상 위치와 LF 이미지를 검출한 위치 간 거리 차이이고, θ는 LF를 검출한 뷰의 중심각도에 해당한다. 그리고 pmoving은 LF 뷰 내에서 객체가 중심위치로부터 이동한 픽셀 수를 의미하는데 우리는 특정 중심 각도 뷰에서의 위치와 이에 대칭되는 반대 방향으로의 해당 각도 뷰에서의 위치 변화 간 차이를 구하고 그 절반 값을 취하는 방식으로 결정하였다. ptotal은 LF 이미지의 개별 뷰의 한쪽 방향 픽셀 개수이며, Ltotal은 재생하고자 하는 상 이미지의 한쪽 방향 길이이다. 이 경우 ptotal은 256개, Ltotal은 1.457 cm 이다. 이 같은 식의 유도는 그림 3(g)에서 나타나는 간단한 삼각비 관계로부터 유도할 수 있다.

우리는 그림 3(a)-(d) 로부터 약 2°의 중심각을 가지는 LF 이미지 뷰에서 각 객체의 좌표 값이 약 12 픽셀 수준으로 변화함을 확인하였고, 이를 LF 이미지 검출 지점과 상의 본래 위치간 거리인 2 cm와 함께 식 (1)에 대입한 결과 좌변에서는 약 0.6984 mm, 우변에서는 약 0.6911 mm 의 값이 도출됨을 확인하여 제안한 식의 유효성을 확인할 수 있었다. 본 결과에서 나타나는 약간의 오차는 파장별 각도 성분 범위 설정에서 나타나는 약간의 차이와 LF 이미지 뷰의 낮은 해상도 여건에 의해 발생하는 것으로 추정된다.

(a)-(d) 샘플 CGH를 10 cm 위치에서 재생한 상으로부터 얻은 LF 이미지상에서 뷰 별로 KNU와 IPOD 객체가 가지는 x, y축 좌표 자료. (e), (f) 뷰 넘버 (1, 16), (16, 16)에서의 개별 뷰 LF 이미지. (g) LF 이미지에서 객체가 각도 뷰별로 이동하는 양상을 설명하는 모식도Fig. 3. (a)-(d) The x, y-axis coordinate data of the KNU and IPOD objects for each view on the LF image obtained from the image reproduced at the 10 cm position of the sample CGH. (e), (f) Individual view LF images at view numbers (1, 16), (16, 16). (g) A schematic diagram explaining how an object moves by angle view in an LF image

Ⅲ. CGH 영상의 LF 변환과 각도 성분별 객체 이동 분석

1. LF 이미지내 객체의 위치 변화를 통한 초점거리 조절 시뮬레이션

이제까지의 연구 결과는 다중 평면 3차원 이미지를 구성하는 객체들이 이루는 초점 거리와 LF 이미지를 검출한 지점과의 차이에 기인하여 LF 이미지 내에서 객체들이 관점 뷰에 따라 위치하는 좌표값이 바뀐다는 사실을 나타낸다. 이러한 사실은 LF 이미지를 구성하는 객체들의 좌표값 변화 양상을 조절함으로써 객체가 위치하는 초점 거리를 조절하는 데에도 활용될 수 있다.

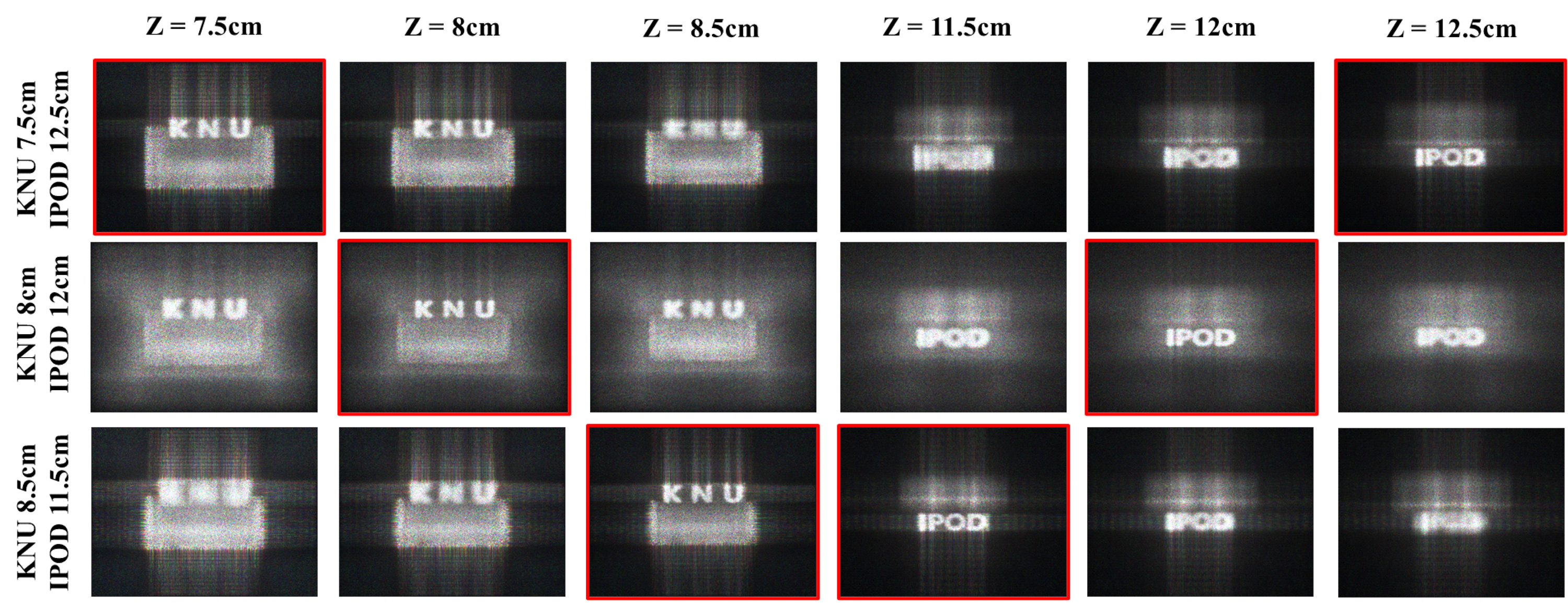

먼저 우리는 그림 3에서의 객체별 위치 정보를 평균 내어 중심위치를 정하고 좌표 변화 크기를 0.75배와 1.25배로 변화시킨 객체 위치 정보를 산정한 뒤, YOLOv5에서 활용된 앵커 박스 내의 객체 이미지를 해당 좌표값에 위치시킴으로써 새로운 초점 거리를 가지는 LF 이미지를 생성하였다. 제안한 식 (1)에 따르면 각각의 새로운 LF 이미지들은 기존 LF 이미지를 검출하는데 활용된 10 cm 지점으로부터 각 2 cm 씩 떨어진 기존의 상황에서 각각 1.5 cm 와 2.5 cm 떨어진 8.5 cm, 11.5 cm 그리고 7.5 cm, 12.5 cm 지점으로 객체들이 이동한 상황에 해당한다.

뷰별 객체 위치를 조정한 LF 이미지는 랜덤한 위상을 씌운 후 개별적으로 푸리에 변환을 취한 뒤 뷰의 중심각도 성분범위를 기준으로 재배치하고 이를 전체적으로 역푸리에 변환을 취해줌으로써 다시 10 cm 에 위치하는 흐릿한 상을 만들게 된다. 그리고 이 흐린 상에 대해 ASM 방식의 CGH 연산을 수행하여 최종적으로 객체의 초점 거리가 재배치된 CGH를 얻을 수 있다. 그림 4는 이러한 과정을 통해 얻은 세 가지 CGH들을 7.5 cm, 8 cm, 8.5 cm, 11.5 cm, 12 cm, 12.5 cm 에서 재생한 시뮬레이션 결과를 보여준다.

샘플 LF 이미지를 제안한 방식을 적용하여 10 cm 위치와 초점 위치 간 거리를 1.25, 1.0, 0.75 배로 조정한 뒤 각 위치에서 재생한 시뮬레이션 상 결과Fig. 4. Simulation results reproduced at each position after adjusting the distance between the 10 cm position and the focus position by 1.25, 1.0, and 0.75 times by applying the proposed method to the sample LF image

그림에서 위에서부터 아래로 세 개의 행들은 LF 이미지 내에서 각 객체들의 뷰별 이동 범위를 0.75, 1, 1.25 배로 조정하였음을 의미하고, 각각의 열 위쪽에 표기된 위치는 상을 재생한 위치를 의미한다. 전체 그림을 구성하는 18개의 하위 그림들 중 붉은색으로 테두리 쳐진 그림들이 의도한 초점 거리에서 객체들이 재생된 결과에 해당하며 동일한 행과 열의 같은 객체를 비교해보았을 때 가장 우수한 품질의 상이 나타난다. 이는 제안한 초점 거리 변환 방식의 유효성을 보여준다.

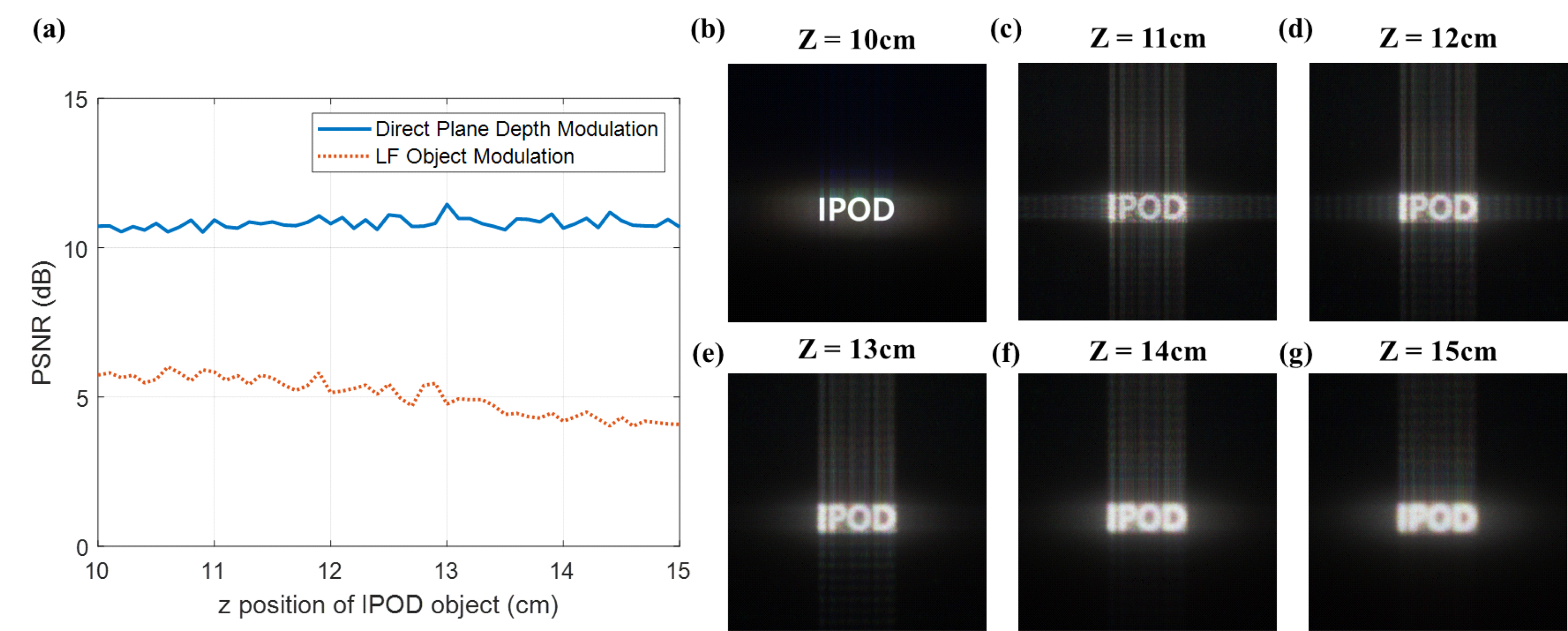

2. LF 변환을 통한 초점 거리 조절에 따른 PSNR 성능 평가

제안한 초점 거리 조절 방식에 대한 정확한 성능 평가를 위해 우리는 IPOD 객체만으로 구성된 단일 평면 이미지의 초점을 조절하고 이로부터 재생되는 시뮬레이션 상 결과와 원본 이미지 간의 최대 신호 대 잡음비 (Peak-Signal-to-noise ratio, PSNR)를 측정하였다. 이를 위해 먼저 10 cm 거리에 재생된 IPOD상을 LF 이미지로 변환하고 뷰별 객체의 위치 이동을 반영하여 초점 거리를 10 cm에서 15 cm까지 조절한 CGH를 생성하였다. 해당 과정에서 초기 LF는 본래 식 (1)에 따라 d 파라미터가 0이 되므로 뷰별 객체의 위치 이동이 없으나 초점 거리를 늘려감에 따라 이동 거리가 커지게 되어 최종적으로 15 cm로 초점 거리를 조절한 경우에는 상하좌우의 마지막 뷰에서 약 30 픽셀 수준의 이동이 발생하게 된다.

그림 5(a)는 제안한 방식으로 초점 거리를 조절한 CGH가 각 초점 거리에서 재생하는 상과 원본 이미지 간의 PSNR 수치와 함께 실제로 원본 객체의 위치를 조절하여 직접적으로 계산한 CGH가 재생하는 상과 원본 이미지 간의 PSNR 수치 그래프를 보여준다. 먼저 직접적으로 계산한 CGH가 재생하는 상은 그림 5(b)에 제시되어 있으며, 초점 거리를 늘리더라도 영상의 품질이 떨어지지 않음을 PSNR 그래프를 통해 알 수 있다. 그러나 제안한 방식으로 초점 거리를 조절하는 경우에는 초점 거리가 멀어질수록 영상의 품질이 다소 떨어짐을 그림 5(a)와 5(c)-5(g)를 통해 확인할 수 있다. 이 같은 현상은 LF 이미지 획득 지점과 객체별 초점 위치 간 거리가 멀어지는 상황에서 각 뷰의 이미지를 채취하는 주파수 성분의 간격이 깔끔한 상의 형성에 필요한 수준 보다 커짐에 따라 자연스럽게 흐릿해지는 객체 상의 변화를 새로운 LF 이미지 형성과정에 반영해주지 못함에 의해 발생하는 것으로 분석된다.

또한 제안한 방식으로 초점 거리를 조절한 경우의 시뮬레이션 결과에서는 IPOD 상의 상하좌우로 뻗어나가는 직선 다발 형태의 자취가 나타나는데, 이는 새롭게 형성한 LF 이미지를 푸리에 도메인으로 변환하는 과정에서 각각의 뷰로부터 비슷한 형태의 주파수 성분분포가 형성되고 이 결과가 격자와 같이 배치됨으로써 발생하는 것으로 해석된다. 이 같은 해석을 통해 LF 이미지 중 뷰별로 이미지 변화가 큰 원거리 초점 거리 조절 과정에서 격자 형태의 배치가 흐트러지는 정도가 커짐에 따라 근거리 초점 거리 결과보다 더 옅은 직선 다발 자취가 나타나는 것으로 이해할 수 있다. 결과적으로 제안한 방식으로 조절 가능한 초점 거리 범위는 그림 5(a)에서 PSNR 수치가 5dB 이하 수준으로 떨어지기 시작하는 3 cm 까지가 최대인 것으로 분석된다. 시뮬레이션으로 얻은 상 결과들 역시 약 3 cm의 결과부터 두드러지게 흐릿해지는 현상이 나타난다.

(a) IPOD 객체만으로 이루어진 단일 평면 이미지에 대해 직접 상의 위치를 조절하여 얻은 CGH와 10cm 초점 거리의 상을 제안한 방식으로 조절하여 얻은 CGH로부터 재생되는 상들과 원본 이미지 간의 PSNR 그래프. (b) 10 cm 거리에 IPOD 이미지를 위치시키고 얻은 CGH로부터 재생되는 10 cm 지점에서의 시뮬레이션 상. (c) - (g) (b)의 결과로부터 LF 이미지를 추출하고 제안한 방식으로 초점 거리를 조절한 CGH로부터 조절한 초점 거리에서 재생되는 시뮬레이션 상Fig 5. (a) A PSNR graph between the original image and the images reproduced from the CGH obtained by directly adjusting the image position of a single flat image consisting of only IPOD objects and the CGH obtained by adjusting the image at 10 cm focal length in the proposed method. (b) Simulation image at the 10 cm point reproduced from the CGH obtained by positioning the IPOD image at a distance of 10 cm. (c) - (g) From the result of (b), the LF image was obtained and the simulation image reproduced at the corresponding distance from the CGH with the focal length adjusted in the proposed method.

Ⅳ. 실험 결과

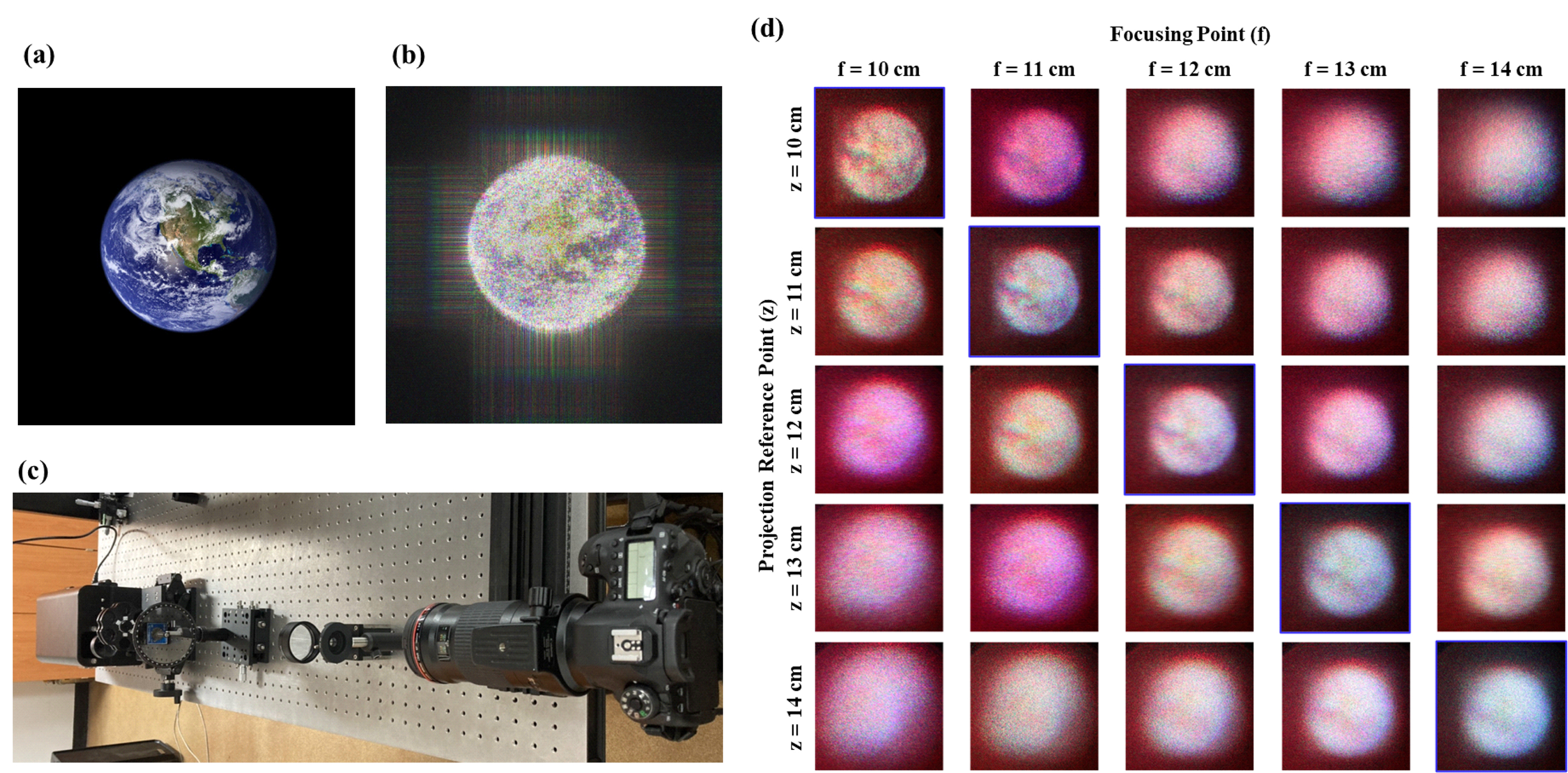

우리는 제안한 방식의 실험적 검증을 위해 그림 6(a)에 제시된 새로운 샘플 이미지로부터 10 cm 거리에서 CGH를 계산하고 이에 대해 LF 이미지 변환과 객체 탐지 및 위치 조정을 수행하여 10 cm에서 14 cm 범위까지 1 cm 간격으로 초점 거리를 제어한 CGH를 생성하였다. 이들 중 10 cm 위치로 초점 거리가 제어된 CGH가 10 cm 거리에서 재생하는 상이 그림 6(b)에 해당한다. 그림 6(c)는 실제로 CGH를 재생한 결과를 측정하기 위한 실험 셋업이며 직선 형태로 배치되어 CGH가 입력되는 SLM이 –4 cm 부터 0 cm 지점에, 4-focus 시스템 구성을 위한 30 cm 초점의 렌즈가 40, 100 cm 지점에 각각 하나씩, SLM에서 출력되는 DC 성분을 감소시키기 위한 ND 필터가 70 cm 지점에, 마지막으로 SLM의 반대 방향으로 130 cm 지점을 초점으로 잡고 있는 카메라가 자리하게끔 설계되었다. 본 실험에서 MAY 사의 SLM (PEONY 62A) 장비를 사용하였다.

그림 6(d)는 준비한 CGH와 실험 셋업을 통해 10 cm 에서 14 cm 범위에서 나타나는 상 결과를 측정한 자료이다. 자료에서 가로축은 제안한 방식으로 조절한 초점 거리, 세로축은 관측한 지점에 해당한다. 제시된 자료는 조절한 초점 거리 별로 가장 우수한 품질의 상이 해당 초점 거리에서 관측되어 우리가 제안한 초점 거리 조절 방식의 타당성을 뒷받침한다. 또한 PSNR 분석을 통해 예상한 바와 같이 약 3 cm 이상의 수준으로 초점 거리를 조절하는 경우에는 전체적인 영상의 품질이 크게 하락함을 확인할 수 있다. 본 그림은 실제 샘플 이미지 원본과 비교하여 전체적으로 붉은색이 다소 많이 비치는 것을 확인할 수 있다. 이 같은 현상은 LF 이미지 변환 및 조절에서 활용하는 관측 각도 범위를 넓게 하고자 별도의 off-axis 각도를 부여하지 않고 CGH를 계산하여 DC 빛과 상이 겹치게 되고, 푸른색과 녹색 빛 성분은 상을 구성하는 과정에 할애되어 남은 DC 빛에 붉은 성분이 많이 포함된 상황이 결합되어 나타나는 현상으로 분석된다.

(a) 실험에 사용된 샘플 이미지 원본. (b) (a)의 이미지를 10 cm 거리에서 재생하는 CGH를 계산하고 CGH-LF-CGH 이미지로의 변환을 거친 뒤에 재생한 시뮬레이션 상 결과. (c) –4 ~ 0 cm 위치에 SLM, 10 cm 위치와 70 cm 위치에 30 cm 초점 길이의 렌즈, 40 cm 위치에 ND 필터, 80 ~ 84 cm 위치에 초점을 맞춘 카메라가 일렬로 배치된 실험 셋업. (d) 제안한 방식으로 초점 거리를 10 cm에서 14 cm까지 조절한 CGH를 실제로 재생하여 촬영한 결과Fig. 6. (a) The original sample image used in the experiment. (b) Simulation image reproduced by calculating the CGH of the image in (a) at a distance of 10 cm and shifting the focal length by 0 cm in the proposed method. (c) Experimental setup with SLM at –4 to 0 cm, 30 cm focal length lenses at 10 and 70 cm, ND filters at 40 cm, and camera focus at 80 to 84 cm

Ⅴ. 결 론

본 논문은 다중 평면으로 구성된 3차원 이미지를 재생하는 CGH를 LF 이미지로 변환하고 각 평면별로 위치하는 객체를 YOLOv5 알고리즘으로 탐지한 뒤, 이를 재배치한 LF 이미지를 생성하고, 이를 다시 역변환하여 초점 거리가 변환된 3차원 이미지를 재생하는 CGH를 생성하는 기술을 제시한다. 제안하는 기술에 사용된 YOLOv5는 LF 이미지의 단일 뷰에서 설정 가능한 객체를 기반으로 다량의 유사한 학습 데이터를 활용해 정확성을 높일 수 있음을 확인하였고, 이를 통해 검출한 객체의 뷰별 이동양상을 정량적으로 분석하였으며, 최종적으로 뷰별 이동양상에 변화를 주어 다중 평면 3차원 이미지의 초점 거리를 조절할 수 있음을 시뮬레이션 이미지와 PSNR 분석 및 실험 관측을 통해 증명하였다. 또한 제안하는 기술은 ASM 방식 기반으로 형성된 10 cm 지점의 상에 대해 영상의 품질을 크게 훼손하지 않는 한도 내에서 최대 3 cm 범위까지 초점 거리를 조절할 수 있는 것으로 확인되었다.

본 연구는 이산적인 깊이 분포를 가지는 객체에 적용되어 평면별로 그 깊이 정보를 제어하는 결과를 보여주었다. 그러나 연속적인 깊이 분포를 가지는 객체에 대해서는 추출하는 LF 이미지의 각도 범위와 해상도 조건을 늘려주더라도 이동하는 픽셀의 범위가 매우 작아지게 되어 정확한 적용이 어렵다는 문제가 발생한다. 이 같은 한계는 우리가 객체의 깊이 정보 변화에 따라 나타나는 LF 이미지 내의 변화로써 단순한 객체의 평행이동만 고려하였기에 발생한 것으로 추측되며, 향후 차별화된 변화 요소로써 객체 내부 국소 범위의 RGB 스케일과 위상 정보의 변화 등에 대한 분석이 추가된다면 더 미세한 객체의 깊이 분석 및 조절이 가능해지게 되어, 연속적인 깊이 분포를 가지는 객체에 대한 깊이 정보 제어에 관련한 연구로 발전할 수 있을 것으로 기대한다.

Notes

References

-

Ruffato, G., Rossi, R., Massari, M., Mafakheri, E., Capaldo, P., Romanato, F., Design, fabrication and characterization of Computer Generated Holograms for anti-counterfeiting applications using OAM beams as light decoders, Sci. Rep., (2017, Dec), 7(18011).

[https://doi.org/10.1038/s41598-017-18147-7]

-

Yang, Y., Li, Q., Wang, G. P., Design and fabrication of diverse metamaterial structures by holographic lithography, Opt. Express, (2008, Jul), 16(15), p11275-11280.

[https://doi.org/10.1364/OE.16.011275]

-

Gabor, D., Microscopy by reconstructed wave-fronts, Proc. R. Soc. Lond., (1949, Jul), 197(1051), p11275-11487.

[https://doi.org/10.1098/rspa.1949.0075]

-

Pi, D., Liu, J., Wang, Y., Review of computer-generated hologram algorithms for color dynamic holographic three-dimensional display, Light Sci. Appl., (2022, Jul), 11(231).

[https://doi.org/10.1038/s41377-022-00916-3]

-

Sahin, E., Stoykova, E., Makinen, J., Gotchev, A., Computer-Generated Holograms for 3D Imaging: A Survey, ACM Comput. Surv., (2021, Mar), 53(2), p1-35.

[https://doi.org/10.1145/3378444]

-

Matsushima, K., Computer-generated holograms for three dimensional surface objects with shade and texture, Appl. Opt, (2005, Aug), 44, p4607-4614.

[https://doi.org/10.1364/AO.44.004607]

-

Rivenson, Y., Stern, A., Javidi, B., Compressive Fresnel Holography, J. Display Technol., (2010), 6(10), p506-509.

[https://doi.org/10.1109/JDT.2010.2042276]

-

Peng, Y., Suyeon, C., Padmanaban, N., Wetzstein, G., Neural holography with camera-in-the-loop training, ACM Trans. Graph., (2020, Dec), 44(6), p1-14.

[https://doi.org/10.1145/3414685.3417802]

-

Chen, C., Lee, B., Li, N.-N., Chae, M., Wang, D., Wang, Q.-H., Lee, B., Multi-depth hologram generation using stochastic gradient descent algorithm with complex loss function, Opt. Express, (2021, Apr), 29(10), p15089-15103.

[https://doi.org/10.1364/OE.425077]

-

Huang, Z., Cao, L., Bicubic interpolation and extrapolation iteration method for high resolution digital holographic reconstruction, Opt. Lasers Eng., (2020, Jul), 130.

[https://doi.org/10.1016/j.optlaseng.2020.106090]

-

Zhao, J., Gao, Z., Niu, Y., Deng, L., A method for improving the resolution of single-frame off-axis holograms based on extrapolation iterations and Kronecker interpolation, Measurement, (2022, Aug), 199.

[https://doi.org/10.1016/j.measurement.2022.111531]

-

Shimobaba, T., Makowski, M., Kakue, T., Oikawa, M., Okada, N., Endo, Y., Hirayama, R., Ito, T., Lensless zoomable holographic projection using scaled Fresnel diffraction, Opt. Express, (2013, Oct), 21(21), p25285-25290.

[https://doi.org/10.1364/OE.21.025285]

-

Park, D.-Y., Park, J.-H., Generation of distortion-free scaled holograms using light field data conversion, Opt. Express, (2021, Jan), 29(1), p487-508.

[https://doi.org/10.1364/OE.412986]

- Girshick, R., Donahue, J., Darrell, T., Malik, J., Rich feature hierarchies for accurate object detection and semantic segmentation, IEEE Conference on Computer Vision and Pattern Recognition, Ohio, USA, (2014, Jun), p580-587.

- He, K., Zhang, X., Ren, S., Su, J., Deep Residual Learning for Image Recognition, IEEE Conference on Computer Vision and Pattern Recognition, Las Vegas, USA, (2016, Jun), p770-778.

- Redmon, J., Divvala, S., Girshick, R., Farhadi, A., You Only Look Once: Unified, Real-Time Object Detection, IEEE Conference on Computer Vision and Pattern Recognition, Las Vegas, USA, (2016, Jun), p779-788.

- Liu, W., Anguelov, D., Erhan, D., Szegedy, C., Reed, S., Fu, C.-Y., Berg, A. C., SSD: Single Shot MultiBox Detector, European Conference on Computer Vision, Amsterdam, Netherlands, (2016, Oct), p21-37.

배 영 규

- 2019년 2월 : 경북대학교 전자공학부 공학사

- 2019년 3월 ~ 현재 : 경북대학교 전자전기공학부 석박사통합과정

- 주관심분야 : Metasurface, Nanophotonics, Digital Holography

신 동 하

- 2020년 2월 ~ 현재 : 경북대학교 전자공학부 학사과정

- 주관심분야 : Digital Hologram, Wave Optics, Deep Learning, Visual Computing

이 승 열

- 2014년 2월 : 서울대학교 전기컴퓨터공학부 공학박사

- 2014년 3월 ~ 2015년 11월 : 서울대학교 광공학연구실 Post Doc.

- 2015년 12월 ~ 2016년 8월 : 한국전자통신연구원 ICT소재부품연구소 연구원

- 2016년 9월 ~ 2021년 9월 : 경북대학교 전자공학부 조교수

- 2021년 10월 ~ 현재 : 경북대학교 전자공학부 부교수

- 주관심분야 : Digital Hologram, Spatial Light Modulator, Nanophotonics, Metasurfaces