딥러닝 기반 시설재배 생산량 예측 연구

Copyright © 2023 Korean Institute of Broadcast and Media Engineers. All rights reserved.

“This is an Open-Access article distributed under the terms of the Creative Commons BY-NC-ND (http://creativecommons.org/licenses/by-nc-nd/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited and not altered.”

초록

스마트농업은 데이터 기반 의사결정을 통해 노동력과 자원을 최적화하고 생산 효율성을 높인다. 실시간으로 수집된 데이터에 기반하여 생산량을 예측하는 분야는 생산성 향상 및 자동화에 중요한 기술이다. 본 논문에서는 시설원예 스마트팜중 파프리카와 오이의 환경 정보와 생육 정보를 활용하여 생산량 예측을 위해 딥러닝 모델을 사용한다. 시계열 예측에 주로 사용되는 MLP(Multi Layer Perceptron), RNN(Recurrent Neural Networks), LSTM(Long Short-Term Memory models), GRU(Gated Recurrent Unit), TCN (Temporal Convolution Network), Transformer 등을 적용하여 룩백 창의 크기와 예측 데이터 크기를 다양하게 조절하여 모델에 따른 예측 성능의 결과를 분석하였다. 스마트팜 데이터 마트의 데이터를 사용하였으며, 각 모델마다 룩백 창의 크기와 예측할 데이터의 크기의 관계를 조사하였다.

Abstract

Smart agriculture optimizes labor and resources and increases production efficiency through data-driven decision-making. The field of predicting production based on data collected in real time is an important technology for productivity improvement and automation. In this paper, a deep learning model for forecasting production is used using environmental and growth information of paprika and cucumber among facility horticulture smart farms. By applying MLP(Multi Layer Perceptron), RNN(Recurrent Neural Networks), LSTM(Long Short-Term Memory models), GRU(Gated Recurrent Unit), TCN(Temporal Convolution Network), Transformer, etc., which are mainly used for time-series forecasting, the size of the look-back window and the forecasted data size Various adjustments were made to analyze the results of forecasting performance according to the model. The data of the smartfarm datamart was used, and the relationship between the size of the look-back window and the size of the forecasted to be predicted was investigated for each model.

Keywords:

Paprika, Cucumber, Time-series forecasting, forecasting production, Look-back windowⅠ. 서 론

4차 산업혁명과 함께 농작업의 무인화/지능화로 노동력, 지식, 경험 등을 데이터가 대신하는 스마트 농업이 부상하고 있으며, 국내외 스마트 농업 시장은 지속적으로 확대되고있다. 인공지능 기술을 활용한 생육관리 자동화 솔루션의 시장에서 생산자 중심의 생육관리에서 농업 전 과정의 의사결정에 영향을 주는 솔루션의 역할이 증가하고 있다. 스마트팜은 PC 또는 모바일을 통해 온실의 온·습도, 이산화탄소 등을 모니터링하고 창문 개폐, 영양분 공급 등을 원격자동으로 제어하여 재배하는 작물의 최적 생육환경을 유지 관리할 수 있는 농장을 의미한다[1]. 본 논문에서는 시설원예 스마트팜중 파프리카와 오이의 환경 정보와 생육 정보를 활용하여 생산량을 예측한다. 생육정보란 작물이 파종에서 수확까지 성장하는 동안 측정 가능하며, 그 결과가 유용하게 활용 가능한 항목들을 말한다[1]. 환경 정보와 생육 정보는 시계열 데이터로 구성되어 있으며, 시계열 데이터를 분석하여 미래를 예측하는 것은 금융, 기후, 농업, 의료, 교통 등 다양한 분야에서 활발히 연구되었다. 전통적인 방법으로 ARIMA(Auto-Regressive Integrated Moving Average), VAR(Vector Auto-Regressive) 등 계량통계학 기반의 다양한 모델들이 제시되었고, 최근에는 딥러닝 기반의 예측 모델도 활발하게 연구되고 있다. 특히 Transformer는 시계열 데이터를 처리하는 능력이 뛰어나기 때문에 시계열 예측 모델에서 좋은 성능을 보인다[2,3,4,5,6]. 또한 MLP 기반의 모델들이 Transformer 기반의 모델들보다 더좋은 성능을 보이기도 한다[7,8]. 하지만 해당 모델은 대규모 데이터셋을 필요로 한다. 기존 연구로는 convLSTM 모델을 사용한 데이터기반 생육, 생산량 예측에 대한 연구로 스마트 팜 환경에서 발생한 데이터를 사용한 토마토 생산량 및 성장량 예측 방법[9]과 머신러닝 기반으로 하여 스마트팜 딸기 농장에서 수집된 환경 및 생산량 데이터를 분석하여 생산량 예측을 연구방법[10], 시공간 트랜스포머 모델을 적용한 미세먼지 예측 방법[11], 농장의 바이오 센서 데이터를 수집해서 농장에서 재배중인 농작물의 질병을 진단하고, 그해 수확량을 예측하는 수확량 예측 방법[12], 다단계 시계열 예측 접근법의 세 가지 전략을 비교 분석하기 위해 LGBM (Light Gradient Boost Machine), MLP, LSTM[14], GRU[15]를 사용하여 농산물 중장기 가격 예측에 대한 최적의 모형을 제안하는 방법[13]등의 연구가 수행되었다. 기존 연구에서는 미래 예측을 위해 다양한 방법을 적용하였으나 딥러닝 모델과 룩백 창의 크기와 예측 데이터 크기등을 다양하게 적용하였을 경우 성능 결과에 대해 분석하는 연구는 거의 찾아 볼 수 없었으며, 시설 작물중 파프리카와 오이에 대한 연구가 부족하였다. 본 논문에서는 딥러닝 모델인 MLP, RNN, LSTM, GRU, TCN[16], Transformer[17] 등을 적용하여 룩백 창의 크기와 예측 데이터 크기를 다양하게 조절하여 모델에 따른 예측 성능의 결과를 분석하였다. 룩백 창은 과거의 데이터에 대한 시계열 크기를 의미한다. 예측 데이터는 시계열의 정보를 사용하여 해당 한 스텝의 미래 값을 예측하는 방법과 다중 예측을 하는 방법으로 구분된다. 다중 예측일 경우 반복적으로 미래시점을 예측하는 방법과 예측할 크기를 한번에 예측하는 방법으로 구분된다. 본 논문에서는 예측할 크기를 한번에 예측하는 방법을 사용하고, 각 모델마다 룩백 창의 크기와 예측할 데이터의 크기의 관계를 조사하였다.

Ⅱ. 본 론

1. 데이터셋과 전처리

스마트팜 데이터마트[18]의 시설 원예분야 품목으로 토마토, 딸기, 방울토마토, 오이, 파프리카 5종에 대하여 환경 정보, 제어 정보, 생육 정보, 경영 정보등을 제공한다. 하지만 실제 제공되는 데이터는 환경 정보와 생육 정보가 대부분이다. 본 논문에서는 파프리카와 오이의 환경 정보와 생육 정보를 사용하여 생산량을 예측한다. 생산량은 생육정보의 열매수를 예측하도록 하였다. 표 1과 표 2는 파프리카와 오이의 환경 정보와 생육 정보를 나타낸다.

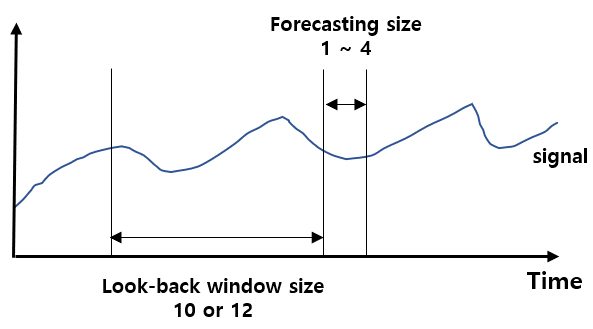

실제 데이터는 항목별로 모두 존재하지 않고, 파프리카의 경우 총 30개의 농가 데이터에서 총 70개의 환경 정보 및 생육 정보를 사용하였고, 오이의 경우 총 19개의 농가 데이터에서 총 38개의 환경 정보 및 생육 정보를 사용하였다. 환경 정보는 시간대별로 저장이 되어있고, 생육 정보는 주단위로 저장되어있어, 환경 정보와 생육 정보의 날짜가 서로 같은 날짜를 기준으로 저장된 데이터의 축출이 필요하다. 시간대별 환경 정보를 주 단위로 변경하기 때문에 해당 기간의 환경 정보의 최소, 최대, 평균값을 데이터셋으로 사용하였다. 파프리카의 경우 환경 정보 데이터는 내부습도, 내부온도를 생육 정보의 기간에 맞게 1주일 간격의 시간대별 최소, 최대, 평균값을 사용하였고, 생육정보의 경우 생장길이(cm), 엽수(개), 엽장(cm), 엽폭(cm), 줄기굵기(mm), 화방높이(cm), 열매수(개)등 7개의 데이터를 사용하였다. 오이의 경우 환경 정보 데이터는 내부CO2, 내부습도, 내부온도를 생육 정보의 기간에 맞게 1주일 간격의 시간대별 최소, 최대, 평균값을 사용하였고, 생육 정보의 경우 초장(cm), 마디수(마디), 엽장(cm), 엽폭(cm), 엽수(개), 줄기직경(mm), 암꽃수(개), 열매수(개)등 8개의 데이터를 사용하였다. 열매수는 누적값으로 적용하였으며, 생산량 예측으로 열매수의 누적값을 사용하였다. 실제 학습을 위해선 환경 정보 데이터와 생육 정보의 시간 정보가 맞고, 예측 모델을 학습하기 위해선 예측 전의 연속적인 시계열 데이터가 필요하다. 본 논문에서는 10주, 12주를 룩백 창의 크기로 사용하였고, 예측할 데이터 크기를 1, 2, 3, 4로 다양하게 지정하였기 때문에 연속적으로 16주 이상의 데이터만 선택하였다. 그림 1은 시계열 신호에 대한 룩백 크기와 예측 크기에 대한 그림을 나타낸다.

파프리카의 경우 선택된 시계열 데이터는 총 44개이고, 오이의 경우 선택된 시계열 데이터는 총 18개이다. 해당 데이터는 minmax 정규화 혹은 표준 편차가 1이 되도록 정규화를 진행한다.

표 3은 룩백 크기와 예측데이터 크기가 다를 경우의 전체 데이터셋의 크기를 나타낸다. 두 종류 모두 데이터수가 충분하지 못하고 오이의 경우 상대적으로 데이터가 더 부족함을 볼 수 있다. 본 논문에서 사용되는 데이터는 시계열의 길이 즉 룩백 창의 크기가 짧고, 데이터셋도 충분히 크지 못한 한계가 존재한다.

2. 생산량 예측 모델

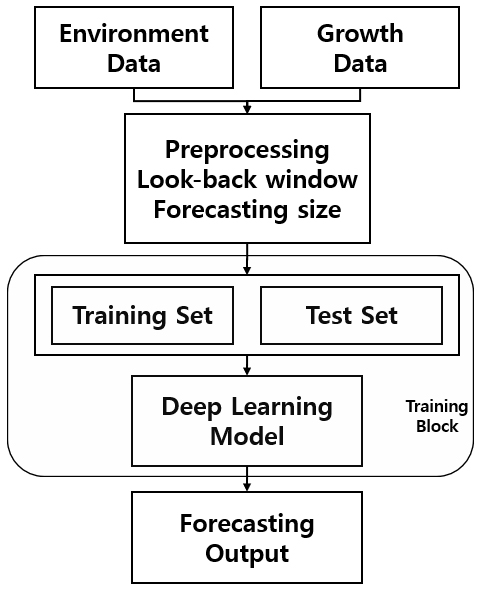

그림 2는 본 논문에서 제시하는 생산량 예측 모델의 블록 다이어그램을 나타낸다.

환경 정보와, 생육 정보가 입력으로 사용되며 전처리 부분에 룩백 창의 크기와 예측 크기에 맞도록 데이터를 전처리한 후 스케일 과정을 거치게 된다. 스케일된 데이터는 학습 데이터와 테스트 데이터로 분리되고, 다양한 딥러닝 모델을 통해서 생산량 예측 학습이 수행된다. 시계열 예측을 위한 딥러닝 모델의 종류는 크게 세 가지로 구분할 수 있다. 첫 번째로 RNN 기반 모델로 가장 고전적인 방법이며, 현재 시점의 데이터가 이전 시점의 데이터의 영향을 받는 시계열 데이터의 특성상 RNN의 동작 방식과 부합한다. 내부적으로 순환이 되는 구조를 지닌 RNN은 이전 시점의 정보를 현재 시점 정보 계산에 활용할 수 있다는 점에서 장점이다. 하지만 깊은 신경망을 학습시키는 과정에서 기울기가 소실되는 문제인 기울기 소실 문제가 있다. 또한 시점간의 간격이 커진다면 현재 시점으로부터 멀리 떨어진 과거 시점 정보의 영향력이 약해지는 장기 의존성 문제가 있다. LSTM은 RNN의 장기 의존성을 해결하기 위해서 셀 상태라는 구조를 만들어서 데이터를 계산하는 위치에 입력, 망각, 출력 게이트 3가지가 추가되어 각 상태 값을 메모리 공간 셀에 저장하고, 데이터를 접하는 게이트 부분을 조정하여 불필요한 연산, 오차 등을 줄여 장기 의존성 문제를 일부 해결하는 모델이다. GRU는 LSTM과 유사하지만 매개변수를 줄인 모델이다. 두 번째는 CNN 기반 모델로 컴퓨터 비전 분야에서 사용된 CNN 기반 모델이 시계열 데이터 모델링에도 사용되었다. CNN에서는 과거와 현재 시점 정보가 시간 불변하다고 가정한다. 시계열 데이터의 장기 의존성 문제에 좋은 성능을 내기 위해 넓은 수용영역(Receptive field) 크기를 해결하기 위해 Dilated 컨볼루션을 사용한 TCN 모델이 있다. 마지막으로 Attention 기반 모델로 RNN, LSTM, GRU 모델과 결합하여 사용하는 방법과, 자연어 처리분야에서 사용되는 Transformer 모델이 있다. 현재, Transformer 기반의 모델들이 RNN 기반의 모델 성능을 뛰어넘고 있으며, Self-Attention을 바탕으로 각 시점 정보간의 관계를 모델링하는데, CNN 또는 RNN 대비 장기 의존성 문제를 학습하기 용이하다는 장점이 있다. 본 논문에서 사용한 딥러닝 모델은 MLP, RNN, LSTM, GRU, TCN, Transformer 등을 사용하였다. RNN, LSTM, GRU는 2개의 층을 사용하였으며, Attention 적용 유무로 나누어 실험을 진행하였다. MLP는 여러 개의 퍼셉트론 뉴런을 여러 층으로 쌓은 다층신경망 구조로 룩벡 창의 크기와 특징 벡터를 플래튼 층으로 변환 후 예측 크기만큼의 Dense 층의 구조를 갖는다. RNN, LSTM, GRU는 모두 동일한 구조로 히든 크기는 75를 사용하였고, 2개의 층으로 중첩하고, Attention 적용 유무 후 예측 크기만큼의 Dense 층의 구조를 갖는다. TCN은 64의 히든 크기를 갖으며, 커널 크기는 2, 팽창(Dilation)은 1, 2, 4의 크기를 갖는다. TCN 적용 후 예측 크기만큼의 Dense 층의 구조를 갖는다. Transformer는 해드 크기는 128, 멀티 해드 수는 2, 블록 수는 4, Feed Forward는 1D 컨볼루션을 사용하였다. Transformer 적용 후 예측 크기만큼의 Dense 층의 구조를 갖는다.

3. 실험 결과

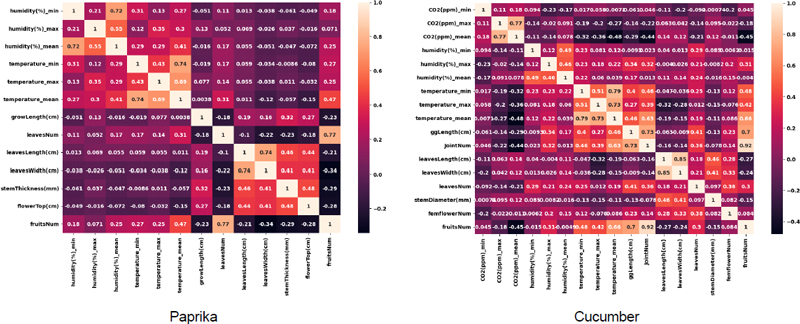

데이터셋은 83%의 학습데이터와 17% 테스트 데이터로 사용하였고, 학습 데이터와 테스트 데이테를 서로 달리하여 5개의 데이터셋으로 구분한다. 검증은 5번의 학습 결과에 대한 평균을 검증결과로 제시하였다. 예측 학습으로 사용된 손실 함수는 MSE(Mean Square Error)를 사용하였고, 학습률은 모두 동일하게 0.00005, 에폭은 200, 옵티마이저는 Adam(Adaptive Moment Estimation)을 사용하였다. 그림 3은 파프리카의 경우 총 13개, 오이의 경우 총 17개의 학습에 사용되는 환경 정보와 생육 정보로 특징 벡터에 대한 상관관계를 나타낸다.

본 논문에서는 상관관계에 따른 총 3가지로 나누어 특징 벡터를 선택하였다. 표 4는 상관관계값에 따른 학습에 사용되는 특징 벡터의 크기를 나타낸다.

표 4는 상관관계 값이 0.0일 경우는 상관관계 값에 관계없이 모든 특징 벡터로부터 학습하는 방법이다. 0.3, 0.4, 0.45의 경우 해당 상관관계 값보다 작으면 해당 특징 벡터를 제거하는 방식으로 특징 벡터를 사용하는 방식을 사용하여 모델의 결과를 분석하였다. 표 5는 스케일러 전처리에 따른 성능 비교로 다양한 모델와 다양한 예측 크기에 대한 결과의 성능지표에 대한 최소값를 표시한다. 본 논문에서 사용한 성능지표는 MSE, MAE(Mean Absolute Error)를 사용하였다. 표5의 결과 상관관계 값이 큰 특징 벡터만 사용하였을 경우 성능이 높음을 볼 수 있다. 전체적으로 표준편차가 1이 되도록하는 스케일러가 좋은 성능을 보임으로 이후의 모든 실험의 스케일러로 사용하였다.

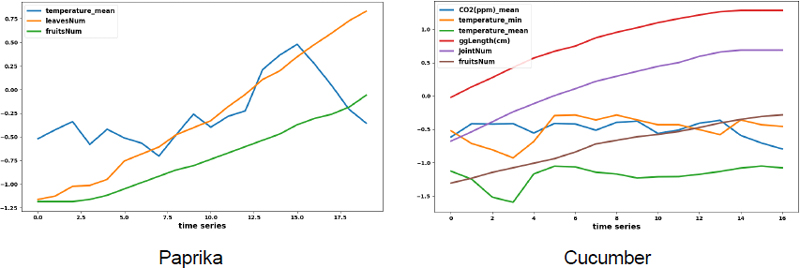

그림 4는 표 4의 상관관계 값(파프리카:0.4, 오이:0.45)에 따른 특징 벡터의 크기에 표준편차가 1이 되도록하는 스케일이 적용된 시계열 데이터를 나타내는 그림이다.

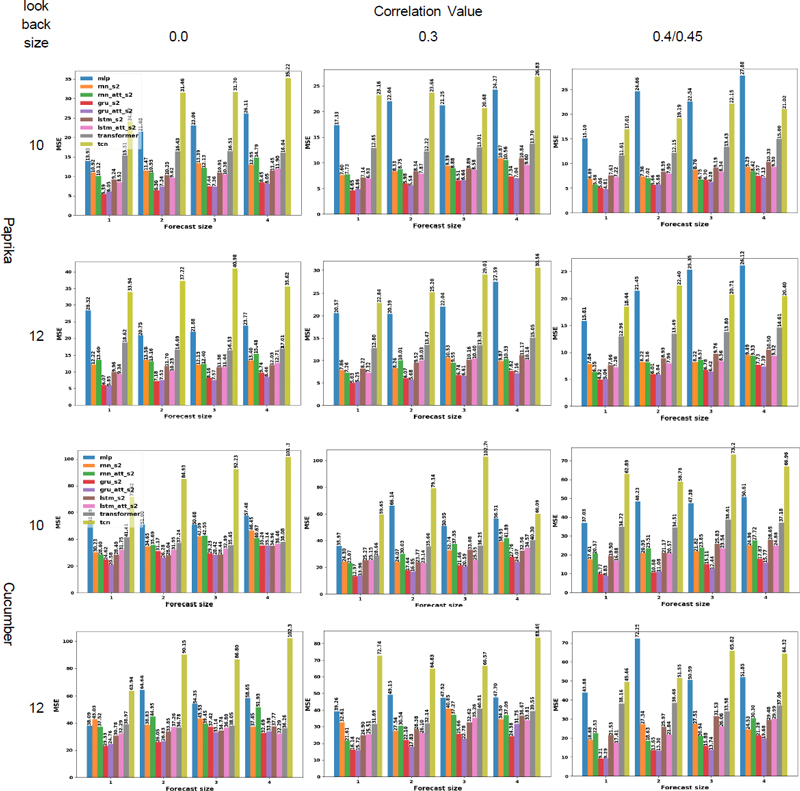

그림 5는 룩백 크기가 10, 12일 경우 각 모델에 따른 생산량 예측 크기별 성능을 나타낸다. 그림 5에서는 생산량 예측의 크기가 커짐으로써 MSE값이 커짐을 볼 수 있고, 상관관계가 큰 특징 벡터만을 사용하였을 경우 성능이 좋아짐을 볼 수가 있었다. 표 6은 룩백 크기와 상관관계값에 따른 가장 좋은 성능을 나타내는 모델과 MSE값을 나타낸다. 전체적으로 성능은 GRU 모델 혹은 Attention을 적용한 GRU 모델이 성능이 높은 것을 볼 수 있었다. GRU 모델이 성능이 좋은 이유는 본 논문에서 사용하는 데이터셋 자체가 충분하지 못하기 때문인 것으로 보인다. 또한 TCN의 성능이 낮은 것은 룩백 크기가 작기 때문으로 보인다. 파프리카의 경우 상관계수 값이 0.3이 0.4보다 높음을 볼 수 있다. 이건 상관관계값이 커짐으로써 특징벡터의 수가 작아 지기 때문에 단순하게 상관관계값이 크다고 성능이 좋아지는 것은 아님을 볼 수 있다. 룩백 크기가 10일 경우가 12일 경우보다 성능이 높게 나오는데 이러한 현상은 룩백 크기가 12일 겨우가 10일 경우보다 더 많은 데이터가 있기 때문으로 보인며, 데이터가 충분히 클경우에는 룩백크기가 12일 경우 더 좋은 성능을 보일것으로 예상된다. 성능지표가 MAE로 실험한 결과도 MSE의 결과와 비슷한 경향을 보였다.

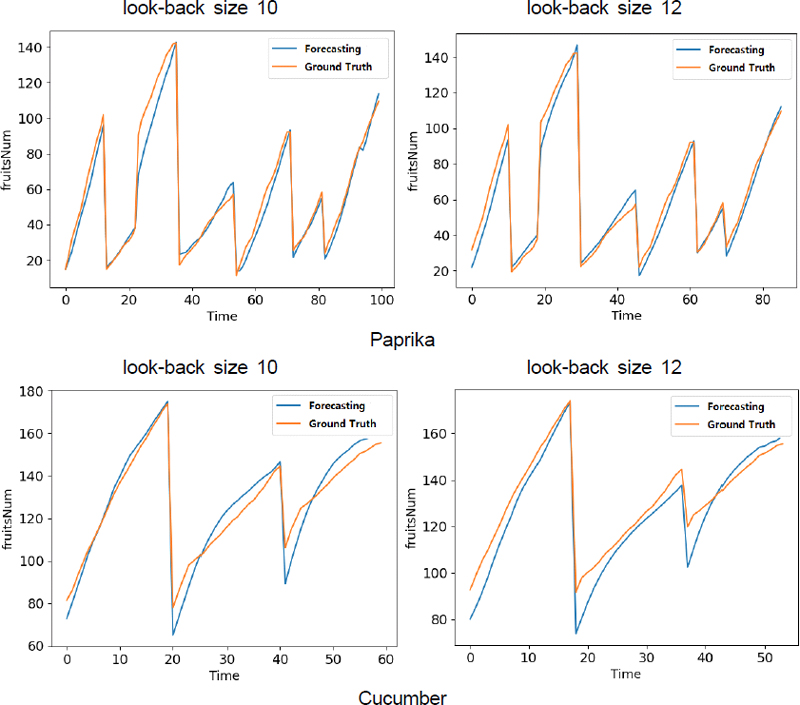

그림 6은 예상 크기가 1일 경우 가장 성능이 좋은 모델을 적용하였을 경우 실제 값과 예측값을 나타내는 그림이다.

Ⅲ. 결 론

본 논문에서는 시설원예 스마트팜중 파프리카와 오이의 환경 정보와 생육 정보를 활용하여 다양한 시계열 딥러닝 모델을 사용하여 룩백 창의 크기와 예측 데이터 크기를 다양하게 조절하여 모델에 따른 예측 성능의 결과를 분석하였다. 또한 상관관계에 따른 특징 벡터를 적용하여 각 모델별 성능 평가를 하였다. 즉 각 모델마다 룩백 창의 크기와 예측할 데이터의 크기 그리고 상관관계에 따른 특징 벡터 선택의 영향에 대한 관계를 조사하였다. 학습에 사용되는 시계열의 길이 즉 룩백 창의 크기가 짧고, 데이터셋도 충분히 크지 못한 데이터셋으로 인하여 GRU 혹은 Attention이 적용된 GRU에서 최대의 성능을 보였다. 온실 내부 생육 조건은 어느 정도 평준화되었지만, 근본적으로 농장을 둘러싼 환경은 모두 다르기 때문에 동일한 농장의 데이터를 사용하는게 좋다. 하지만 본 논문에서 사용한 데이터는 여러 농장의 데이터를 사용하였고, 품목별 종류와 작기를 구분하지 않았으며, 생육 정보는 사람이 직접 측정하여 기록한 데이터이기 때문에 측정치의 오류가 존재하는 문제점이 있다. 또한 시계열의 길이 즉 룩백 창의 크기가 짧고, 데이터셋도 충분히 크지 못한 한계가 존재한다. 이러한 제약에도 시설재배 생산량 예측을 위한 다양한 실험을 통해서 통찰력을 가질 수 있을 것이다. 향후 연구로 부족한 데이터에 대한 대책으로 시계열 데이터 증강 부분과, 충분한 데이터에서 긴 룩백 창의 크기와 긴 예측 크기를 적용하는 연구를 진행할 예정이다.

Acknowledgments

This work was supported by Institute of Information & communications Technology Planning & Evaluation (IITP) grant funded by the Korea government(MSIT) (No.2021-0-00751, Development of multi-dimensional visualization digital twin framework technology for displaying visible and invisible information with lower than 0.5mm precision).

References

- SMARTFARM KOREA, https://www.smartfarmkorea.net

-

Haoyi Zhou, Shanghang Zhang, Jieqi Peng, Shuai Zhang, Jianxin Li, Hui Xiong, and Wancai Zhang, “Informer: Beyond efficient transformer for long sequence time-series forecasting,” 2012.07436, , Mar 2021.

[https://doi.org/10.48550/arXiv.2012.07436]

-

Haixu Wu, Jiehui Xu, Jianmin Wang, Mingsheng Long, “Autoformer: Decomposition transformers with autocorrelation for long-term series forecasting,” 2106.13008, , Jan 2022.

[https://doi.org/10.48550/arXiv.2106.13008]

- Shizhan Liu, Hang Yu, Cong Liao, Jianguo Li, Weiyao Lin, Alex X Liu, and Schahram Dustdar, “Pyraformer:Low-complexity pyramidal attention for long-range time series modeling and forecasting,” In International Conference on Learning Representations, January 2022.

- Shiyang Li, Xiaoyong Jin, Yao Xuan, Xiyou Zhou, Wenhu Chen, Yu-Xiang Wang, and Xifeng Yan, “Enhancing the locality and breaking the memory bottleneck of transformer on time series forecasting,” Advances in Neural Information Processing Systems, pp. 5243-5253, December 2019.

-

Tian Zhou, Ziqing Ma, Qingsong Wen, Xue Wang, Liang Sun, and Rong Jin, “Fedformer: Frequency enhanced decomposed transformer for long-term series forecasting,” 2201.12740, , June 2022.

[https://doi.org/10.48550/arXiv.2201.12740]

-

Zeng, A., Chen, M., Zhang, L., & Xu, Q, “Are Transformers Effective for Time Series Forecasting?,” August 2022, arXiv:2205.13504.

[https://doi.org/10.48550/arXiv.2205.13504]

-

Tianping Zhang, Yizhuo Zhang, Wei Cao, Jiang Bian, Xiaohan Yi, Shun Zheng, Jian Li, "Less Is More: Fast Multivariate Time Series Forecasting with Light Sampling-oriented MLP Structures," July 2022, arXiv:2207.01186.

[https://doi.org/10.48550/arXiv.2207.01186]

-

S. Hong, T. Park, J. Bang, H. Kim, “A Study on the Prediction Model for Tomato Production and Growth Using ConvLSTM,“ Journal of KIIT, Vol.18, No.1, pp.1-10, Jan 2020.

[https://doi.org/10.14801/jkiit.2020.18.1.1]

-

H. Oh, J. Lim, S Yang, Y. Cho, C. Shin, "A Study on the Prediction of Strawberry Production in Machine Learning Infrastructure," Smart Media Journal, Vol.11, No.5, pp.9-16, June 2022.

[https://doi.org/10.30693/SMJ.2022.11.5.9]

-

Y. Kim, B. Kim, S. Ahn, "Application of spatiotemporal transformer model to improve prediction performance of particulate matter concentration,“ Journal of Intelligence and Information Systems, Vol.28, No.1, pp.329-352, March 2022.

[https://doi.org/10.13088/jiis.2022.28.1.329]

-

H. Choi, H. Ahn, Y. Jeong, B. Lee, “A Smart Farm Environment Optimization and Yield Prediction Platform based on IoT and Deep Learning,” Journal of Korea Institute of Information, Electronics, and Communication Technology, Vol.12, No.6, pp.672-680, December 2019.

[https://doi.org/10.17661/jkiiect.2019.12.6.672]

-

J. Park, Y. Lim, D. Lim, Y. Choi, H.l Ahn, “A Multi-step Time Series Forecasting Model for Mid-to-Long Term Agricultural Price Prediction,” Journal of the Korea Society of Computer and Information, Vol. 28, No.2, pp.201-207, February 2023.

[https://doi.org/10.9708/jksci.2023.28.02.201]

-

Sepp Hochreiter, Jürgen Schmidhuber, “Long Short-Term Memory,” Neural computation, Vol.9, No.15, pp.1735-1780, November 1997.

[https://doi.org/10.1162/neco.1997.9.8.1735]

-

Cho et al., "Learning Phrase Representations using RNN Encoder–Decoder for Statistical Machine Translation," In Proceedings of the 2014 Conference on Empirical Methods in Natural Language Processing (EMNLP), pp.1724–1734, October 2014.

[https://doi.org/10.3115/v1/D14-1179]

-

Shaojie Bai, J. Zico Kolter, Vladlen Koltun, “An Empirical Evaluation of Generic Convolutional and Recurrent Networks for Sequence Modeling,” Mar 2018, arXiv:1803.01271.

[https://doi.org/10.48550/arXiv.1803.01271]

- A. Vaswani, N. Shazeer, N. Parmar, J. Uszkoreit, L. Jones, A. Gomez, “Attention is All you Need,” NIPS'17: Proceedings of the 31st International Conference on Neural Information Processing Systems, pp.6000–6010, December 2017.

- SMARTFARM DATAMART, https://data.smartfarmkorea.net

- 2011년 2월 : 서울과학기술대학교 NID융합기술대학원 석사

- 2020년 3월 ~ 현재 : 서울과학기술대학교 IoT 융복합 기술 연구소 책임 연구원

- 2020년 9월 ~ 현재 : 서울과학기술대학교 나노IT디자인융합대학원 정보통신미디어공학전공 박사과정

- ORCID : https://orcid.org/0000-0003-0822-9857

- 주관심분야 : 컴퓨터비전, 딥러닝

- 1984년 2월 : 한국항공대학교 전자공학과 공학사

- 1986년 2월 : 연세대학교 전자공학과 공학석사

- 1991년 2월 : 연세대학교 전자공학과 공학박사

- 1991년 3월 ~ 1996년 9월 : 삼성전자 신호처리연구소 선임연구원

- 2016년 1월 ~ 2017년 12월 : 서울과학기술대학교 나노IT디자인융합대학원 원장

- 1999년 8월 ~ 현재 : 서울과학기술대학교 스마트ICT융합공학과 교수

- 2006년 1월 ~ 2007년 8월 : Georgia Institute of Technology Dept.of Electrical and Computer Engineering, Visiting Scholar

- ORCID : https://orcid.org/0000-0002-7055-5568

- 주관심분야 : 컴퓨터비전, 지능형실감미디어