LFBM5D의 광학 흐름 기반 패치 탐색 및 GPU 병렬처리 기법

Copyright © 2025 Korean Institute of Broadcast and Media Engineers. All rights reserved.

“This is an Open-Access article distributed under the terms of the Creative Commons BY-NC-ND (http://creativecommons.org/licenses/by-nc-nd/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited and not altered.”

초록

라이트필드의 고전적인 초해상도 방식으로 제안된 LFBM5D 기법은 저주파 대역에서의 패치 매칭을 통해 영상 간의 차이를 보정하고, 5차원 필터링을 적용하여 복원 품질을 향상시킨다. 기존의 알고리즘은 참조 SAI (Sup-aperture image)을 기준으로 다른 SAI에서 단순히 픽셀 차를 이용하여 블록 매칭을 위한 패치를 탐색한다. 또 5차원 필터링과 반복적인 패치 탐색으로 인해 시간이 많이 소요된다. 본 논문에서는 LFBM5D 알고리즘의 성능을 개선하기 위해 광학 흐름을 도입하여 새로운 패치 탐색 기법을 제안한다. 이 기법은 참조 영상과 다른 영상 간의 움직임을 보정해 더 정확한 패치를 탐색할 수 있도록 한다. 또한, 복원 과정에서 발생하는 아티팩트를 줄이기 위한 역투영 과정을 CUDA 기반으로 병렬화하여 전체 처리 속도를 크게 개선하였다. 실험 결과 제안된 방법은 기존 LFBM5D 알고리즘에 비해 더 높은 정확도와 빠른 처리 속도를 달성하였다.

Abstract

The classical super-resolution method for light fields, LFBM5D, improves reconstruction quality by compensating for differences between images through patch matching in the low-frequency domain and applying five-dimension(5D) filtering. Existing algorithms typically perform block matching by searching for patches based on pixel differences between Sub-aperture images(SAIs) based on the reference SAI. However, the 5D filtering process and iterative patch search are time-consuming. In this paper, we propose a new patch search technique by introducing optical flow to improve the performance of the LFBM5D algorithm. This technique adjusts the motion between the reference image and other images, resulting in more precise patch searches. Additionally, we parallelize the back projection process, which reduces reconstruction artifacts, using CUDA to significantly boost processing speed. Experimental results show that the proposed method achieves higher accuracy and faster processing speeds compared to the existing LFBM5D algorithm.

Keywords:

Light field, Super-resolution, Optical flow, GPU parallelizationⅠ. 서 론

라이트필드는 3차원 공간의 모든 지점을 통해 모든 방향으로 흐르는 빛의 양을 설명하는 벡터 함수이며, 마이크로 렌즈 배열 카메라를 통해 하나의 센서로 물체에서 반사되는 빛의 강도와 방향을 포착하여 라이트필드를 획득할 수 있다. 마이크로 렌즈 배열을 기반으로 획득한 라이트필드는 공간 해상도와 각도 해상도 간의 상호보완적인 관계를 가진다[1]. 따라서 라이트필드 분야에서 초해상도가 중요한 주제로 언급되는 이유이다. 라이트필드의 초해상도는 각도 초해상도와 공간 초해상도로 나누어 볼 수 있다.

라이트필드 공간 초해상도는 라이트필드의 Sub-aperture images (SAIs)의 각각의 해상도를 높이는 방법을 의미한다. 비학습기반 라이트필드 초해상도 방법으로는 수학적인 모델링 방법[2]과 4D 기하학적 접근 방법[3]이 있다. LFBM5D는 수학적인 모델링 방법으로 BM3D (Block Matching and 3D Filtering)은 알고리즘을 확장해 라이트필드 데이터에 특화된 고차원 필터링 기법이다. BM3D은 영상 잡음 제거를 위한 알고리즘으로, 유사한 2D 패치들을 찾아 3D 스택을 구성한 후, 이를 변환 도메인에서 처리하여 잡음을 제거한다. LFBM5D는 이 개념을 4차원 라이트필드 구조에 적용하여, 더 높은 차원인 5D 필터링을 통해 공간적, 각도적 정보를 모두 활용한 고해상도 복원을 수행한다.

본 논문에서는 LFBM5D 알고리즘의 성능을 향상시키기 위해 광학 흐름을 적용한 새로운 패치 탐색 기법과 아티팩트 제거를 위한 역투영 과정을 CUDA 기반으로 병렬화하여 처리 속도를 개선한 방법을 제안한다.

Ⅱ. 제안하는 기법

1. 전반적인 네트워크 구조

LFBM5D 알고리즘은 참조 SAI에서 선택한 패치와 다른 SAI에서 유사한 패치를 탐색하고 5차원 필터링을 하는 단계와 필터링된 결과를 바탕으로 고해상도 복원 결과를 보정하는 역투영 단계로 이루어져 있다. 본 논문에서는 LFBM5D 알고리즘의 성능을 개선하기 위해 두 가지 주요 기법을 제안한다. 첫째, 광학 흐름을 적용한 새로운 패치 탐색 방법을 도입하여 더 정확한 패치 추출을 가능하게 한다. 둘째, 역투영 과정의 계산을 CUDA를 통해 병렬화 처리하여 속도를 크게 향상시켰다.

2. 광학 흐름을 적용한 새로운 패치 탐색

기존의 LFBM5D 알고리즘은 참조 SAI와 다른 SAI 간의 차이를 유클리드 거리를 사용하여 패치를 찾는 방식이다. 수식으로 표현하면 다음과 같다.

| (1) |

참조 SAI는 차이맵을 구하고자 하는 SAI로 나타낸다. 영상 내에서의 움직임이나 변형을 고려하지 않고 단순히 픽셀 간의 정적 차이만 계산하기 때문에 잘못된 패치 매칭이 발생할 수 있다.

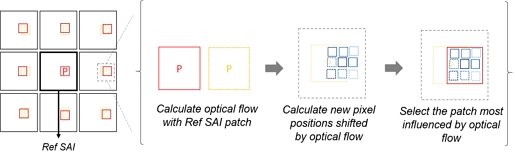

이러한 문제를 해결하기 위해 본 논문에서는 광학 흐름을 도입한다. 광학 흐름은 시간적 또는 공간적 변화에 따른 픽셀의 이동을 벡터 형태로 계산하는 기법으로, 이를 참조 SAI와 주변 SAI 간의 패치 탐색에 활용한다. 광학 흐름을 이용하여 참조 SAI와 주변 SAI 간의 픽셀 이동 벡터를 계산하고, 이를 기반으로 패치 탐색 위치를 보정함으로써 보다 정교한 패치 매칭을 가능하게 한다. 이를 수식으로 표현하면 다음과 같다.

| (2) |

이 방법을 통해 차이 맵(difference map)을 기존 유클리드 거리 기반 방식보다 더 정교하게 계산할 수 있다. 기존 방식에서는 단순히 픽셀 간의 차이만을 비교하여 패치의 유사성을 계산했다면, 광학 흐름을 적용한 방법에서는 픽셀이 실제로 이동한 경로를 반영한 차이 계산이 이루어진다. 이때 광학 흐름은 빠른 계산을 위해 Farneback 알고리즘[4]을 사용한다. 광학 흐름을 통해 계산한 벡터를 참조 SAI가 아닌 주변 SAI의 각 픽셀에 더하여 참조 SAI로부터 이동한 픽셀의 위치를 구한다. 광학 흐름을 통해 이동된 픽셀이라고 판단되면 차이 맵을 구할 때 가중치를 추가한다.

여기서, (u(x,y), v(x,y))는 픽셀 위치에서의 광학 흐름 벡터를 나타내며, 이동된 픽셀의 위치를 보정한다. 마지막 항은 광학 흐름을 통해 이동된 픽셀에 가중치로 이러한 이동이 차이 맵에 더 큰 영향을 미치도록 조정한다. 이를 통해 패치 탐색 시, 이동된 픽셀을 더 많이 반영하여 더 정확한 패치 매칭을 가능하게 한다. 각 패치에 해당하는 차이 맵을 더하여 패치를 결정하므로 광학 흐름을 통해 계산된 픽셀이 많이 포함된 패치가 선택되게 된다. 따라서 픽셀 간 차이를 광학 흐름으로 보정하여 보다 정확한 유사도를 계산하며, 단순한 유클리드 거리를 기반으로 한 차이 계산에 비해 정확한 차이 맵을 계산할 수 있다. 제안하는 광학 흐름을 적용한 새로운 패치 탐색 기법은 그림 1에 나타내었다.

3. CUDA 기반 병렬화

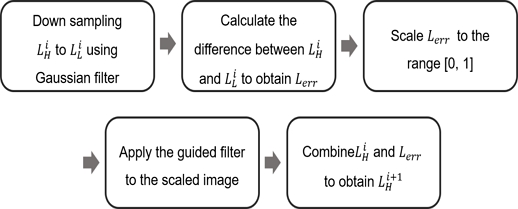

역투영 과정은 LFBM5D 알고리즘에서 복원 품질을 크게 향상시키는 중요한 단계지만, 그 과정에서 발생하는 계산량이 상당히 많아 처리 시간이 길어질 수 있다는 문제점이 있다. 그림 2에서 볼 수 있듯이 역투영 과정에서는 복원된 고해상도 영상과 저해상도 영상 간의 차이를 보정하기 위해 여러 필터링 작업이 반복적으로 수행되는데, 이들은 일반적으로 순차적으로 처리되기 때문에 많은 시간이 소요된다. 기존 방식에서는 가우시안 필터와 가이디드 필터와 같은 필터링이 순차적으로 적용되면서 전체적인 처리 시간이 크게 증가한다.

이러한 문제를 해결하기 위해 본 논문에서는 CUDA Toolkit[5]을 참고하여 CUDA 기반 병렬화 기법을 제안하였다. 기존의 LFBM5D 방식과 다르게 본 논문에서는 역투영 과정을 모두 CUDA를 사용하여 진행해 기존 방식에 비해 빠른 처리 속도를 달성한다. 제안하는 방법은 역투영 과정에서 필요한 영상들을 CUDA 메모리로 옮겨 CPU와 GPU 간의 메모리 이동을 최소화하고 각 픽셀을 개별적으로 필터링 작업을 동시에 수행할 수 있어, 순차적인 처리 방식에 비해 계산 효율성을 극대화할 수 있다.

III. 실험 결과 및 분석

본 실험에서는 STFgantry 데이터셋[6]의 Lego Knights와 HCI_new 데이터셋[7]의 origami 라이트필드 데이터를 사용하여 성능을 평가한다. 라이트필드의 각도 해상도를 5x5로 고정하고, 초해상도 스케일 팩터는 4로 설정한다. 또한 RTX 4090 GPU를 사용하여 모든 실험을 진행한다.

1. 정성적 결과

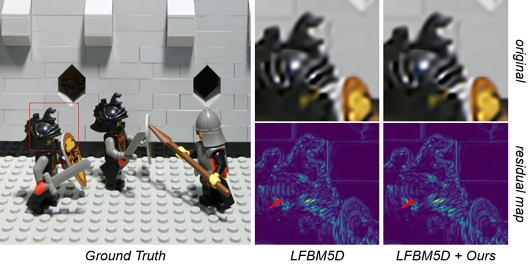

그림 3은 정성적 실험 결과로, 광학 흐름을 적용한 새로운 패치 탐색 방법의 성능을 평가하기 위해 Ground Truth (GT)와 비교한 확대된 영상을 제시한다. 제안한 방법을 적용하였을 때 가장자리의 잡음이 줄고 결과가 더 선명해진 것을 볼 수 있다. Residual map은 복원된 영상과 GT 간의 차이를 시각화한 것으로, 값이 푸른 색일수록 복원 품질이 높음을 의미한다. 제안한 광학 흐름 기반 패치 탐색 방법을 적용했을 때, 기존 방법에 비해 residual 값이 감소하며, 화살표로 표시한 부분에서 오차가 줄어든 것을 확인할 수 있다.

2. 정량적 결과

표 1은 실험 데이터셋에 대해 PSNR (Peak Signal-to-Noise Ratio) 값을 비교하여 제안된 방법의 복원 성능을 평가한다. 또한 역투영 단계에서 CUDA를 적용하였을 때 PSNR이 유지되는지 비교한다. 실험 결과는 라이트필드의 중앙 SAI를 비교한 PSNR과 SAIs의 평균 PSNR 두 가지를 비교한다. 표 1에서 볼 수 있듯이 CUDA만 적용하였을 때는 PSNR이 유지되는 것을 볼 수 있고 광학 흐름을 적용한 새로운 패치 탐색을 적용하였을 때는 PSNR이 증가하는 것을 볼 수 있다.

Quantitative PSNR results comparison when applying the new patch search method with optical flow (OF) and CUDA parallelization to the LFBM5D algorithm

표 2에서는 CUDA 기반 병렬화 기법을 적용했을 때의 처리 시간 단축 효과를 평가한다. 기존 방식과 CUDA를 적용한 방식 간의 처리 시간을 비교하여, 병렬화가 복원 과정에서 얼마나 효율적으로 작동하는지를 수치적으로 분석한다. 한 번의 iteration에서 Back projection (BP)의 수행 시간 차이와 50번의 iteration을 거친 전체적인 알고리즘(Entire)의 수행 시간 차이를 비교하며, BP 단계에서는 95%, 전체적인 알고리즘은 40%의 시간 단축 효과가 관찰되었다.

Ⅳ. 결 론

본 논문에서는 LFBM5D 알고리즘의 성능을 개선하기 위해 광학 흐름 기반의 패치 탐색 기법과 CUDA 기반 병렬화를 통한 처리 속도 향상 방안을 제안하였다. 기존의 유클리드 거리 기반 패치 탐색은 단순히 픽셀 간의 차이만 계산한 차이맵을 구해 정확도가 떨어졌지만, 광학 흐름을 도입함으로써 패치 매칭의 정밀도를 높였다. 또한, 역투영 과정에서 발생하는 복잡한 필터링 작업을 CUDA로 병렬 처리하여 전체 처리 시간을 크게 단축할 수 있었다.

Acknowledgments

This work was partly supported by the National Research Foundation of Korea (NRF) grant funded by the Korea government (MSIT) (No.2022R1A4A1033549). This work was partly supported by Institute of Information & communications Technology Planning & Evaluation (IITP) grant funded by the Korea government (MSIT) (No.RS-2022-00155915, Artificial Intelligence Convergence Innovation Human Resources Development (Inha University)) and No. 2022-0-00981, Foreground and Background Matching 3D Object Streaming Technology Development.

References

-

Levin, A., Freeman, W.T., and Durand, F., “Understanding camera trade-offs through a bayesian analysis of light field projection,” Proc. European Conference on Computer Vision, October 2008.

[https://doi.org/10.1007/978-3-540-88693-8_7]

-

Alain, M., and Smolic, A., “Light field super-resolution via LFBM5D sparse coding,” Proc. IEEE International Conference on Image Processing, October 2018.

[https://doi.org/10.1109/ICIP.2018.8451162]

-

Rossi, M., and Frossard, P, “Graph-based light field super-resolution,” Proc. IEEE International Workshop on Multimedia Signal Processing, November 2017.

[https://doi.org/10.1109/MMSP.2017.8122224]

-

Farnebäck G., “Two-frame motion estimation based on polynomial expansion,” Proc. Scandinavian Conference, June 2003.

[https://doi.org/10.1007/3-540-45103-X_50]

- NDIVIA CUDA Toolkit document, https://docs.nvidia.com/cuda/cuda-runtime-api/modules.html, (accessed October 11, 2024).

-

Wilburn, B., Joshi, N., Vaish, V., Talvala, E.V., Antunez, E., Barth, A., Adams, A., Horowitz, M., and Levoy, M., “High performance imaging using large camera arrays,” ACM Trans. on Graphics, vol. 24, no. 3, pp. 765-776, August 2005.

[https://doi.org/10.1145/1073204.1073259]

-

Honauer, K., Johannsen, O., Kondermann, D., Goldluecke, B., “A dataset and evaluation methodology for depth estimation on 4D light fields,” Proc. Asian Conference on Computer Vision, November 2017.

[https://doi.org/10.1007/978-3-319-54187-7_2]