코렉터 어텐션 네트워크을 이용한 로우 센서 영상 초해상화 기법

Copyright © 2023, The Korean Institute of Broadcast and Media Engineers

This is an Open-Access article distributed under the terms of the Creative Commons BY-NC-ND (http://creativecommons.org/licenses/by-nc-nd/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited and not altered.

초록

본 연구에서는 전통적인 RGB 영상보다 데이터양이 적은 로우 센서 영상을 이용한 초해상화 네트워크를 제안하고 이에 대한 실험 결과를 정리하였다. 로우 센서 영상의 초해상화는 일반적인 RGB 초해상화와 달리 카메라에서 일어나는 후처리 가공이 없는 무손실 영상을 이용하기 때문에 결과물의 성능이 일반 RGB 초해상화 연구와 달리 색상 보정에 따라 많이 좌우된다. 따라서, 본 연구에서는 색상 보정을 위한 모듈을 개발하여 기존 RGB 기반 네트워크에 삽입해 이를 이용해 성능 결과를 비교하였다. 연구 결과 색상 보정 모듈을 적용함으로 성능 지표의 향상이 있음을 확인하였다. 다만, 출력 영상의 의도하지 않은 아티팩트가 발생하는 현상을 확인하였고, 성능 지표 중 PSNR의 향상이 분명하나 SSIM의 성능이 일부 떨어지는 것으로 확인하였다.

Abstract

In this paper, we propose a super resolution network for raw sensor image which data size is lower comparatively to RGB image. But the actual capabilities of raw image super resolution depends on color correction because its absent of camera post processing that leads to unintended result having different white balance, saturation, etc. Thus, we introduce novel color corrector attention network by adopting the idea of precedent raw super resolution research, and tune to the our faced problem from data specification. The result is not superior to former researches but shows decent output on certain performance matrix. In the same time, we encounter new challenging problem of unexpected shadowing artifact around image objects that cause performance declination despite its good result overall. This problem remains a task to be solved in the future research.

Keywords:

Super resolution, raw sensor image, image restoration, attention network, color correctionⅠ. 서 론

영상 초해상화(super resolution, SR)는 저해상도의 영상을 고해상도의 영상으로 변환하는 기술이다. 영상 초해상화는 컴퓨터 비전(computer vision) 분야의 하위 주제인 영상 복원(image restoration) 문제의 일종으로 다양한 산업에서 응용기술로 사용되고 있어 그 연구 가치가 크다. 대표적인 응용 분야로는 감시 카메라의 영상 해상도를 높여 보안(surveillance) 분야에 활용하거나 위성 영상의 해상도를 높여 원격 탐사(remote sensing)에 활용 가능하며, 디스플레이 장치에서도 저해상도로 송신된 영상을 장치에 적합한 해상도로 변경하거나 콘텐츠 스트리밍 서비스에서도 과거의 저해상도 콘텐츠를 송신하기 위하여 관련 기술이 필요하다. 이러한 이유로 그 중요성을 인정받아 CVPR(IEEE Conference on Computer Vision and Pattern Recognition)과 함께 열리는 NTRIE Challenge(New Trends in Image Restoration and Enhancement)[1]에서 매년 초해상화 대회를 열고 있을 정도로 초해상화 연구는 많은 연구자들과 산업계의 관심을 받는 분야이다.

초해상화 문제는 수학적으로 유일한 해인 고해상도 영상이 존재하지 않는 문제(ill-posed problem)로 해 공간을 줄이기 위해 사전정보(prior information)를 이용한다. 과거에는 샘플을 통한 학습 전략(sample-based strategy)을 사용하여 사전정보를 제한하는 방법으로 연구가 행해져 왔으며, 이와 같은 방법을 활용하는 Total Variation[2], Sparse Coding[3][4] 등이 초해상화 연구에서 좋은 성능을 보여주었다. 최근 심층신경망(deep neural network) 발전과 함께 심층학습(deep learning) 기법이 영상 복원에 도입[5]되어 동 분야에 비약적인 성능 향상이 있었으며, 이후로 영상 초해상도 분야에서도 대부분의 연구가 심층신경망을 활용하고 있다.

로우 센서 데이터란 디지털 카메라로 촬영된 영상을 후처리(post-processing)하는 과정 없이 센서 출력 그대로 저장된 영상으로 센서 배열에 따라 화소마다 3채널의 컬러 정보 중 R 혹은 G 혹은 B 요소 하나만 가지고 있는 데이터이다. 따라서, 디지털 영상 센서가 획득한 로우 데이터는 카메라 출력 형태인 RGB 영상으로 변환되기 위하여 디모자이킹(demosaicking), 화이트 밸런스(white balance), 채도(saturation) 보정, 명암비(contrast) 보정, 선명도(sharpness) 보정과 같은 후처리 과정을 통과한 후 JPEG 파일 형식 등으로 압축(compression)되어 저장된다. 그러나 로우 데이터를 후처리하는 과정에서는 12비트 혹은 14비트로 획득된 원래 영상 센서 정보가 유지되지 않으며, 압축 후의 RGB 영상은 일반적으로 8비트의 부호없는 정수형으로 저장되어 정보의 손실이 발생한다.

후처리 과정 중 하나인 디모자이킹은 화소마다 하나의 컬러 정보만 가지고 있는 로우 센서 데이터를 화소마다 3채널 컬러 정보를 모두 가지도록 존재하지 않는 컬러 값을 주변 정보를 이용하여 생성하는 보간(interpolation) 방법이다. 이와 같은 디모자이킹 과정은 영상 초고해상화 과정에서 화소수를 증가하기 위하여 저해상도 영상의 주변 영역 정보를 이용하여 새로운 화소를 만들어내는 기법과 매우 유사하다. 하지만 현재까지의 영상 초해상화 연구는 대부분 디지털 카메라 내에서 후처리 과정을 통과한 압축된 형식의 영상을 학습과 추론을 위해 사용하고 있으며, 로우 센서 데이터를 이용하여 초고해상화를 수행하는 연구는 많지 않다[28][29]. 이는 과거에는 디지털 카메라의 최종 출력인 RGB 영상을 제외한 로우 데이터 접근이 쉽지 않았으며, 이에 따라 로우 센서 데이터 포함된 실험 가능한 벤치마크 데이터가 존재하지 않기 때문이다. 그러나 앞서 언급한 초해상화 문제의 특성상 입력 영상에서 더 많은 사전 정보를 추출할 수 있다면 모델 성능에서도 좋은 결과를 얻을 수 있다고 추론할 수 있다. 또한, 초해상화 문제에서 입력 영상과 출력 영상은 낮은 주파수(low frequency) 정보는 공유하는 한편, 높은 주파수(high frequency) 정보를 복원하는 작업이기 때문에 정보가 손실되지 않은 로우 센서 영상을 활용하여 초해상화를 진행하는 것이 성능의 측면에서 유리할 것으로 추정하는 것은 합리적인 접근이라고 할 수 있다. 본 논문에서는 이러한 이유로 기존 초해상화 연구들이 제시한 모델들을 이용하여 로우 센서 영상에서 네트워크의 학습 및 성능을 비교 평가하여 로우 센서 영상에서 기존 RGB 형식의 영상에서 나타내던 수준의 성능을 나타내는지 비교하는 연구를 진행하고자 한다.

Ⅱ. 관련 연구

1. 딥러닝(deep learning) 기반 초해상화 연구

초해상화 문제에 딥러닝을 활용한 최초의 연구는 C. Dong et al.의 초고해상화 합성곱 신경망(Super-Resolution Convolutional Neural Network, SRCNN)[5][6]에 관한 연구이다. 제안된 초고해상화 합성곱 신경망은 기존의 초해상화 연구에서 사용하던 특징 추출(feature extraction), 비선형 맵핑(non-linear mapping), 복원(reconstruction)의 세 단계 모두에 합성곱 층(convolution layer)을 적용한 심층학습 구조를 제시하였으며, 기존 연구들을 뛰어넘는 성과로 이후 딥러닝을 통한 초해상화 연구들이 주류를 이루는데 기여하였다. 이 연구를 통하여, 심층 학습 기반의 신경망이 영상 초해상화 분야에 도입되고, 고전적인 방식에 비해 비약적인 성능 향상을 이루었으나, 신경망의 깊이가 증가할수록 정보 손실이 발생함으로써 성능증가에 한계가 발생하였다. 또한, 신경망의 구조가 복잡해짐에 따라 연산량이 증가하여 실제 문제에 적용하기가 어려워지거나, 생성된 초고해상도 영상은 성능지표 상의 높은 점수에도 불구하고 사람의 보기에 선명도가 떨어지는 등의 문제점이 발생하였다. 따라서, 이와 같은 문제점을 해결하기 위하여 다양한 시도들이 나타나면서 관련 연구가 발전하게 되었다.

초기 심층학습을 적용한 초해상화 연구들은 합성곱 층을 깊게 쌓을수록 성능이 좋아진다는 것이 일반적인 인식이었는데, 이유는 네트워크가 깊어질수록 리셉티브 필드(receptive field), 즉 필터가 정보를 얻기 위해 살펴보는 이미지 영역이 넓어지면서 더 많은 정보를 추출할 수 있다는 생각 때문이었다[7]. 그러나 초해상화의 경우에는 무조건 깊이를 늘리다 보면 심층신경망의 낮은 층(low-level)의 정보 또는 영상의 낮은 주파수 성분이 점차로 소실되어 깊이가 증가해도 성능이 향상되지 않는다. 이에 따라, 심층신경망의 정보 손실을 최소화하기 위한 기법들이 도입되었으며, 대표적인 기법으로는 스킵 커넥션(skip connection)[8]이 있다. 스킵 커넥션은 합성곱 층을 통과하지 않은 입력 데이터를 합성곱 층의 출력에 더해줌으로써 입력 부분을 제외한 추가적인 정보만을 학습하므로 잔차 학습(residual learning) 혹은 잔차 커넥션(residual connection)으로도 불린다. Kim et al. 의 매우 깊은 합성곱 신경망(Very Deep Convolutional Network, VDCN)[7]에서 처음 초해상화에 스킵 커넥션을 사용하였으며, 스킵 커넥션은 이후 심층 재귀 합성곱 신경망(Deeply-recursive Convolutional Network, DRCN)[9], 잔차 인코더-디코더 신경망(Residual Encoder-Decoder Network, RED-Net)[10], 초해상화 잔차 신경망(Residual Network, ResNet)[11]에 사용되면서 그 효용성이 검증되었고 현재까지도 대부분의 심층학습 기반 초고해상화 신경망에 사용되고 있다. 또한, DenseNet[12]의 등장으로 초해상화에서도 덴스 연결(dense connection)이 사용되기 시작[13]하였다. 덴스 커넥션은 각 층에서 생성된 특징맵(feature map)을 모두 사용하여 심층신경망의 낮은 층과 높은 층의 모든 특징맵을 고려한다는 점에서 낮은 층 정보의 이용 또한 중요한 초해상화 문제에 적합하며, [14]와 같은 구조의 초고해상화 신경망에 사용되었다.

이후에는 특징맵 간에 상호의존을 고려하여 어떤 특징맵들을 어떻게 활용할 것인지에 대해 연구하기 시작하였다. 이러한 움직임의 핵심에 있는 것이 바로 어텐션 메커니즘(attention mechanism)[15]으로 특징맵 또는 특징 채널 간의 상호 관계를 분석하여 어떤 특징맵에 보다 가중치를 부여할지를 학습한다. [16]에서는 어텐션 메커니즘을 초해상화에 접목한 매우 깊은 잔차 채널 어텐션 신경망(Very Deep Residual Channel Attention Network, RCAN)을 제안하였다. Dai et al. 은 채널 간의 상호 관계 파악을 위하여 공분산(covariance) 행렬을 이용하는 방법[17]을 제안하였으며, Liu et al. 은 기존의 한 층 안에서 특징 채널 간 어텐션만을 고려하지 않고 층간에도 어텐션을 적용하는 방법[18]을 제안하였다. 또한, [18]에서는 순환(recurrent) 구조의 비지역(non-local) 연산을 사용하여 해당 특징 영역과 주변 영역 간의 상관관계 정보를 신경망 학습에 전파하는 구조를 사용하였다. 이와 유사하게, Mei et al. 은 입력 특징을 여러 스케일(scale)에서 비지역 연산을 수행하여 이를 활용하는 방식[19]을 제안하였다.

초기에 초해상화 연구들은 신경망의 구조를 더욱 깊이 만들어서 성능을 향상하고자 하였으나, 학습에 많은 시간이 소요되고, 구조적 복잡성으로 인해 실제 문제 적용에 어려움이 있었다. 반면에, 실제 문제에 적용되는 장치들은 경량화되어 연산 효율성에 대한 이슈가 중요해지면서 신경망 구조를 효율적으로 만들기 위한 연구가 이루어졌다. 이와 같은 문제에 대한 해결 방안으로 저해상도 영상을 보간법을 통해 목표로 하는 크기의 고해상도 영상을 생성하고 이를 입력으로 사용하는 방식(pixel shuffling)이 제안되었으나 신경망의 크기가 커지는 문제점이 발생하였다. 따라서, 보간법으로 생성된 고해상도 영상을 입력으로 사용하면서도 효율적인 신경망을 설계하고자 [20]에서는 서브 픽셀 합성곱(sub-pixel convolution) 구조를 사용하였으며, [21]에서는 디콘볼루션(deconvolution)을 활용하는 방법, 점진적으로 영상 사이즈를 확대하기 위하여 네트워크 중간 단계마다 디콘볼루션을 사용하는 방식[22] 등이 제안되었다. 또한, 신경망의 매개변수 수를 줄여 학습 시간을 단축하는 회귀 구조를 활용하는 방식[8], [18], [23], [24], [25], [26]도 제안되었다.

2. 로우 데이터 초해상화 연구

로우 센서 영상을 활용한 초해상화의 기존 연구는 매우 제한적이며, 연구에 활용 가능한 데이터셋(dataset)도 존재하지 않는다. 이에 따라, Zhang et al. 은 광학적인 확대를 이용해 직접 획득한 데이터셋인 SR-RAW를 이용하여 초고해상도 연구를 수행하였다[27]. 그러나 SR-RAW 데이터셋은 초점 거리(focal length)가 다른 렌즈를 사용하여 촬영한 영상 집합으로, 낮은 해상도를 가지는 로우 데이터 입력과 학습 목표가 되는 초고해상도 RGB 영상(ground-truth)이 완벽하게 정렬되지 않아, 이를 해결하기 위한 컨텍스쳐 양방향 손실함수(contextual bilateral loss)를 제안하였다. Xu et al. 은 기존 초해상화의 학습을 위해 사용하는 합성(synthetic) 영상이 가지는 한계로 비선형성(non-linearity)과 단순한 가우시안 필터(Gaussian filter)를 사용한 쌍삼차 보간법(bicubic interpolation)을 논의하였으며, 이를 해결하기 위한 카메라 영상신호처리(image signal processor, ISP) 과정을 대신할 컬러 보정(color correction)과 초고해상도 과정을 분리한 덴스 채널 어테션 네트워크(dense channel-attention network)를 제안하였다[28].

Ⅲ. 제안하는 방법

1. 로우 센서 데이터

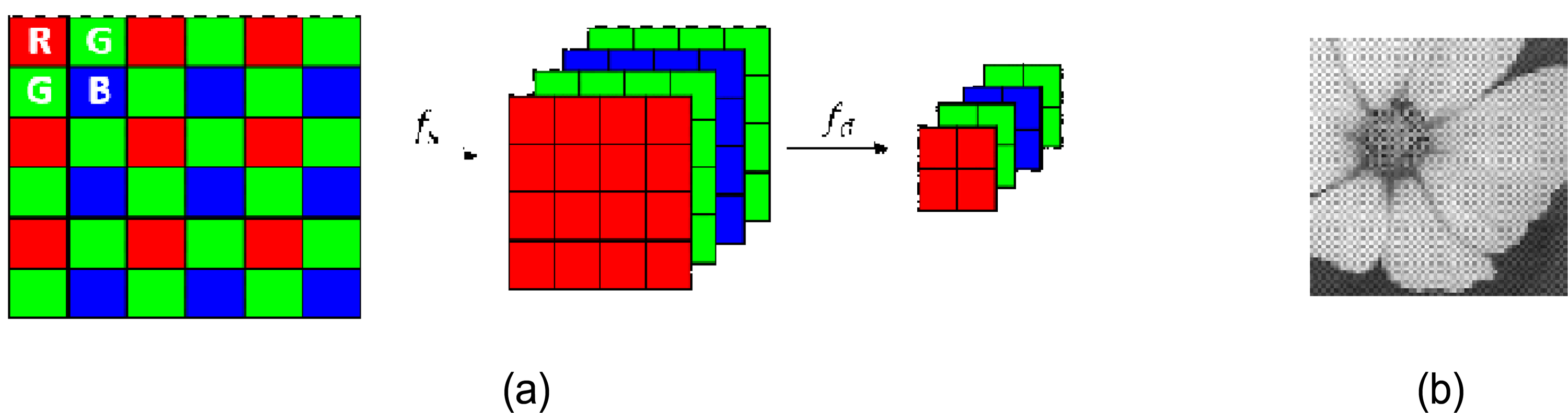

컬러 필터 배열(color filter array, CFA)는 그림 1(a)의 예시와 같이 영상 센서의 한 화소에 R 또는 G 또는 B 요소가 일정하게 배치된 패턴이다. 이와 같은 필터의 배열에 따라 생성된 센서의 출력인 로우(raw 또는 CFA) 데이터는 3개의 컬러 채널 중 한 요소만 가지는 화소로 구성되어 그림 1(b)와 같이 회색조 영상(grayscale image)으로 보이며, 이는 화소마다 모든 컬러 요소를 가지는 RGB 영상의 컬러 채널 방향 서브샘플링(subsampling)으로 생각할 수 있다. 그림 1(b)의 예시에서도 볼 수 있듯이, 로우 센서 데이터의 각 화소는 빛의 세기(intensity)를 나타내며 컬러 필터가 결합되어 색 정보를 표현한다.

그림 1(a) 예시와 같은 컬러 필터 배열을 가지고 있는 영상 센서가 생성한 로우 데이터는 카메라 내 영상처리 프로세싱 파이프라인(camera processing pipeline)을 통해 RGB 영상으로 변환된다. 일반적인 카메라 프로세싱 파이프라인은 화소마다 완전하지 않은 컬러 정보를 주변 정보를 이용하여 완전한 정보로 구성하기 위한 디모자이킹(demosaic-king), 색 보정(color correction), 화이트 밸런스(white balance), 감마 보정(gamma correction), 잡음 제거(noise suppression) 등과 같은 알고리즘으로 구성된다.

2. 학습 데이터

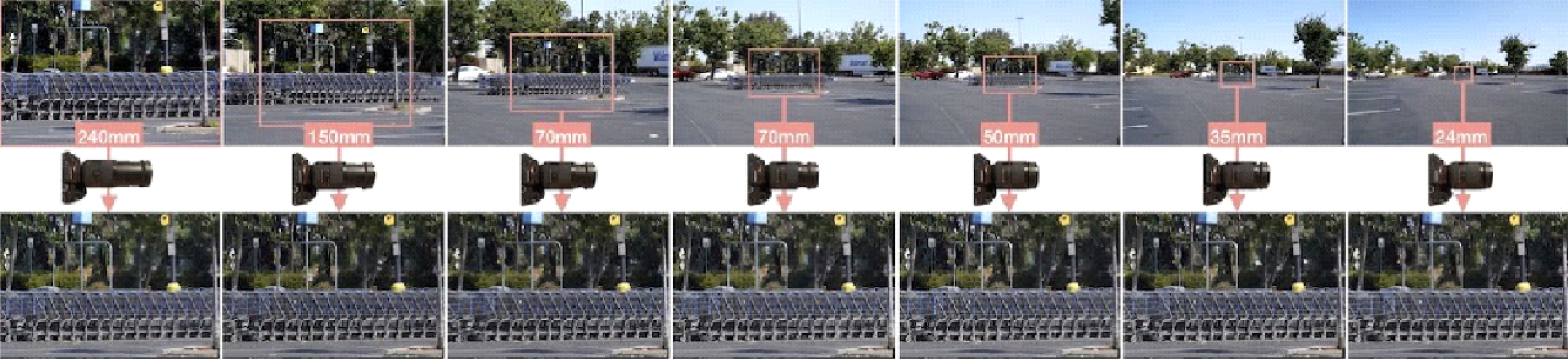

본 논문에서 제안하는 신경망 학습을 위해서는 II-2장에서 소개한 SR-RAW 데이터를 사용한다[27]. SR-RAW 데이터는 그림 2의 예시와 같이, 같은 영역을 24-240mm 줌렌즈의 초점 거리를 변경하여 촬영한 후, 짧은 초점 거리에서 촬영한 로우 센서 데이터를 저해상도 입력으로, 긴 초점 거리에서 촬영한 컬러 영상을 목표로 하는 고해상도 출력(ground-truth) 쌍으로 정의한다. 각 저해상도, 고해상도 영상 쌍은 그림 1과 같이 실내 혹은 야외에서 촬영한 7장의 영상으로 구성되어 있으며, 총 500개의 장면을 포함하고 있다.

위와 같은 방식으로 촬영한 영상은 그림 1의 예시에서 보는 바와 같이, 짧은 초점 거리에서 촬영한 영상이 긴 초점 거리에서 촬영한 영상보다 넓은 영역을 포함한다. 따라서, 본 논문에서는 저해상도 로우 센서 영상과 고해상도 컬러 영상을 학습 데이터 쌍으로 사용하기 위하여 짧은 초점 거리에서 촬영한 영상들을 가장 긴 초점 거리에서 촬영한 영상과 동일한 영역만을 포함하도록 잘라낸 후 사용한다. 그러나 영상을 잘라낸 후에도 학습 데이터 쌍이 기하학적으로 정확하게 정렬되지 않으므로, 영상 간의 유사도가 최대화되도록 변형 상관 계수 최대화(enhanced correlation coefficient maximization) 알고리즘[30]을 사용하여 비정렬(misalignment) 상태를 보상한다. 또한, 비정렬 상태 보완 후에도 입력 쌍이 완벽하게 정렬되지 않으므로 학습 과정 중에도 CoBi(Contextual Bilateral) 손실함수를 사용하여 화소 간 정렬을 보상한다. 그러나 해당 논문에서 사용한 비정렬 문제 해결 방안만으로는 대응쌍 간의 완벽한 정렬을 보장할 수 없으며, 데이터셋의 불완전성으로 인하여 기존 알고리즘과의 성능 비교를 어렵게 하는 한계점이 존재한다.

따라서, 위와 같은 데이터의 불완전성 문제를 해결하고자, 본 논문에서는 240mm 초점 거리에서 촬영한 높이가 H, 너비가 W인 로우 센서 데이터 Xr ∈ ℝH×W만을 활용하여 입력과 출력 Xt ∈ ℝH×W×3 데이터 쌍을 생성한다. 다양한 크기의 저해상도 입력 영상을 생성하기 위하여, 로우 센서 데이터 Xr에 컬러 채널을 분리하기 위한 함수 fs( ● )을 적용하여 입력 영상 Xc ∈ ℝH/2×W/2×4을 생성하며,

(1)에서 생성한 Xc에 다운샘플링(downsampling) 함수 fd( ● )를 적용하여 크기를 4배, 8배 줄인 입력 데이터 Xi를 생성한다 (그림 1 참조).

또한, 출력 데이터 Xt는 로우 센서 데이터 Xr을 RGB 영상으로 변환하여 생성한다.

3. 네트워크 구조

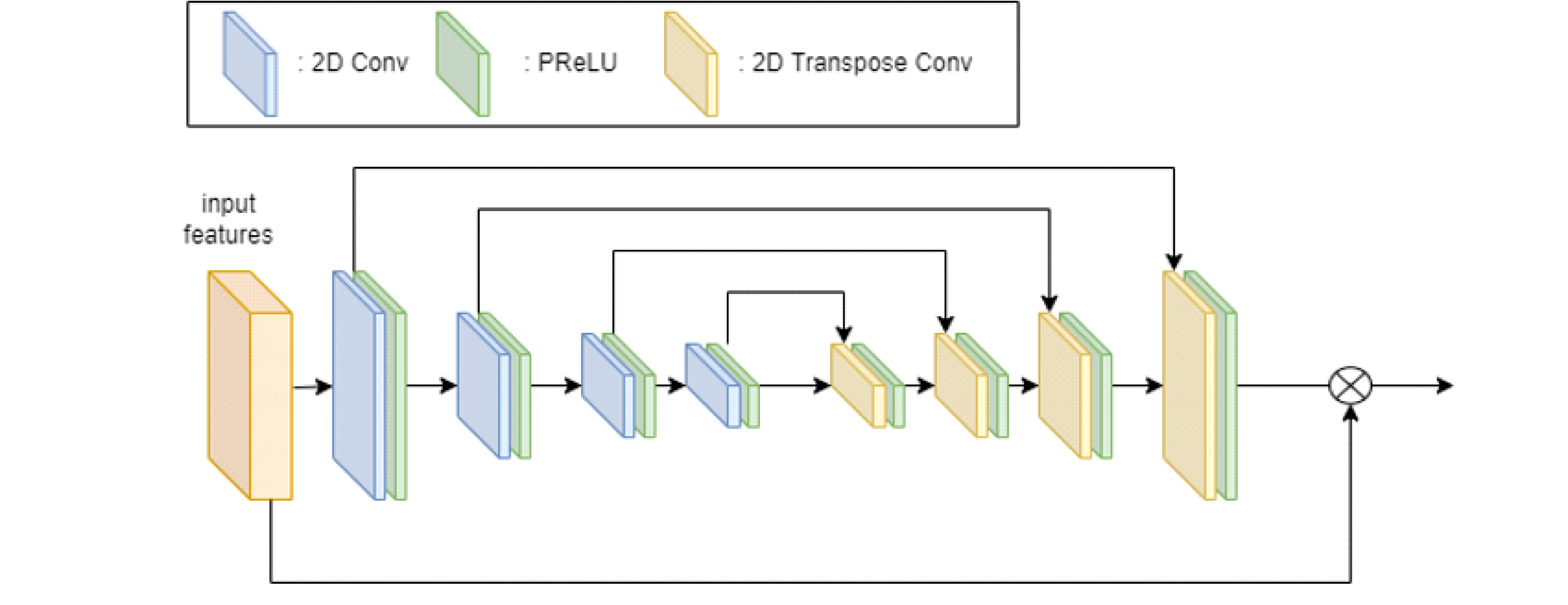

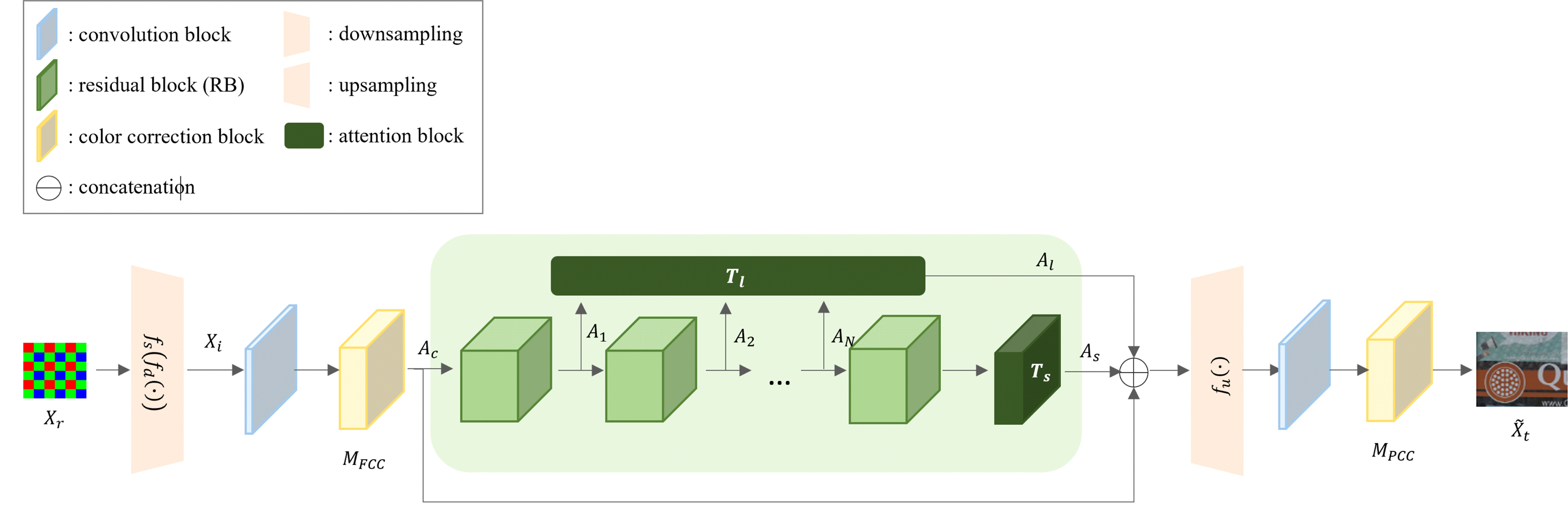

III-1장에서 기술한 바와 같이 센서에서 획득한 로우 센서 데이터는 카메라 내 영상처리 프로세싱 파이프라인을 통해 RGB 영상으로 변환된 후, 비선형적으로 색상, 명도, 채도 등을 보정하는 과정을 통해 시각적으로 보다 좋은 품질의 RGB 영상으로 렌더링된다. 이와 같은 비선형적 색상 보정 과정을 딥러닝으로 구현하기 위하여 기존의 연구들은 생성된 초고해상도 영상에 보정 상수를 곱해 컬러를 복원하거나[27], 해상도를 증가하는 과정과 분리하여 수행하는 방식[28]을 사용한다. 그러나 본 논문에서는 저해상도 로우 센서 데이터를 종단간 학습(end-to-end learning) 방법을 통해 초고해상도 RGB 영상으로 변환하기 위하여 컬러 보정 모듈(corrector module)을 활용하는 그림 3과 같은 방식을 제안한다.

제안하는 로우 센서 데이터를 이용한 초고해상화 신경망 그림 3과 같은 구조로 이루어진다. 제안하는 신경망은 로우 센서 데이터를 입력으로 사용하여 컬러 채널이 분리된 (2)를 합성곱 층을 통과시켜 특징을 추출한 후, 추출된 특징 텐서(tensor)를 로우(raw) 레벨에서의 컬러 센서 별 신호 세기 균형을 위한 전단 컬러 보정 모듈(front color corrector module) MFCC의 입력으로 사용한다. 전단 컬러 보정 모듈은 주어진 입력값에 추정된 컬러 보정 행렬 θFCC을 곱하여 식 (4)와 같이 다음 출력으로 반환하며, 이때, θFCC의 크기는 입력되는 미니 배치 크기에 이미지 또는 피쳐맵의 채널수를 곱하여 결정한다.

제안하는 로우 센서 데이터를 이용한 초고해상화 신경망 구조Fig. 3. Proposed Corrector-Attention Network (CA-Net) architecture for raw sensor data

전단 컬러 보정 모듈 MFCC은 그림 4의 구조와 같이 특징맵 conv(Xi)를 입력으로 받아 합성곱 층, PReLU(Parametric Rectified Linear Unit), 평균 풀링(average pooling)을 통해 정보를 압축한 후, 트랜스포즈드 합성곱(transposed convolution)을 통해 추정된 컬러 N보정 행렬이 곱해진 특징맵을 생성한다. 이후, 컬러 보정 모듈을 통해 생성된 특징맵은 식 (5)왁 같이 순차적으로 N개의 잔차 블록(residual block)을 통과한 후,

어텐션 블록(attention block)으로 구성된 심층 합성곱 층을 통하여 층간 기여도를 반영한 특징맵 Al과 공간간, 채널간 기여도를 반영한 특징맵 As으로 생성된다[16][18].

(7)에서 생성된 특징맵은 고해상도 영상 생성을 위한 샘플링 fu 모듈을 통과한 후 화이트 밸런스와 같은 컬러 보정을 위하여 후단 컬러 보정 모듈(post color corrector module) MPCC을 통과한 후 최종적인 초고해상도 영상 Xt으로 생성된다.

이와 같이, 제안하는 로우 센서 데이터를 사용한 초고해상도 신경망은 배치 크기가 B일 때, 아래와 같은 손실 함수 L을 사용하여 학습한다.

Ⅳ. 연구 결과

1. 실험 설정

기본적으로 네트워크의 hyper-parameter 값들은 SR연구 중 SOTA 성능을 내는 HAN(Niu et al., 2020)의 실험에서 사용한 설정을 따라서 20개 residual group에 10개, residual block으로 네트워크 깊이를 맞췄다. 학습을 위한 입력 patch size는 96으로 하였고 미니배치크기(minibatch size)는 12개로 설정하였으며, x2, x3, x4, x8 배율로 SR-RAW 데이터를 학습용과 평가용으로 나눠서 준비하였다. 로우 영상을 읽고 후처리(post-processing)하기 위해서는 rawpy 라이브러리를 사용하였으며, 네트워크 입력을 위한 데이터로더(dataloader)에서 해당 라이브러리를 이용해서 로우 영상을 읽고 처리하면 모델의 학습속도가 떨어지기 때문에 이를 npz 파일로 미리 데이터 세트를 준비하여 1 에폭(epoch)당 2927개 학습 데이터를 입력하였으며, 평가용으로는 337개 영상을 사용하여 학습과 평가를 하였다. Adam optimizer를 0.9, 0.999로 각각 β1, β2, 로 설정하였고 학습률(learning rate)를 10-4로 시작하여 10-8까지 80, 150, 200, 230 epoch 마다 10-1씩 감소시켜가면서 총 250epoch를 학습하였다. 학습 하드웨어는 Intel i9 CPU에 RTX 3090 GPU를 사용하여 1.19sec/it의 속도로 초고해상도 스케일마다 10시간 정도의 학습시간이 들었다.

2. 실험 결과

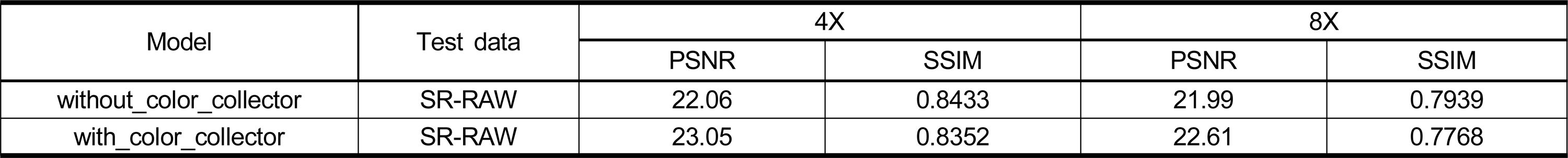

일반적인 초고해상도 연구에서 사용하고 있는 최대 신호대잡음비(PeakSignal-to-noise ratio, PSNR), 영상 구조 유사성 지수(structural similarity index measure, SSIM)를 기준으로 성능을 측정하였으며, 색상 보정 모듈이 있을 때와 없는 경우를 실험하여 결과를 비교하였다. 결과는 표 1과 같다.

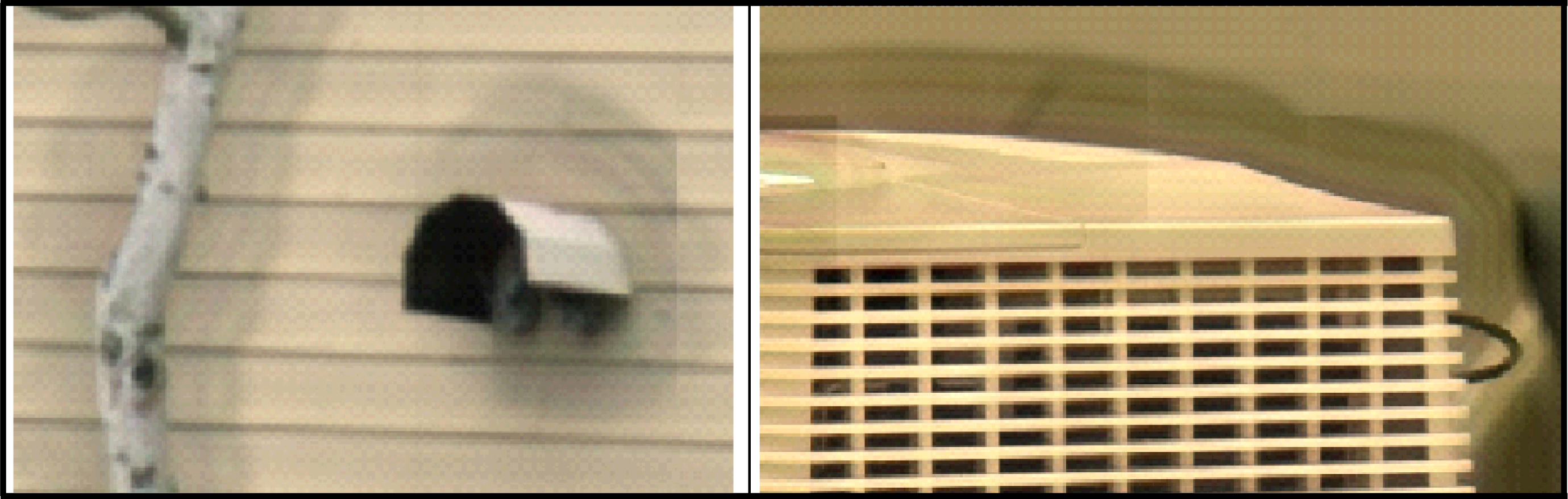

표 1에서 보는 것처럼 색상 보정 모듈을 사용하는 경우, PSNR에서 4X, 8X 스케일 모두 높은 성능을 나타내었다. 반면, SSIM은 오히려 색상 보정 모듈이 있는 경우에 색상 보정 모듈을 사용하지 않는 경우보다 지표가 낮게 나오는 것을 확인하였다. 이런 결과가 나타나는 이유는 색상 보정 모듈을 거치면서 밝기(brightness)가 조정되거나 네트워크가 깊어지면서 산출 이미지가 흐려지는(blurring)되는 이유인 것으로 추정된다. 하지만 SSIM의 성능 차이가 미미하여 출력된 결과 이미지만을 비교하여서는 정확한 원인을 찾을 수 없었다.

성능 결과 지표의 비교. 본 연구에서 SR-RAW 데이터를 대상으로 하는 연구의 성능 결과 지표를 PSNR, SSIM 지표에 대해 비교한 결과Table 1. Performance matric table shows precedent raw sensor images SR results. And comparing performance metric between with and without color collector module.

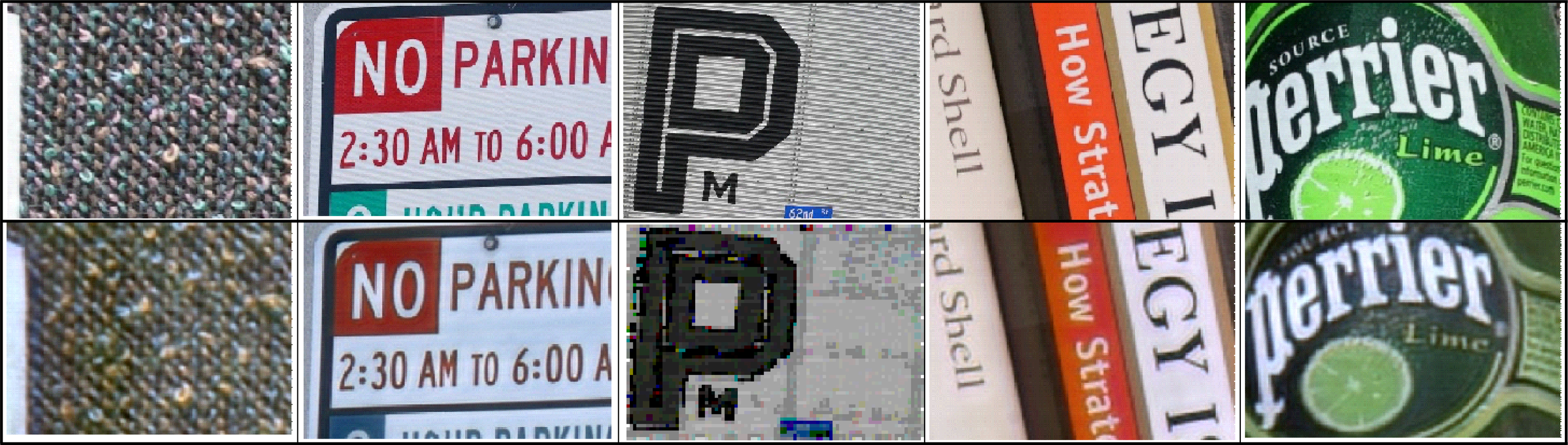

위열은 ground truth인 RGB 영상에서 특정 영역 확대한 패치, 아래열은 본 연구에서 만들어낸 4배 SR RGB 영상Fig. 5. First line is ground truth HR RGB images, below is output x4 SR RGB images from out network

Ⅴ. 결 론

본 연구에서는 로우 센서 영상을 입력 영상으로 활용할 수 있는 초해상화 네트워크를 제시하고 이를 실험하였다. 로우 센서 영상을 일반 RGB 영상처럼 네트워크 안에서 초해상화가 가능하도록 하기 위하여 색상 보정 모듈을 제안하였으면, 이를 토대로 색상 보정 모듈이 유무에 따른 성능 변화를 확인하였다. 다만, 본 실험에서 모델을 통해 출력된 영상 결과물이 ground truth인 초고해상도 RGB영상과 비교하여 색상 보정 모델의 사용에도 불구하고 일부 밝기(brightness)가 달라서 전체적인 색감이 다르게 보이는 문제가 발생하였으나 이에 대한 원인을 찾아내고 보완하지는 못하였다. 또한 색상 보정 모듈 사용 시에 PSNR 성능 지표가 향상됨에도 SSIM 지표가 더 낮게 나오는 이유를 명확히 밝히지 못하였다. 추후 연구에서 이러한 원인을 찾는 방향으로 연구를 진행하고자 한다.

Notes

References

- NITRE, (2022), Online, Available: https://data.vision.ee.ethz.ch/cvl/ntire22/.

-

Yuan, Q., Zhang, L., Shen, H., Regional Spatially Adaptive Total Variation Super-Resolution With Spatial Information Filtering and Clustering, IEEE Transactions on Image Processing, (2013), 22(6), p2327-2342.

[https://doi.org/10.1109/TIP.2013.2251648]

-

Mairal, J., Bach, F., Ponce, J., Sapiro, G., Zisserman, A., Non-local sparse models for image restoration, IEEE International Conference on Computer Vision (ICCV), (2009), p2272-2279.

[https://doi.org/10.1109/ICCV.2009.5459452]

-

Wang, Z., Liu, D., Yang, J., Han, W., Huang, T., Deep Networks for Image Super-Resolution with Sparse Prior, IEEE International Conference on Computer Vision (ICCV), (2015), p370-378.

[https://doi.org/10.1109/ICCV.2015.50]

-

Dong, C., Loy, C. C., He, K., Tang, X., Learning a Deep Convolutional Network for Image Super-Resolution, European Conference on Computer Vision (ECCV), (2014), p184-199.

[https://doi.org/10.1007/978-3-319-10593-2_13]

-

Dong, C., Loy, C. C., He, K., Tang, X., Image Super-Resolution Using Deep Convolutional Networks, IEEE Transactions on Pattern Analysis and Machine Intelligence, (2016), 38(2), p295-307.

[https://doi.org/10.1109/TPAMI.2015.2439281]

-

Kim, J., Lee, J. K., Lee, K. M., Accurate Image Super-Resolution Using Very Deep Convolutional Networks, IEEE Conference on Computer Vision and Pattern Recognition (CVPR), (2016), p1646-1654.

[https://doi.org/10.48550/arXiv.1511.04587]

-

He, K., Zhang, X., Ren, S., Sun, J., Deep residual learning for image recognition, IEEE Conference on Computer Vision and Pattern Recognition (CVPR), (2016), p770-778.

[https://doi.org/10.48550/arXiv.1512.03385]

-

Kim, J., Lee, J. K., Lee, K. M., Deeply-Recursive Convolutional Network for Image Super-Resolution, IEEE Conference on Computer Vision and Pattern Recognition (CVPR), (2016), p1637-1645.

[https://doi.org/10.48550/arXiv.1511.04491]

-

Mao, X.-J., Shen, C., Yang, Y., Image Restoration Using Convolutional Auto-encoders with Symmetric Skip Connections, (2016), A journal extension of the version at arXiv:1603.09056.

[https://doi.org/10.48550/arXiv.1606.08921]

-

Ledig, C., Theis, L., Huszár, F., Caballero, J., Cunningham, A., Acosta, A., Aitken, A., Tejani, A., Totz, J., Wang, Z., Shi, W., Photo-Realistic Single Image Super-Resolution Using a Generative Adversarial Network, IEEE Conference on Computer Vision and Pattern Recognition (CVPR), (2017), p105-114.

[https://doi.org/10.48550/arXiv.1609.04802]

-

Huang, G., Liu, Z., Maaten, L., Weinberger, K., Densely Connected Convolutional Networks, IEEE Conference on Computer Vision and Pattern Recognition (CVPR), (2018), p4700-4708.

[https://doi.org/10.48550/arXiv.1608.06993]

-

Tong, T., Li, G., Liu, X., Gao, Q., Image Super-Resolution Using Dense Skip Connections, IEEE International Conference on Computer Vision (ICCV), (2017), p4809-4817.

[https://doi.org/10.1109/ICCV.2017.514]

-

Anwar, S., Barnes, N., Densely Residual Laplacian Super-Resolution, IEEE Transactions on Pattern Analysis and Machine Intelligence, (2022), 44(3), p1192-1204.

[https://doi.org/10.48550/arXiv.1906.12021]

-

Vaswani, A., Shazeer, N., Parmar, N., Uszkoreit, J., Jones, L., Gomez, A., Kaiser, Ł., Polosukhin, I., Attention is all you need, Advances in Neural Information Processing Systems(NeurIPS), (2017).

[https://doi.org/10.48550/arXiv.1706.03762]

-

Zhang, Y., Li, K., Li, K., Wang, L., Zhong, B., Fu, Y., Image Super-Resolution Using Very Deep Residual Channel Attention Networks, European conference on computer vision (ECCV), (2018), p286-301.

[https://doi.org/10.48550/arXiv.1807.02758]

-

Dai, T., Cai, J., Zhang, Y., Xia, S., Zhang, L., Second-Order Attention Network for Single Image Super-Resolution, IEEE Conference on Computer Vision and Pattern Recognition (CVPR), (2019), p11057-11066.

[https://doi.org/10.1109/CVPR.2019.01132]

-

Niu, B., Wen, W., Ren, W., Zhang, X., Yang, L., Wang, S., Zhang, K., Cao, X., Shen, H., Single Image Super-Resolution via a Holistic Attention Network, European Conference on Computer Vision (ECCV), (2020), p191-207.

[https://doi.org/10.48550/arXiv.2008.08767]

-

Mei, Y., Fan, Y., Zhou, Y., Huang, L., Huang, T., Shi, H., Image Super-Resolution with Cross-Scale Non-Local Attention and Exhaustive Self-Exemplars Mining, IEEE Conference on Computer Vision and Pattern Recognition (CVPR), (2020), p5690-5699.

[https://doi.org/10.48550/arXiv.2006.01424]

-

Shi, W., Caballero, J., Huszár, F., Totz, J., Aitken, A. P., Bishop, R., Rueckert, D., Wang, Z., Real-Time Single Image and Video Super-Resolution Using an Efficient Sub-Pixel Convolutional Neural Network, IEEE Conference on Computer Vision and Pattern Recognition (CVPR), (2016), p1874-1883.

[https://doi.org/10.48550/arXiv.1609.05158]

-

Dong, C., Loy, C. C., Tang, X., Accelerating the Super-Resolution Convolutional Neural Network, European Conference on Computer Vision (ECCV), (2016), p391-407.

[https://doi.org/10.48550/arXiv.1608.00367]

-

Lai, W., Huang, J., Ahuja, N., Yang, M., Deep Laplacian Pyramid Networks for Fast and Accurate Super-Resolution, IEEE Conference on Computer Vision and Pattern Recognition (CVPR), (2017), p624-632.

[https://doi.org/10.48550/arXiv.1704.03915]

-

Tai, Y., Yang, J., Liu, X., Xu, C., MemNet: A Persistent Memory Network for Image Restoration, IEEE International Conference on Computer Vision (ICCV), (2017), p4549-4557.

[https://doi.org/10.48550/arXiv.1708.02209]

-

Han, W., Chang, S., Liu, D., Yu, M., Witbrock, M., Huang, T. S., Image Super-Resolution via Dual-State Recurrent Networks, IEEE Conference on Computer Vision and Pattern Recognition (CVPR), (2018), p1654-1663.

[https://doi.org/10.48550/arXiv.1805.02704]

-

Haris, M., Shakhnarovich, G., Ukita, N., Deep Back-Projection Networks for Super-Resolution, IEEE Conference on Computer Vision and Pattern Recognition (CVPR), (2018), p1654-1663.

[https://doi.org/10.48550/arXiv.1803.02735]

-

Li, Z., Yang, J., Liu, Z., Yang, X., Jeon, G., Wu, W., Feedback Network for Image Super-Resolution, IEEE Conference on Computer Vision and Pattern Recognition (CVPR), (2019), p3862-3871.

[https://doi.org/10.48550/arXiv.1903.09814]

-

Zhang, X. C., Chen, Q., Ng, R., Koltun, V., Zoom to Learn, Learn to Zoom, IEEE Conference on Computer Vision and Pattern Recognition (CVPR), (2019), p3757-3765.

[https://doi.org/10.48550/arXiv.1905.05169]

-

Xu, X., Ma, Y., Sun, W., Yang, M.-H., Exploiting Raw Images for Real-Scene Super-Resolution, IEEE Transactions on Pattern Analysis and Machine Intelligence, (2022), 44(1), p1905-1921.

[https://doi.org/10.48550/arXiv.2102.01579]

-

Lee, Y., Hirakawa, K., Lossless White Balance for Improved Lossless CFA Image and Video Compression, IEEE Transactions on Image Processing, (2022), 31, p3309-3321.

[https://doi.org/10.48550/arXiv.2009.09137]

-

Evangelidis, G. D., Psarakis, E. Z., Parametric Image Alignment Using Enhanced Correlation Coefficient Maximization, IEEE Transactions on Pattern Analysis and Machine Intelligence, (2008), 30(10), p1858-1865.

[https://doi.org/10.1109/TPAMI.2008.113]

-

Xuan, Xu, Li, Xin, Scan: Spatial color attention networks for real single image super-resolution, IEEE Conference on Computer Vision and Pattern Recognition Workshop (CVPRW), (2019).

[https://doi.org/10.1109/CVPRW.2019.00254]

신 바 울

- 2020년 3월 ~ 현재 : 서울과학기술대학교 스마트에너지시스템공학과 석사과정

- 2021년 11월 ~ 현재 : ㈜크레이지알파카 소프트웨어 엔지니어

- 주관심분야 : Computer Vision컴퓨터 비전, Recommender System추천 시스템

김 태 하

- 2020년 2월 : 서울과학기술대학교 전기정보공학과 공학사

- 2020년 2월 ~ 2022년 8월 : 서울과학기술대학교 전기정보공학과 석사과정

- 2020년 5월 ~ 현재 : LG전자

- 주관심분야 : 컴퓨터 비전, 영상 처리, 기계 학습

이 의 진

- 2017년 9월 : 미국 University of California, San Diego 전기컴퓨터공학과 공학박사

- 2017년 ~ 2018년 : 미국 University of California, Los Angeles Postdoctoral Fellow

- 2018년 ~ 현재 : 서울과학기술대학교 조교수

- 주관심분야 : 컴퓨터 비전, 기계 학습